IS-O CONSULTING

Unternehmensberatung zur IT-Unternehmens-Nutzen/Kosten-Optimierung

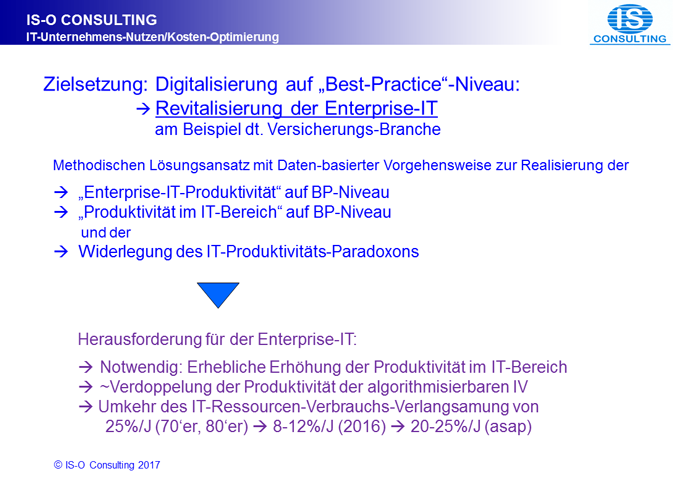

Digitalisierung auf Best-Practice-Niveau

Am Beispiel der deutschen Versicherungsbranche

Zielsetzung:

Überwindung der Lähmung des Produktivitäts-Fortschrittes der Enterprise-IT

Methodischer Lösungsansatz mit Daten-basierter Darstellung der

- Enterprise-IT-Produktivität auf BP-Niveau

- Widerlegung des IT-Produktivitäts-Paradoxons

- Produktivität im IT-Bereich auf BP-Niveau

- Produktivitäts-Unterschiede der Computer-Architekturen

- Zusammenfassung für Entscheider

- Architektur unserer Enterprise-IT „Best-Practice-Realisierung”

- Präsentations-Form

- Abhandlungs-Form

- Herausforderung: Produktivitäts-Messung des IT-Einsatzes in den Unternehmen

- Bedeutung des IT-Branchen-Segments „Enterprise-IT“

- Versäumnisse im IT-Branchen-Segments „Enterprise-IT

- Bisheriges Marketing mittels „IT-Kosten-Maßstab“ und neuer „Holistischer IT-Unternehmens-Nutzen/Kosten-Maßstab“

- IT-Kosten als komplementäre IT-Nutzen-Mess-Größe?

- Unser neuer Methodischer Lösungsansatz: „Holistischer IT-Unternehmens-Nutzen/Kosten-Maßstab“

- „Enterprise-IT-Produktivität“ auf „Best-Practice“-Niveau

- Lösungstheorie

- Maßstäbe zum Messen der „Produktivität der Enterprise-IT“

- Diskussion der Ergebnisse der „Enterprise-IT-Produktivität“

- Widerlegung des „IT-Produktivität-Paradoxons“

- Realisierung der „Enterprise-Digitalisierung auf Best-Practice-Niveau“

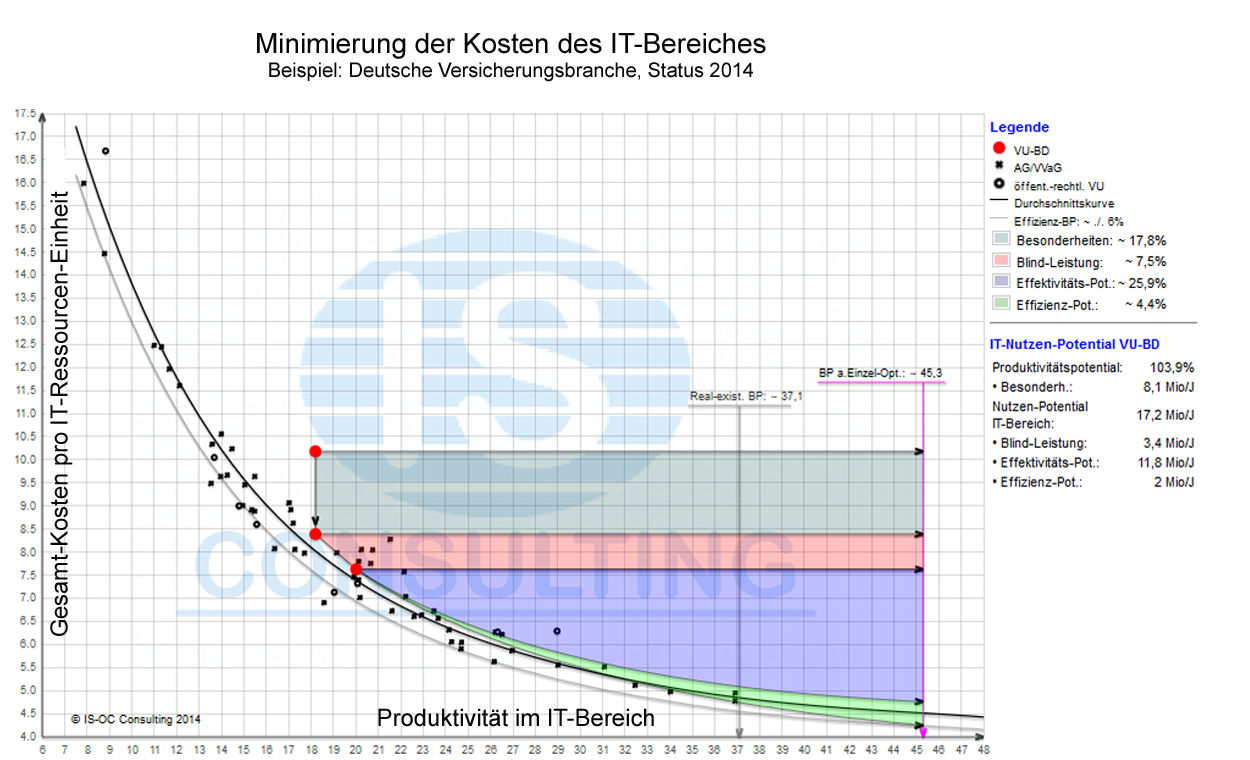

- „Produktivität im IT-Bereich“ auf „Best-Practice-Niveau“

- Maßstäbe zum Messen der „Produktivität im IT-Bereich“

- Produktivitäts-Unterschiede der Computer-Architekturen: Fehlentwicklungen und Lösungs-Empfehlungen

- Realisierung der „Produktivität des IT-Bereichs auf Best-Practice-Niveau“

- Unterstützung durch IS-O Consulting

- Einordnung dieses Themas in das IS-OC Consulting Know-how-Portfolio und die Bedeutung für die IT-Branche

- Kommunikation

Zusammenfassung für Entscheider

„You can see the computer age everywhere but in the productivity statistics.“ Statement von Herrn Robert Solow, Wirtschafts-Nobel-Preisträger im Jahre 1987? Diese Beurteilung der Bedeutung der sogenannten Digitalisierung, die unter dem Schlagwort „Produktivitäts-Paradoxon der IT“ in die „Bewertung des Nutzens der IT“ eingegangen ist und noch immer auch von vielen namhaften IT-Wissenschaftlern geteilt wird, ist dennoch, auf den Punkt gebracht, eine „atemberaubende Fehldiagnose“. Eine qualifizierte, Theorie- und Daten-basierte Analyse kann das mit absoluter Eindeutigkeit beweisen und wird von uns nachfolgend dargestellt. Was Herr Solow, übrigens Volkswirtschaftler, offensichtlich nicht erkannt hatte und seine Anhänger anscheinend noch immer nicht verstanden haben: Als Ergebnis einer Steigerung der Human-Produktivität durch erhöhten Computer-Einsatz ergibt sich de facto immer eine Verringerung der Kosten pro Leistungs- oder Output-Einheit und damit eine „Verringerung der gesamten Kosten in den Unternehmen“! Übertragen auf die Volkswirtschaft ergibt sich somit eine „Verringerung gemessen mit dem volkswirtschaftlichen Maßstab BIP!“ Bei einer präzisen Messung mit einem geeigneten Maßstab hätte dieser Zusammenhang zutage treten müssen, was aber, nach unserem Erkenntnisstand, 1987 mit dem Maßstab BIP noch kaum möglich war. Eine qualifizierte Maßstab-Analyse, wie in den Naturwissenschaften üblich, hätte dies aber zutage gefördert. Da wird man unwillkürlich daran erinnert, dass schon Herr Nobel die Ökonomie nicht als Wissenschaft hat gelten lassen und deshalb keinen Nobel-Preis für Ökonomie gestiftet hat. Die Erfolglosigkeit aufgrund eines ungeeigneten Ansatzes aber als Paradoxon zu verschleiern ist leider typische US-Amerikanische Rhetorik, im „Zeitalter von Donald Trump“ könnte man sagen „eine alternative Erkenntnis“.

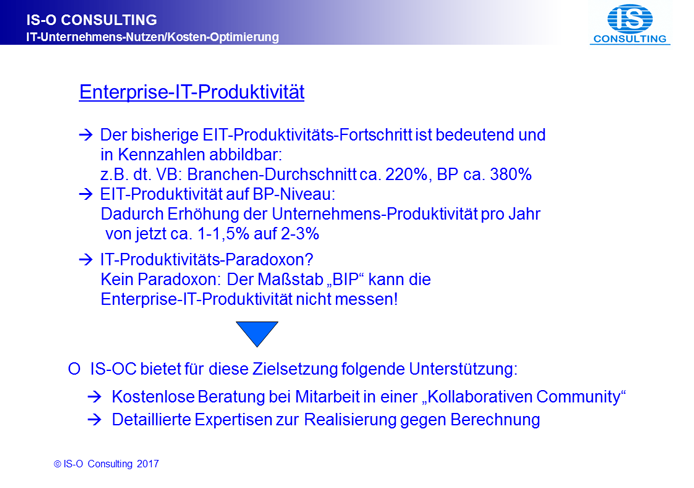

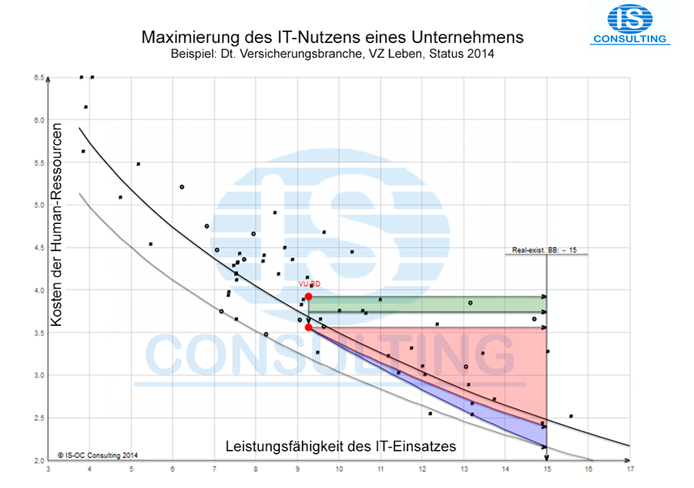

Dass die „volkswirtschaftliche Produktivität“ anderen Gesetzmäßigkeiten folgt als die „betriebswirtschaftliche Produktivität“ ergibt sich schon aus den Erkenntnissen des berühmten Ökonomen David Ricardo, die er vor etwa 200 Jahren entwickelt hat. Daraus folgt auch, dass die betriebswirtschaftliche Produktivität nicht mit volkswirtschaftlichen Maßstäben gemessen werden kann. In dieser Einführung wollen wir deshalb nicht nur den von uns entwickelten und in der Praxis bewährten „Ansatz zur methodisch korrekten Produktivitäts-Messung der Enterprise-IT (EIT)“ in den Unternehmen offenlegen und die damit erzielten Ergebnisse für jedermann nachvollziehbar machen, sondern auch die noch wichtigeren Erkenntnisse abhandeln, die aus unserer Daten-basierten Analyse gezogen werden können, insbesondere die Erkenntnis über die „Realisierung der IT-Produktivität in den Unternehmen auf Best-Practice-Niveau!“ Zum Beispiel haben in der deutschen Versicherungsbranche Versicherungsunternehmen auf „Best-Practice-Niveau“ bereits eine um ca. 130% bessere Produktivität als VU auf dem Niveau der „Worst-Practice“ ( &# 11016; 1). Durch eine lückenlose Rückverfolgung bis ins Jahr 1990 und eine seriöse weitere Extrapolation anhand qualifizierten Datenmaterials bis in die 60’er Jahre liefert unser Methodischer Lösungsansatz darüber hinaus die Erkenntnis, dass die deutsche Versicherungs-Branche bisher im Durchschnitt einen Produktivitäts-Fortschritt von ca. 220% und bei den Best-Practice sogar um ca. 380% erzielt hat!

Diese Produktivitäts-Steigerung ist, wie IT-Fachleuten gut vertraut ist, während der gesamten bisherigen Entwicklung der Unternehmens-IT kontinuierlich aufgetreten und in "lokalen Business Cases" überzeugend dokumentiert worden. Diese lokalen Business Cases waren bekanntlich die wesentliche Begründung für die ebenfalls kontinuierlich steigenden EIT-Ausgaben. Die Herausforderung einer EIT-Produktivitäts-Darstellung besteht aber darin, dass man bei dieser Zielsetzung die Einzel-Ergebnisse der lokalen Business Cases nicht einfach aufaddieren kann: Denn bei einem Hinzufügen einer neuen Anwendung in ein Multi-Anwendungs-Umfeld handelt es sich „mit Nichten um eine triviale Addition“ sondern um „eine herausfordernde Integration“, ähnlich wie bei einem Hinzufügen eines kleinen Unternehmens zu einem großen, mit „Synergie-Effekten“, „Skalen-Vorteilen“, usw. Auch diesen Aspekt werden wir noch ausführlich erläutern.

Diese Situation führt, konsequent zu Ende gedacht, zu der Frage, warum es in der Vergangenheit anscheinend keine ausgeprägten Bemühungen gab, die EIT-Produktivität in einem gesamten Unternehmen in einer Kennzahl abzubilden? Die Antwort ist nach unserer langjährigen Erfahrung in der IT-Branche so einfach wie ernüchternd: Weil es keine zwingende Notwendigkeit dazu gab, weder bei den Computer-Herstellern noch beim IT-Management der Unternehmen. Hinzu kommt, dass Entscheidungs-starke Erkenntnisse, wie Best-Practice-Erkenntnisse, nur auf Branchen-Basis möglich sind, was ansatzweise beim GDV (Gesamtverband der Deutschen Versicherungswirtschaft) versucht worden ist, allerdings mit viel zu gering qualifizierten Mitarbeitern. Der Vollständigkeit halber soll natürlich auch die dritte Kompetenz-Einrichtung im Informationsverarbeitungs-Umfeld, die Universitäts-Informatik, kurz gestreift werden: Dieser 3. Alternative fehlt, nach unserer ebenfalls vorhandenen Erfahrung durch die Betreuung der IT deutscher Universitäten, sowohl das unbedingt notwendige qualitativ hochwertige IT-Datenmaterial als auch höchst wahrscheinlich die praktische Erfahrung.

wobei ca. 80% IT-Produktivitäts-Nutzen ist.

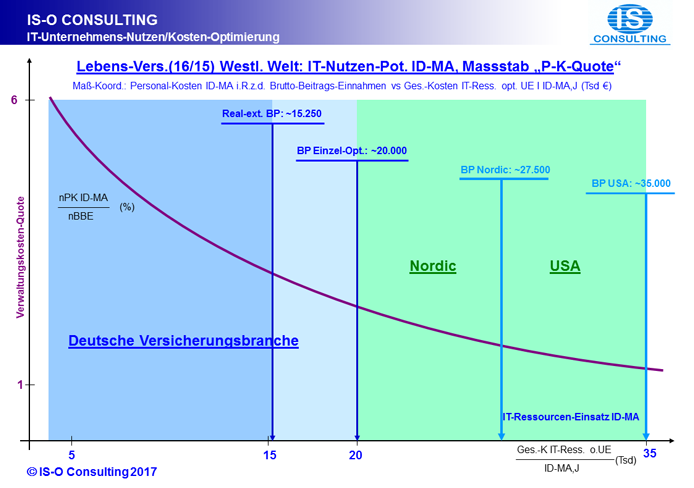

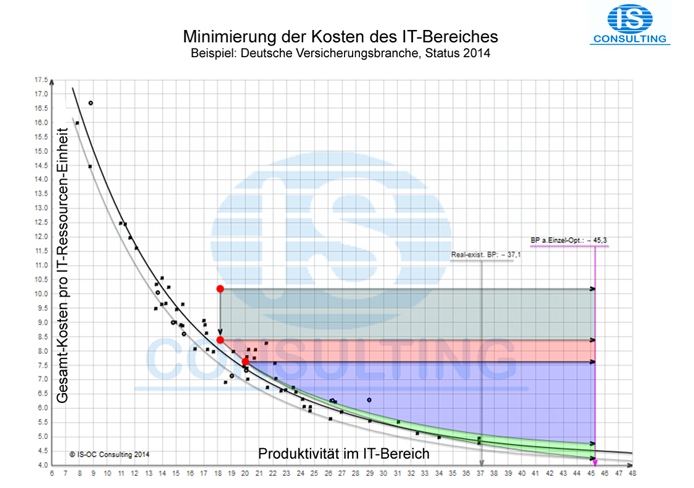

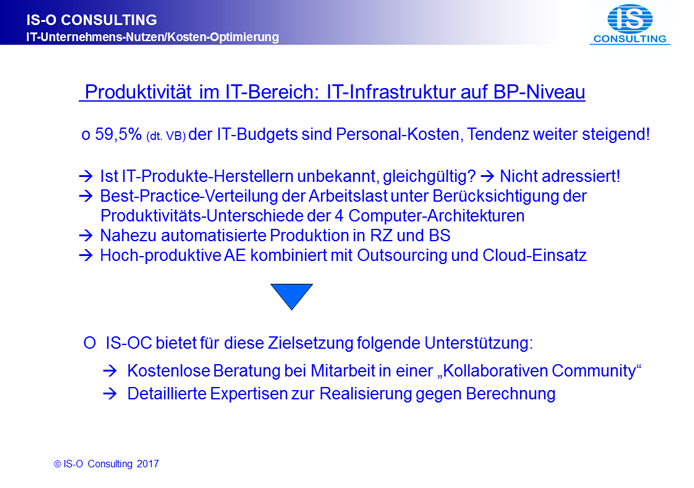

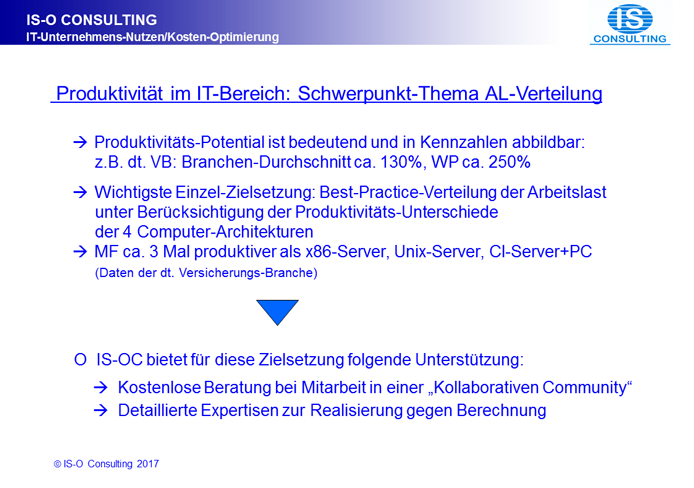

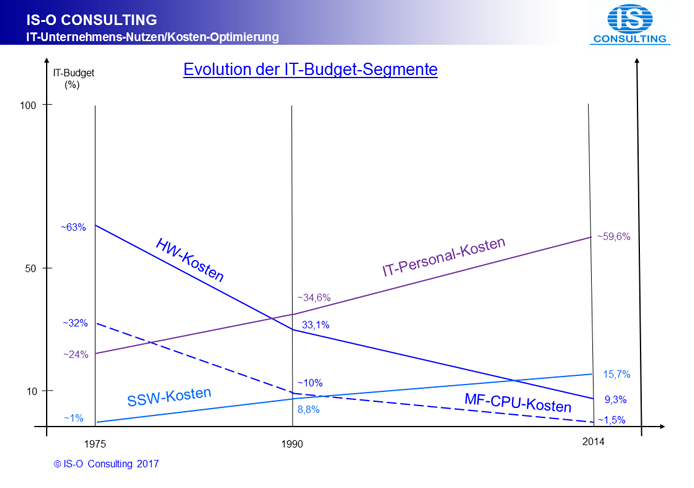

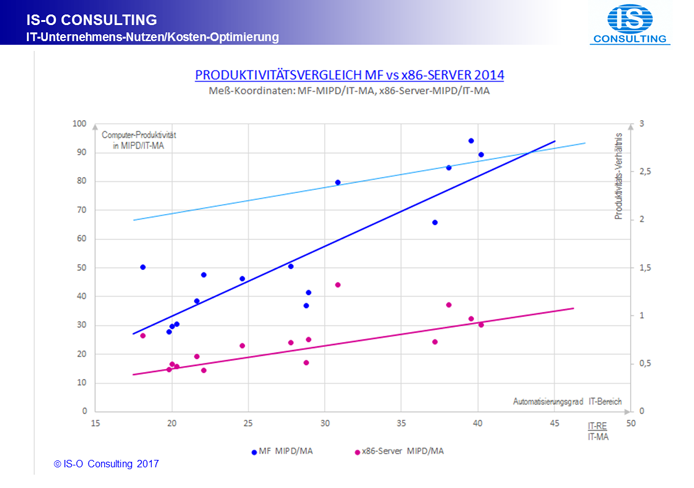

In der Vergangenheit herrschte die allgemeine Überzeugung vor, dass die Produktivität der Unternehmens-IT v.a. von der Leistungsfähigkeit der eingesetzten Computer, viel weniger bedeutend von der Leistungsfähigkeit der Funktionalität der Software abhängt. Kennzahlen wiederum Fehlanzeige! Diese sehr vereinfachte Gleichung war in IT-Zeiten, in denen die Leistung der Unternehmens-IT fast ausschließlich von Mainframes produziert wurde, wie dies bis Anfang der 90’er Jahre der Fall war, durchaus akzeptabel. Diese Zeitperiode ist aber längst abgelöst worden, natürlich wiederum evolutionär und damit eher unbemerkt, von einer „Leistungs-Produktion durch Multi-Architektur-Computer“. Da der Grund für die Entwicklung in Produktion der Unternehmens-Anwendungen mit Computern von gegenwärtig bis zu 4 Architekturen in der Markteinführung immer leistungsfähigerer, „spezialisierter Computer“ für „spezielle Anwendungen“ mit nach Hersteller-Marketing-Aussagen angeblich weit überlegenem Preis/Leistungs-Verhältnis verortet ist, stellt sich aus Unternehmenssicht inzwischen grundsätzlich auch die Frage nach dem besten Mischungs-Verhältnis der verschiedenen einsetzbaren Computer. Und weil die Anbieter dieser spezialisierten Computer, die de facto allesamt aus den USA stammen, nur Computer-System-Teilelemente, wie nur die Hardware- oder nur die Software-Elemente anbieten und dabei US-amerikanisches, "punktuelles Product-Excellence-Marketing" einsetzen, haben sie selbstverständlich nur ihr spezielles, taktisches Interesse im Auge. Um aber Produktivitäts-Einflüsse erkennen zu können, wenn man dies denn überhaupt will, bedarf es eines ganz anderen, ganzheitlichen, strategischen Blickes auf die Produktions-Prozesse der Unternehmens-IT, bestehend aus „HW“, „SW“, „IT-Personal in allen seinen Funktionsbeiträgen“ und den „Betrieb“! Über diesen notwendigen holistischen Blick verfügen, nach unserer langjährigen IT-Erfahrung, des Weiteren auch die wenigsten IT-Verantwortlichen in den Unternehmen, da sie ebenfalls i.d.R. „nur“ für IT-Teil-Aufgaben wie RZ, AE oder BS verantwortlich sind. Und da die Entwicklung der EIT-Infrastruktur, wie auch in der EIT allgemein üblich, evolutionär verläuft, blieb viel zu lange unerkannt, dass die scheinbar so preiswerten spezialisierten neuen Computer eine fundamentale Schwäche aufweisen, nämlich „die Schwäche der nur sehr geringen Produktions-Produktivität!“ Das ist im IT-Bereich des technisch/wissenschaftlichen Rechnens kein relevantes Thema, beim kommerziellen Einsatz dagegen eine „Killer-Größe“! Nach unserem umfangreichen Datenmaterial der deutschen Versicherungs-Branche beträgt der Produktivitäts-Unterschied für das Anwendungs-Portfolio der dt. VB zwischen den „Mainframe-Servern der IBM, bestückt mit IBM Betriebs-System-SW und IBM Key Branded Middleware“ einerseits und den „x86-Servern verschiedener Hersteller, bestückt mit einer Betriebs-System-SW verschiedener Hersteller und etwas Middleware verschiedener Hersteller“ i.d.R. Faktor 3 oder 200%! Und dies in einem IT-Bereichs-Produktions-Umfeld, in dem gegenwärtig bereits 59,3% des IT-Budgets Personal-Kosten sind mit weiter steigender Tendenz. Die wahre Bedeutung dieses Produktivitäts-Unterschiedes für die Unternehmen wird aber erst durch Kombination mit der weiteren Erkenntnis offen gelegt, dass die Produktivität im IT-Bereich in der dt. VB gegenwärtig mit etwa Faktor (4-6) auf den Produktivitäts-Fortschritt in den Unternehmen durchschlägt! Damit ist dieser Leistungsunterschied eine Entscheidungs-dominante Größe und keinesfalls ein „Phänomen der Kategorie Peanuts“.

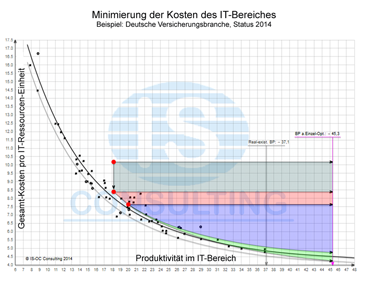

Zur speziellen Zielsetzung „Kosten sparen im IT-Bereich“ gibt es bekanntlich seit vielen Jahrzehnten eine eigene Sparte in der Beratungsbranche. Was aber kaum qualifiziert vorhanden ist, ist eine systematische Beratung zur inzwischen fundamental wichtigen Zielsetzung der „Produktivität des IT-Bereiches realisiert auf Best-Practice-Niveau“ der Unternehmen, mit der inzwischen hoch wichtigen Unterzielsetzung „Berücksichtigung der Produktivitäts-Unterschiede der verschiedenen Computer-Architekturen“. Das hat dazu geführt, dass der Einsatz der den Unternehmens-Produktivitäts-Fortschritt produzierenden Unternehmens-IT-Ressourcen von in den 70’er und 80’er Jahren des letzten Jahrhunderts ca. (20-25)% Steigerung pro Jahr auf inzwischen nur noch ca. (10-12)% Anstieg pro Jahr zurückgegangen ist, mit gravierenden Auswirkungen auf den Produktivitäts-Fortschritt der Firmen und natürlich auch der Staaten! Die inzwischen von allen Seiten beschworene Notwendigkeit einer raschen Digitalisierung in den westlichen Staaten zum Erhalt ihrer Wettbewerbsfähigkeit ist damit de facto Makulatur.

Diese Verlangsamung ist nach unserem umfangreichen IT-Datenmaterial v.a. auf die Verlagerung der Computer-Arbeitslast von den MF-Servern auf die angeblich viel billigeren „x86-Server“, „Unix-Server“ und „Clienten-Server + PC“ zurückzuführen. Diese für Spezial-Aufgaben ausgelegten Computer-Architekturen sind zwar scheinbar wesentlich billiger in der Anschaffung, verfügen aber allesamt über eine viel schlechtere „Computer-Produktivität“! Ihr verstärkter Einsatz führt nicht nur zu einer „Verringerung des Produktivitäts-Fortschritts der Unternehmens-IT“ sondern darüber hinaus auch zu einer relativen Erhöhung der IT-Kosten pro Output-Einheit, wie eine "IT-Voll-Kosten-Rechnung" offenbart! Die „Produktivitäts-Unterschiede in den IT-Bereichen können insgesamt z.B. in der dt. VB“ bis über Faktor 3,5 oder 250% erreichen mit gravierenden Auswirkungen auf die Realisierung der Unternehmens-Produktivität ( &# 11016; 2).

Die „Halbierung der Steigerung der eingesetzten Computer-Ressourcen pro Jahr“ in den Unternehmen hat höchstwahrscheinlich zu einer „Verringerung der Steigerung der Unternehmens-Produktivität um ebenfalls etwa die Hälfte“ geführt: D.h. zu einer eklatanten Lähmung des Produktivitäts-Fortschritt-Anteils durch die Enterprise-IT.

(Status 2014)

Architektur unserer „Enterprise-IT Best-Practice-Realisierung”

Dass die Enterprise-IT einen positiven Beitrag zum Unternehmens-Erfolg liefert, davon waren vom Anfang ihres Einsatzes ab dem Anfang der 50’er Jahre des letzten Jahrhunderts an Anwender wie Hersteller derart überzeugt, dass ein ökonomischer Nachweis in holistischen Unternehmens-Kennzahlen, wie die für die Produktionsfaktoren eingesetztes Kapital und benötigte Arbeitskräfte“ nicht erforderlich war. Die IT-Verantwortlichen in den Unternehmen führten den Nachweis mittels „lokaler Projekt Business Cases“ und die Computer-Hersteller aller Computer-Elemente-Variationen, von „singulären Computer-Elementen“, wie z.B. EMC zu Beginn seiner Existenz, bis zu den Anbietern „vollständiger Systeme“, wie insbesondere IBM, befeuerten den Hype bei den Enterprise-Computer mit überschwänglicher Rhetorik der Ausprägung „Product Excellence“ und „State-of-the-Art“. Ein holistischer ökonomischer Nachweis war, insbesondere auch aus der US-Amerikanischen Sicht, völlig außerhalb ihres Wahrnehmungs- und Interessens-Gesichtsfeldes. Und auch die „wissenschaftliche Informatik“ fühlte sich erstaunlicherweise nicht herausgefordert!

Neben meiner Person, „Head of IS-O Consulting“, die vor der „Gründung dieses Spin-offs“ ca. 3 Jahrzehnte bei IBM im Vertrieb, Marketing und Consulting als Führungskraft beschäftigt war und anlässlich eines US-Assignments mit ähnlicher Zielsetzung für die Thematik „holistischer Nachweis des Nutzens mit Realisierung auf Best-Practice-Niveau“ einen ersten Lösungsansatz entwickelte, gab es noch einige andere sporadische Versuche: So insbesondere von Herrn Paul A. Strassmann, einem sehr erfahrenen IT-Manager, der regelmäßig Kolumnen in der damals viel gelesenen IT-Fachzeitschrift „Computerwold“ verfasste, der seine „ernüchternden EIT-Nutzen-Erkenntnisse“ in seinem 1997 veröffentlichtem Buch „The Squandered Computer“ darlegte. Erwähnen möchte ich des Weiteren Herrn Herrn Erik Brynjolfsson, Professor am MIT, Sektion Sloan School of Management, einen der laut IT-Fachliteratur angeblich bedeutendsten Wirtschaftsinformatiker auf diesem Sachgebiet, der zum Messen des Nutzens des IT-Einsatzes in den Unternehmen die folgende Korrelation vorgenommen hat: Er setzt ins Verhältnis die "IT Hardware-Cost per worker" auf der Abszisse mit der "Total Factor-Productivity" auf der Ordinate und verwendet dabei die Daten von angeblich 1.167 Unternehmen aller Branchen. Als Ergebnis erhält er eine "weit streuende Punkte-Wolke" durch die er eine "leicht ansteigende Gerade!" ohne wissenschaftliche Begründung, d.h. anscheinend nach Gefühl, gezogen hat. Quelle: "The Productivity Gap", Erik Brynjolfsson, 2003, Issue 21. Erwähnen muss ich natürlich auch Herrn Nicholas G. Carr mit seinem im Havard Business Review veröffentlichten, viel beachteten und diskutiertem Statement: „IT doesn‘t matter“! Und schließlich sei noch auf einen deutschen Versuch durch die wirtschaftswissenschaftliche Fakultät der Humbold-Universität mit dem Thema „IT-Produktivität“ aufmerksam gemacht: Nach unserem Erkenntnisstand wurde auch bei diesem Versuch kein Erkenntnis-Durchbruch erzielt. Aus allen unseren Recherchen ergibt sich in Summe: Außer unserem „Holistischen Methodischen Lösungsansatz mit Daten-basierten IT-Enterprise-Produktivitäts-Best-Practice-Erkenntnissen gibt es offensichtlich keinen weiteren in der Praxis einsetzbaren Lösungsansatz!

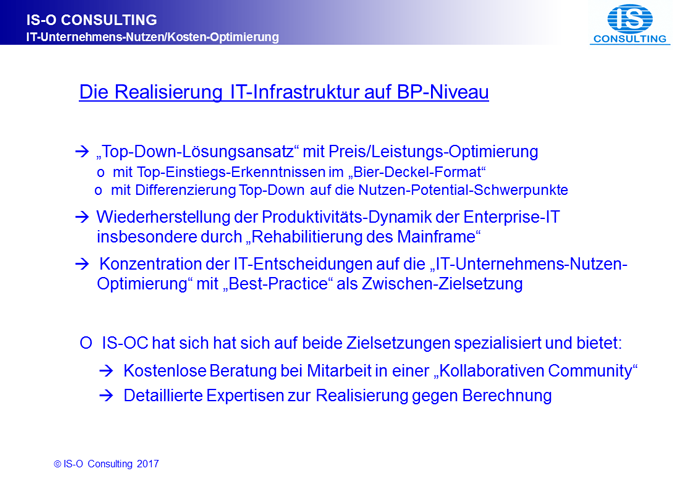

Die größte Herausforderung bei der Realisierung von Lösungen stellt sich „dem zur Lösung Entschlossenen“ bereits bei der Auswahl des von ihm „beherrschten“ Lösungsansatzes, nämlich induktiv oder deduktiv bzw. Bottom-up oder Top-down, singulär oder holistisch: Dabei wird sofort erkennbar, dass der holistische, deduktive Ansatz der weit Bessere ist. Damit fokussiert sich die Entscheidung für die Lösungs-Methode auf die Schlüsselfrage, ob der „zur Lösung Entschlossene“ den besten Lösungs-Ansatz auch tatsächlich beherrscht! Eine der fundamentalen Schwächen der Entwicklung der Enterprise-IT besteht darin, dass sich die Hauptverantwortlichen sowohl auf der Seite der Hersteller als auch auf Seiten der Realisierer in den Unternehmen bislang immer mit dem einfachen, induktiven Ansatz zufrieden gegeben haben. Dabei ist sofort erkennbar, dass der bessere Ansatz zwar herausfordernd in der Erlernung und Beherrschung ist, nach der Bewältigung dieses intellektuellen Kraftakts aber eine unvergleichlich höhere Vielfalt an neuen Erkenntnissen verfügbar macht! Außerdem ist die Realisierung mittels einer durch eine relativ einfach handhabbare „Top-down-Differenzierung“ herstellbaren „Realisierungs-Architektur“ übersichtlich und effizient umsetzbar. Erweiterungen, Aktualisierungen, Controlling, Verwaltung in der Cloud: Alles problemlos und einfach realisierbar!

Bei einem „Holistischen Lösungsansatz“ werden alle Fragestellungen durch die bekanntlich relativ einfache „Differenzierung“ und Abbindung in „Heuristischen Modellen“ beantwortbar. Aufgrund der Interessenslage haben wir unseren Methodischen Lösungsansatz in den letzten 28 Jahren auf die deutsche Versicherungsbranche fokussiert. Dabei stand die Beantwortung von 2 Fragestellungen in Mittelpunkt des Interesses nämlich:

- Welches unausgeschöpfte IT-Unternehmens-Nutzen-Potential hat ein Versicherungs-Unternehmen X relativ zu den „Best-Practice VU“? Und

- Welches Einspar-Potential im IT-Bereich hat dieses VU X ebenfalls im Vergleich mit den BP VU?

Da in den letzten Jahren immer stärker erkennbar wurde, dass das Hauptproblem der Enterprise-IT-Entwicklung in fehlenden Führungs-Erkenntnissen, wie „Produktivität der verschiedenen Computer-Architekturen(CA)“, „Totales Preis/Leistungs-Verhältnis der verschiedenen CA“, „BP-Mischungs-Verhältnis der bis zu 4 möglichen CA“ liegt, haben wir für diese Themen Lösungen entwickelt und ebenfalls in Netz gestellt. Dabei handelt es sich zum einen um das Thema: „Best-Practice bei Produktivität und Kosten des Unternehmens-IT-Bereiches“, das unter der Web-Adresse (www.is-oc.com/itb) zu finden ist. Und zum anderen um die Rückgängigmachung der in etwa Halbierung der Steigerung des Enterprise-IT-Gesamt-Ressourcen-Verbrauchs pro Jahr in den letzten 10 Jahren, die höchstwahrscheinlich zu einer ebenfalls Halbierung des Fortschritts der Enterprise-Digitalisierung geführt hat. Da als Hauptgrund für diese Fehlentwicklung die „kapitale Fehleinschätzung von Produktivität und Preis/Leistungs-Verhältnis des Mainframe“ Daten-basiert eindeutig identifiziert werden kann, haben wir unseren Lösungsansatz zur Beseitigung dieser Fehleinschätzung in einem weiteren Web-Auftritt unter dem Thema: „Die Rehabilitierung des Mainframe“ offengelegt.

Präsentations-Form

Abhandlungs-Form

Herausforderung: Produktivitäts-Messung des IT-Einsatzes in den Unternehmen

Der Begriff „Produktivität“ definiert eine Zielsetzung, die die Menschen als sehr wünschenswert erachten und gleichzeitig aber auch fürchten! Wünschenswert ist sie in der Form des Produktivitäts-Fortschritts als Hauptsäule der Gehaltserhöhungen der Beschäftigten und des Wohlstands der Nationen. Gefürchtet wird sie als angeblicher Job-Killer. Wenn man die Menschen abstrahiert als im Wesentlichen bestehend aus „Körper“ und „Geist“, dann ist die IT im „Bereich des Geistes“ der Menschen „nur“ ein äquivalenter Produktivitäts-Verstärker wie das im „Bereich des Körpers“ die immer wieder zitierten Produktivitäts-Verstärker „Dampfmaschine“, „Elektromotor“, etc. längst sind. Die Produktivitäts-Steigerung ist dabei eine Art janusköpfige Zielsetzung, der viele Verantwortliche aus dem Wege zu gehen bevorzugen. Da aber die Unternehmens-IT zu etwa 80% Produktivitäts-Fortschritt im „Bereich der algorithmischen Informationsverarbeitung der Unternehmen“ produziert, führt eine derartige Grundhaltung der IT-Verantwortlichen insbesondere seit etwa 2 Jahrzehnten zu einer immer gravierender werdenden Beschädigung der Evolutions-Dynamik der Unternehmens-IT und ihres Beitrags zur Produktivitäts-Steigerung in den Unternehmen.

Diese Situation ist v.a. auch der Tatsache geschuldet, dass es bis dato keine Anbieter von Messwerkzeugen zur Bestimmung des Produktivitäts-Fortschritts durch die Unternehmens-IT gegeben hat: Zum einen, weil insbesondere die Anbieter der Computer und Computer-Lösungen dafür keine Notwendigkeit gesehen haben und weil auf der anderen Seite die Verantwortlichen für die Unternehmens-IT diese Erkenntnis auch nicht nachgefragt haben. „Eingenebelt“ wird diese Situation darüber hinaus durch den Einsatz typisch US-amerikanischer, i.d.R. möglichst einfacher Messwerkzeuge, die nur die Kosten messen können. In diese Kategorie gehört auch das inzwischen häufig verwendete Messwerkzeug „TCO (Total Cost of Ownership)“, das scheinbar eine anspruchsvolle Zeitraum-Kosten-Messung realisieren kann: Dabei wird zum Teil absichtlich verschwiegen und zum Teil auch nicht verstanden, dass diese Ergebnisse nur für eine singuläre, unabhängige Aufgabenstellung Gültigkeit haben, z.B. nur für die Erweiterung von Server-Farmen durch einzelne, unabhängige Server verwendet werden könnten! Diese Ergebnisse sind im "tiefgestaffelten Multiprogramming des Enterprise-Computing" aber völlig unbrauchbar, da sie aufgrund des methodischen Ansatzes falsche, die Kosten der Enterprise-Computer viel höher als in der Wirklichkeit auftretend darstellen. Denn das Hinzufügen einer Anwendung ist beim Enterprise-Computing eine Integration und keine simple Addition! Und das gilt natürlich unabhängig von den für das Enterprise-Computing eingesetzten Servern!

Der Hauptgrund für den Einsatz falscher Messwerkzeuge liegt offensichtlich im häufig nicht vorhandenen Verständnis für die verschiedenen Charakteristiken der Anwendungen in den Unternehmen: Hauptsächlich in den unterschiedlichen Computer-Funktions-Anforderungen von „Unternehmens-Anwendungen“ und „Abteilungs-Anwendungen“. Und als Entscheidungs-Untermenge in der Charakteristik der Arbeitslast in den beiden Alternativen „kommerzielle AL“ oder „technisch/wissenschaftliche AL“. Geprägt werden die Einzel-Entscheidungen v.a. auch durch die Auftraggeber in den Fach-Abteilungen, die aufgrund ihrer Interessenslage und des IT-Verständnis-Niveaus eine singuläre und oft auch nur Anwendungs-Startsituations-bezogene, d.h. zu einfache Lösungsvorstellung entwickeln, die aus ihrer Sicht mit einem scheinbar kleinen, kosten-günstigen Server realisiert werden könnte.

Was die Fachabteilungen i.d.R. nicht richtig einzuschätzen in der Lage sind ist der Aufwand für die Vernetzung mit den Datenbeständen des Unternehmens und der Aufwand für Produktion, Wartung und Weiterentwicklung einer Anwendung. Und was Fachabteilungen insbesondere fehlt ist die Kenntnis über die „tatsächliche Produktivität der verschiedenen Computer-Systeme“ in ihrem Unternehmen. Eine Erkenntnis, die auch in vielen IT-Bereichen noch nicht vorhanden zu sein scheint!

Bedeutung des IT-Branchen-Segments „Enterprise-IT“

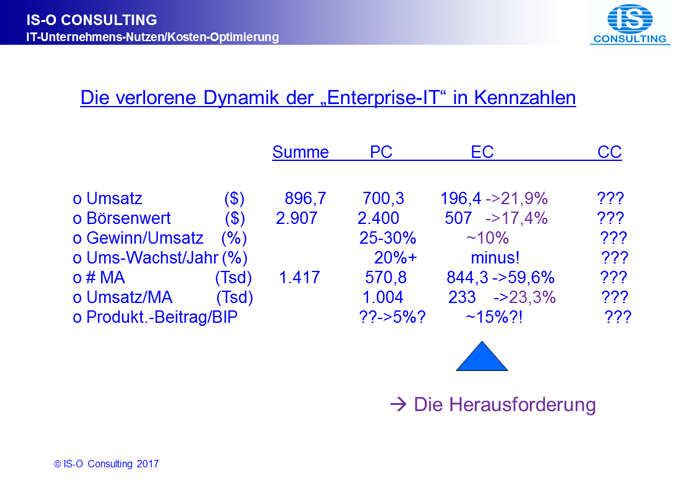

Ein nach einer Lösung für das „Enterprise-IT-Segment der IT-Branche“ Suchender muss zunächst zur Kenntnis nehmen, dass sich die IT-Branche fundamental weiter entwickelt hat und es das IT-Branchen-Segments „Enterprise-IT“ offiziell gar nicht mehr gibt: Dabei hat sich die Prägung der IT-Branche von ihrer ursprünglichen, nach dem 2. Weltkrieg als Enterprise-IT entstandenen Form immer stärker entfernt, beginnend insbesondere 1981 mit der Ankündigung des PC durch IBM: Gegenwärtig gibt es bereits 2 IT-Branchen-Segmente, das Segment „Enterprise-Computing“ oder „Unternehmens-Computing“, das die Fortsetzung der ursprünglichen IT für die Unternehmen umfasst, und das IT-Segment „Personal-Computing“, das durch die IT-Produkte insbesondere aus dem Silicon Valley eine völlig neue Bedeutung gewonnen hat. Und auch im IT-Segment Personal-Computing haben sich bereits wieder 2 Schwerpunkte ausgebildet: Das IT-Unter-Segment „Enterprise-Personal-Computing“ und ein IT-Unter-Segment, das wir „Private-Computing“ benennen wollen, realisiert v.a. durch die Smartphones. Ein 3. IT-Segment ist offensichtlich auch schon ante portas, das durch die Bezeichnung „Cognitive Computing“ gut charakterisiert wäre und dessen Bedeutung für die Unternehmen und die Gesellschaft immer augenfälliger wird. Da die Berichterstattung über die IT-Branche in den Wirtschaftsteilen der Presse und oft selbst in der IT-Fachpresse ohne diese Differenzierung erfolgt und das Segment „Personal-Computing“ mit seiner inzwischen erreichten ökonomischen Dominanz und seinen überragenden Fortschritts-Erfolgen das Bild der IT-Branche dominiert, bleibt die "Malaise des Enterprise-IT-Segments" fast unbemerkt. Dass das Computer-Hersteller-Flaggschiff des Enterprise-Computing IBM seit nunmehr 21 Quartalen (Status 3Q2017) einen Umsatzrückgang zu beklagen hat und auch bei Berücksichtigung der Geschäfts-Modell-Anpassungen auf bestenfalls stagnierende Umsätze kommt, ist repräsentativ für die Situation im Enterprise-IT-Segment.Wer an dieser Stelle der IT-Branchen-Analyse meint, diese Situation als Problem der Computer-Branche abtun zu können, verkennt die Bedeutung insbesondere des Enterprise-IT-Segments der IT-Branche: Das Enterprise-IT-Segment der IT-Branche produziert nach unsere inzwischen 27-jährigen Forschung auf diesem Gebiet etwa 80% des Produktivitäts-Fortschritts im Beschäftigungs-Segment „Angestellte“ in der ehemaligen Semantik, heutzutage wahrscheinlich mit „Büro-Angestellte“ präziser bezeichnet, in den USA eindeutiger als „White Collar“ benannt. Vom Beschäftigungs-Profil ausgehend sind das alle Beschäftigte, die Informationsverarbeitung im allgemeinen Sinne betreiben: In den Branchen „Versicherungen“ und „Banken“ sind das nahezu 100% der Beschäftigten, außer Hausmeistern und Fahrdienst. In den anderen Branchen sind dies v.a. die Büro-Angestellten. Und natürlich werden auch die „handwerklichen Tätigkeiten“ immer stärker durch die Informationsverarbeitung geprägt. Um zu einer qualitativ hochwertigen Aussage über die auf Computer übertragbare gesamte Arbeitslast zu gelangen, muss man die Arbeitslast der einzelnen übertragbaren Geschäfts-Prozesse der Beschäftigten aufaddieren und nicht die ganzen Arbeits-Plätze der Beschäftigten. In Deutschland dürfte es sich dabei gegenwärtig um das Arbeitsvolumen von ca. 20 Millionen Beschäftigten handeln, deren Produktivität ganz wesentlich von der Unterstützung durch die Enterprise-IT abhängt. In der deutschen Versicherungs-Branche, der Testbranche unseres „Enterprise-IT-Best-Practice Consulting-Ansatzes“ ist der Produktivitäts-Fortschritt bei den Innendienst-Mitarbeitern, die 72% aller Unternehmens-Mitarbeiter umfassen, im Branchendurchschnitt bei ca. 220% und bei den Best-Practice-Unternehmen bereits bei ca. 380% anbelangt. D.h. ein VU, das die Produktivität seiner Enterprise-IT selbst ergründen möchte, braucht „nur“ die Situation zu analysieren, „wie viele zusätzliche Mitarbeiter notwendig wären, wenn die gegenwärtige Informationsverarbeitung vollständig ohne die EIT durchgeführt werden müsste?“ Bei einem dt. VU auf BP-Niveau hieße dies, dass es ca. 380% zusätzliche Innendienst-Mitarbeiter benötigte! Die zusätzlichen Service-Einschränkungen und deren Konsequenzen können bei diesem Gedankenexperiment als zunächst weniger bedeutend unberücksichtigt bleiben. Wer an dieser Stelle auf die Idee kommen sollte, dies als sehr theoretische Erkenntnis-Situation abzutun, sei darauf hingewiesen, dass es diese Situationen heutzutage auch in der Praxis sehr wohl geben könnte: Z.B. Im Katastrophen-Fall eines RZ ohne ausreichende Vorsorge oder neuerdings bei einem erfolgreichen Hacker-Angriff. Schließlich sei noch daran erinnert, dass der „Wohlstand der Nationen“ ganz elementar vom Produktivitäts-Niveau einer Nation anhängt.

Schlussfolgerung: Die Produktivitäts-Messung der Enterprise-IT ist unumgänglich notwendig und sollte so schnell wie möglich realisiert werden!

Versäumnisse im "IT-Branchen-Segment Enterprise-IT“

Auf die Frage, warum es immer noch keine qualifizierten Produktivitäts-Kennzahlen für die IT-Branche gibt, fallen dem Verfasser dieser Unterlage, der viele Jahre bei IBM im Marketing, Vertrieb und Consulting, national und auch in den USA, beschäftigt war, sofort eine ganze Reihe von Begründungen ein: Leider sind das alles Begründungen, die die Misere des Enterprise-IT-Segments der IT-Branche verständlich machen:

- Keine IT-Nutzen-basierten Verkaufsstrategien für den Mainframe notwendig?!

Computer waren seit ihrer „Erfindung“ Glamour-Produkte, die eigentlich jeder für die Informationsverarbeitung eines Unternehmens Verantwortliche haben wollte. Die Vertriebsaufgabe bei den Anbietern lautete also nie: Braucht ein Unternehmen überhaupt mehr Computer-Leistung sondern immer nur „welche zusätzliche Leistungsfähigkeit der neuen Computer lässt sich scheinbar überzeugend begründen?“ und „von welchem Hersteller sollten sie beschafft werden?“ Die Herstellerfrage hat sich aber nach kurzer Zeit von selbst erledigt, da in der Branche sehr schnell bekannt war, dass ein Herstellerwechsel aufgrund der immer höher werden Umstellungskosten de facto gar nicht möglich war. Und für die Unternehmens-IT kamen eigentlich nur Maiframe-Computer infrage, da die Alternative „Prozess-Rechner“ wegen ihrer beschränkten kommerziellen Funktionalität nicht einmal die Mindestanforderungen eines Enterprise Computers erfüllte. Die Versuche von Herstellern von Computern mit anderen Architekturen, insbesondere aus IT-Segment „Technisch/wissenschaftliches Rechnen“ konnten stets souverän abgewehrt werden: Am bekanntesten sind die 2 Versuche von DEC in den 80’er Jahren, die mit dem Untergang der einst nach IBM 2. größten Computer-Firma endeten.

Die Ankündigungen neuer Mainframes, i.d.R. alle 4 Jahre, waren gesellschaftliche Großveranstaltungen, zu denen sich die IT-Führungskräfte der Kunden gerne einladen ließen. Präsentiert wurden die neue Generation der MF, mit i.d.R. doppelter Leistungsfähigkeit, jeweils von namhaften Repräsentanten der Hersteller, von einer Führungskraft aus dem geheimnisvollen weil streng abgeschirmten Bereich der Computerentwicklung, und den Führungskräften des Vertriebes, die eine faire Verteilung der fast automatisch von jedem Unternehmen eingehenden und sich zu großen Backlogs akkumulierenden Aufträgen versprachen. Wer sich das nicht vorstellen kann, dem empfehlen wir, sich an die Ankündigungs-Veranstaltungen von Herrn Steve Jobs für seine Smartphones zu erinnern. Marketing der Mainframes im Sinne der ökonomischen Bezeichnung Marketing war gar nicht nötig und wurde daraufhin offensichtlich auch nie von Marketing-Fachleuten in Angriff genommen, so dass der Vertrieb für Enterprise-Computer nie über die entsprechenden Fähigkeiten verfügt hat. Das rächt sich seit etwa 20 Jahren immer stärker: Und zwar in 2-facher Hinsicht: Die „erste fundamentale Fragestellung“ im Enterprise-Computer-Segment lautet längst: Welchen Nutzen hat das Unternehmen durch die Installation zusätzlicher Informationsverarbeitungs-Leistungsfähigkeit jenseits der "taktischen Erweiterungen" der bestehenden Anwendungen, insbesondere zur Realisierung der EIT auf BP-Niveau sowie durch Funktionsverbesserungen im System-SW-Bereich zur Produktivitäts-Realisierung im IT-Bereich auf BP-Niveau? Und bei der Realisierung zusätzlicher Anwendungen stellt sich auch fast automatisch die „zweite fundamentale Fragestellung“: Auf welcher Computer-Architektur, „MF“, „Unix-Server“, „x86-Server“ oder „Cl-Server und PC“ sollte die benötigte zusätzliche Leistungsfähigkeit realisiert werden? Erstaunlicherweise hat kein Anbieter von Computern für die Enterprise-Anwendungen darauf eine Antwort. Der Maßstab „TCO“ (Total Cost of Ownership), der bei dieser Fragestellung üblicherweise ins Spiel gebracht wird, führt bei den Enterprise-Anwendungen zu grundsätzlich falschen, die Enterprise-Computer viel zu teuer darstellenden Ergebnissen. Und dieses gilt unabhängig von der Computer-Architektur der CPUs der Enterprise-Computer, d.h. auch wenn x86-Server als Enterprise-Computer eingesetzt werden! Eine ausführlichen Begründung und der Vorschlag einer richtig messenden Alternative sind nachfolgend zu finden. Nach unserem Erkenntnisstand sind wir die Einzigen, die beide fundamentalen Fragstellungen Daten-basiert beantworten und darüber hinaus Empfehlungen zur Realisierung anbieten können. - Das Marketing der IT-Branche ist „taktisch“ US-Mentalitäts-geprägt

Warum könnte die Prägung des Marketings bei der Entwicklung der Enterprise-IT eine entscheidende Rolle gespielt haben? Weil es die Aufgabe des Marketings ist, den Wert, den Nutzen eines Produktes oder einer Lösung für die potentiellen Kunden möglichst leicht verständlich darzustellen. Und da die IT bekanntlich stark US-geprägt ist, hat die US-Mentalität natürlich einen starken Einfluss auf die IT-Produkte und das Marketing. Dabei wird das US-Amerikanische Marketing von einer Reihe von Mentalitäts-Schwerpunkten und auch -Schwächen geprägt, die sich nach unserem Erkenntnisstand wie folgt darstellen lassen.- Fokus auf den Preis

Da die amerikanische Gesellschaft bekanntlich sehr heterogen ist, ist der „Preis“ diejenige Produkt-Kennzahl, die jeder, auch einfache Menschen, sofort versteht. Dabei liefert der Preis 2 Erkenntnisse: Zunächst die Antwort auf die Frage: Kann und/oder will ich mir dieses Produkt überhaupt leisten? Und wenn die Antwort mit ja ausfällt: Welcher Produkt-Hersteller bietet dieses Produkt zum niedrigsten Preis an? Bei der 2. Fragestellung wird meistens zunächst unterstellt, dass die Produkte der verschiedenen Hersteller zwar nicht unbedingt identisch aber doch gleichwertig sind. Wer da nicht auch die Leistung eines Produktes zumindest einigermaßen qualifiziert überprüft, braucht sich nicht zu wundern, wenn er über den Tisch gezogen wird. Das passiert aus Mentalitätsgründen in den USA häufiger als in Deutschland und in der Computer-Branche häufiger als im normalen Leben. Schlussfolgerung für die EIT: Nur der Vergleich des "Preis/Leistungs-Verhältnisses von IT-Produkten oder IT-Lösungen" im Gesamt-Kontext des EIT liefert eine qualifizierte Antwort! Der seit etwa 2 Jahrzehnten immer häufiger zum Einsatz kommende Maßstab TCO repräsentiert, wie die Bezeichnung bereits offenlegt, nur einen Kosten-fokussierten Ansatz. Die Verteidigungs-Argumentation der TCO-Anwender ist natürlich bekannt. Deshalb der Hinweis, dass die viel gravierenden Kritikpunkte folgen werden. - Fokus auf attraktive Produkt-Funktionen

Wie verkauft man der sehr heterogenen amerikanischen Gesellschaft die „Leistung“ eines Produktes oder gar einer Lösung? Die typische amerikanische Antwort heißt: Durch das Herausstellen besonders attraktiver Produkt-Funktionen: Als „Product Excellence“ Marketing bekannt. Das ist erneut eine starke Vereinfachung der Leistungs-Beschreibung eines Produktes mit viel Raum für Marketing-Kreativität. Und die wird in der amerikanischen Kultur i.d.R. konsequent eingesetzt, insbesondere auch in der IT-Branche. Heutzutage im „Silicon Valley“ genauso wie früher in den „New England Staaten“.

Das Mainframe-Marketing bestand de facto immer ausschließlich aus Product Excellence Marketing kombiniert mit einigen Produkt-Leistungs-Kennzahlen: Bei der MF-Hardware ist dieser Marketingansatz relativ einfach zu realisieren. Und dieser Ansatz hat bekanntlich auch genügt, da bis etwa Ende der 70’er Jahre nur die HW zu bezahlen war. Herausfordernd wurde das MF-Marketing mit Einführung der Bepreisung der Software. Denn während bei der HW die Leistung der CPU relativ einfach messbar ist und z.B. von IBM in MIPS offiziell veröffentlich wurde und wird, besteht die Leistung der SW-Produkte und –Funktionen in ihrem Wesen in Produktivitäts-Verbesserungen der Mitarbeiter des IT-Bereiches und der IT-Anwender in den Unternehmen. Diese Verbesserungen lassen sich zwar in „lokalen betriebswirtschaftlichen Modellrechnungen“ darstellen, allerdings mit erheblichen Grauzonen und damit viel geringerer Überzeugungskraft als bei der HW.

Besonders herausfordernd ist die SW-Kosten-Situation in der EIT geworden als insbesondere die IBM die SW-Funktionalität und parallel dazu die SW-Kosten des MF durch „Key Branded Middleware“, die v.a. „Productivityware“ ist, immer weiter erhöht hat, ohne ihren Kunden diese Vorgehensweise durch überzeugende Marketing-Aufklärung, d.h. eine Preis/Leistungs-Darstellung die Vorteile für die Kunden zu erklären. Da es seit mindestens 15 Jahren für die Unternehmens-Anwendungen Alternativen zum MF gibt, ist insbesondere auch der Preis-Vergleich des SW-Segmentes der EIT im vollem Gange.

Da die IBM aus strategischen Gründen in dieser Zeit den Anteil der HW an ihren MF-Systemen immer weiter reduziert hat, entstand die Situation, dass die "IBM SW-Kosten des MF" i.d.R. mehr als 3 Mal so hoch sind wie der "IBM HW-Kosten-Anteil des MF". Häufige Fehlschluss-Folgerungen der Kunden: Die SW-Kosten des MF sind inzwischen zu hoch!? Diese Einschätzung ist wegen der eingeschränkten Perspektive aber ebenfalls völlig falsch, wie wir später Daten-basiert beweisen werden.

- Fokus auf den Preis

- Bisherige „Punktuelle Darstellung“ des Unternehmens-Nutzens der Computer

Zu den „klassischen Forderungen“ der Betriebswirtschaft gehört es, Produkte aus Sicht des Kunden-Nutzens zu konzipieren und im Marketing darzustellen. Die Herausforderung der Computer-Branche besteht gegenwärtig darin, dass das im Enterprise-IT-Segment in der Vergangenheit für die Anbieter der Computer-Produkte nicht nötig war, wie bereits ausführlich dargestellt, inzwischen aber immer nachdrücklicher gefordert wird. Das „Personal-IT-Segment“ durchläuft übrigens bis zur Gegenwart ebenfalls diese „oberflächliche Product Excellence Marketing-Phase“ ohne die Notwendigkeit der Darstellung des „persönlichen Nutzens“ von Smartphones, Google-Antworten, Facebook-Nachrichten, Twitter-Kommentaren und usw. Dabei ist eine allen ökonomischen Ansprüchen gerecht werdende Lösung mit überschaubarem Aufwand durchaus möglich, wie wir noch Daten-basiert beweisen werden.

Unsere bisherigen Ausführungen zum Thema IT-Unternehmens-Nutzen mit Schwerpunkt IT-Unternehmens-Produktivität wären unvollständig, ungerecht und auch zu pessimistisch beschrieben ohne eine angemessene Darstellung der Bemühungen von Fachleuten in den Unternehmen, den Nutzen der IT häufig auch mit Schwerpunkt Produktivitätssteigerung Daten-basiert in Entscheidungsvorlagen offen zu legen. Dabei handelt es i.d.R. um „lokale Business Case“ bzw. „lokale betriebswirtschaftliche Modellrechnungen“, die von Projekt-Teams zum Nachweis des wirtschaftlichen Nutzens ihrer Verbesserungs-Vorschläge angefertigt werden. Sehr häufig sind das Verbesserungen an Geschäftsprozessen, bei denen ein Teil der bisher von Mitarbeitern produzierten Informationsverarbeitung auf Computer-Verarbeitung übertragen wird. Initiatoren dieser Projekte sind i.d.R. die Abteilungen „Betriebs-Organisation“, „Unternehmens-Planung“ und „internes Consulting“ meistens in Zusammenarbeit mit den „IT-Attaches“ in den Fachabteilungen.

[Weitere Einzelheiten ]

]

Auch wenn aus diesen bei praktisch allen Unternehmen vorhandenen umfangreichen Produktivitäts-Erkenntnissen aus singulären Business Cases kein unternehmensweiter Produktivitäts-Fortschritt errechnet werden kann, so führen sie dennoch zu der fundamentalen Erkenntnis, dass es einen ganz wesentlichen IT-Produktivitäts-Fortschritt in den Unternehmen sehr wohl gibt! Ungeklärt ist an dieser Stelle der Analyse nur noch die Frage, mit welchem Methodischen Ansatz dieser IT-Produktivitäts-Fortschritt messbar gemacht werden kann? Den mit dieser Zielsetzung von uns entwickelten „Daten-basierten Methodischen Lösungsansatz“ wollen wir nachfolgend vorstellen.

Bisheriges Marketing mittels „IT-Kosten-Maßstab“ und neuer „Holistischer IT-Unternehmens-Nutzen/Kosten-Maßstab“

Als Erstes stellt sich natürlich die fundamentale Frage: Wie ist es möglich, dass die gegenwärtig wahrscheinlich modernste aller Branchen, mit den innovativsten Produkten und Lösungen und folglich auch den i.d.R. kreativsten Beschäftigten nicht in der Lage zu sein scheint, den Wert ihrer Produkte nicht nur in Marketing-Parolen sondern auch in ökonomischen Kennzahlen zur Darstellung zu bringen?

IT-Kosten als komplementäre IT-Nutzen-Mess-Größe?

Wenn Herr Solow vor dem Verfassen seiner These: “You can see the computer age everywhere but in the productivity statistics." sich umfassend kundig gemacht hätte, dann wäre ihm aufgefallen, dass es eine Flut an Daten-basierten Aussagen gibt über die Kosten der Computer. Und dann hätte er auch der Computer-Branche konzedieren müssen, was praktisch in allen Branchen auch üblich ist, insbesondere in Ländern wie den USA, dass die Kosten eines Produktes der Einfachheit halber stellvertretend für den Wert, den Nutzen eines Produktes im Marketing zum Einsatz kommen. Wenn also der von ihm verwendete Maßstab zum Messen der IT-Produktivität keine Ergebnisse produziert, dann hätte er daraus den Schluss ziehen müssen, dass der verwendete Maßstab ungeeignet ist und nicht, dass es keine IT-Produktivitäts-Beiträge gibt! Oder er hätte den Beweis antreten müssen, dass in der IT-Branche die hohen Kosten keinen Unternehmens-Nutzen produzieren sondern nur z.B. aus Image-Gründen akzeptiert werden. Oder aber der Volkswirt Solow hätte sich auch die Frage stellen müssen, ob sich die IT-Produktivität möglicherweise volkswirtschaftlich anders darstellt als betriebswirtschaftlich?

Denn qualifizierte Aussagen über die Kosten der IT gibt es zuhauf und in ausreichend guter Qualität. Die i.d.R. bekannteste stammt seit vielen Jahren von der „Gartner Group“. Diese sehr renommierte „IT-Beratungs- und Marktforschungs-Firma“ schätzt den IT-Umsatz weltweit für 2017 auf $ 1.972 Milliarden. Bei „Statista“, einem deutschen Online-Portal für Statistik, das Daten von Markt- und Meinungsforschungsinstitutionen zugänglich macht, wird der IT-Umsatz mit weltweit € 1.552 Milliarden angegeben. Und auf vergleichbare Werte kommt auch das EITO, das „European IT Observatory“. Darauf aufmerksam machen müssen wir an dieser Stelle, dass diese Umsatzzahlen aber nur „die eine Seite der IT-Medaille“ abbilden, nur die Seite, die die Umsätze der IT-Branche beschreibt. Damit die Unternehmens-IT aber IT-Nutzen und IT-Unternehmens–Produktivität produzieren kann, muss aber auch „die andere Seite der IT-Medaille“ möglichst auf Best-Practice-Niveau realisiert werden, nämlich die Produktions-Seite in den Unternehmen bestehend aus „RZ“, „Anwendungsentwicklung“, „Benutzer-Service“ und „IT-Verwaltung“. In Deutschland ist die Anzahl dieser IT-Beschäftigten in den Unternehmen etwa gleich hoch wie Anzahl der Beschäftigten in der IT-Branche, nämlich zwischen 800 und 850 Tsd. Hochgerechnet auf die IT-Branche ergibt dies einen „IT-Gesamt-Umsatz weltweit“ von ca. $ 3.340 Milliarden und für Deutschland einen „Unternehmens-IT-Gesamt-Umsatz“ von ca. € 125 Mrd. Das sind ca. 4,0% des deutschen BIP. Da nach unserem umfangreichen IT-Erkenntnis-Material € 1 Unternehmens-IT-Kosten (Investitionen!) im Durchschnitt ca. € 4 ROI zustande bringt, produziert die Unternehmens-IT gegenwärtig bereits fast € 500 Millionen pro Jahr oder ca. 16% Beitrag zum deutschen BIP. Dieser Beitrag lässt sich allerdings mit dem bisher in der Volkswirtschaft üblichen Maßstab BIP nicht messen, Herr Solow! Diese Situation werden wir nachfolgend noch ausführlich diskutieren und Alternativen vorschlagen.

Als weitere IT-Kosten-Erkenntnis-Größe mit hoher Aussagekraft gibt es bei der Unternehmens-IT bekanntlich die Kennzahl "IT-Budget", quasi die Individualisierung der "IT-Gesamt-Kosten eines Landes" auf die einzelnen Unternehmen. Diese Kennzahl geniest eine derart hohe Glaubwürdigkeit in den Unternehmen wie auch in der Informatik, dass sie sogar als „Abszissen-Maßstab“ in Korrelationen über den Nutzen der IT-Kosten in den Unternehmen verwendet wird. Wenn die IT-Kosten in den Unternehmen, 1.000-fach gemessen, einen weit überdurchschnittlichen Unternehmen-Nutzen produzieren, dann kann eine Integration aller Unternehmens-Ergebnisse zu einem Staats-Ergebnis nicht „unsichtbar“ sein: Es sei denn, man hat sich eine falsche Brille aufgesetzt. Und der Maßstab BIP ist der falsche methodische Ansatz zum Messen der Unternehmens-IT-Produktivität, wie wir zur Auflösung dieses angeblichen Produktivitäts-Paradoxons nachfolgend in dem Kapitel „Widerlegung des IT-Produktivität-Paradoxons“ darstellen werden.

Unser neuer Methodischer Lösungsansatz: „Holistischer IT-Unternehmens-Nutzen/Kosten-Maßstab“

Wenn ein singulärer Ansatz, wie „Bottom-up“ oder wissenschaftlich ausgedrückt „induktiv“, der bekanntlich insbesondere im „US-Amerikanischen Kulturraum“ besonders geschätzt wird, die Aufgabenstellung nicht lösen kann, dann gibt es bekanntlich theoretisch auch die Alternative „Top-down“ oder „deduktive“ Vorgehensweise. Die Voraussetzungen für die Realisierung eines deduktiven Ansatzes sind sehr viel herausfordernder als die bei einem induktiven Ansatz, denn ein deduktiver Ansatz benötigt das Vorhandensein einer „holistischen Einheit“ in Form eines „Sample“, die die gewünschte Erkenntnis-Größe, in unserem Fall die „Unternehmens-IT-Produktivität“, als Untermenge beinhaltet. „Holistische Einheiten bei der Realisierung der Unternehmens-IT“ wurden insbesondere von Computer-Herstellern zur Effektivitäts-Steigerung des Vertriebes und des Marketings schon seit Anfang des Computer-Einsatzes definiert und organisatorisch realisiert. Die Auswahl-Kriterien waren gleichartige Interessen der Unternehmen bei der Realisierung der Unternehmens-IT, die zur Effektivitäts-Steigerung des Vertriebes bei den Computer-Herstellern verwendet werden können. Diese Organisation folgt gleichartigen Interessen der Unternehmen der Wirtschaft, die es bekanntlich auf vielen Gebieten und schon seit sehr langer Zeit gibt, so dass auch eine klare Gliederung vorhanden ist, nämlich die Gliederung nach Branchen. Von dieser vorhandenen, zum Teil stark differenzierten Gliederung, wurden in der Computer-Branche nur die „Haupt-Branchen“ übernommen, nämlich „Banken“, „Versicherungen“, „Fertigung“, „Grundstoff“, „Handel“, „Dienstleistungen“, „Verwaltung“ und „Wissenschaft“. Damit existieren i.d.T. „Holistische Einheiten beim Einsatz der Unternehmens-IT“, ausgestattet mit umfangreichem, allerdings unharmonisiertem IT-Datenmaterial.

Als Führungskraft beim damals mit großem Abstand größten Enterprise-Computer-Hersteller hatte ich Zugang zu diesem sehr umfangreichen und auch praktisch alle Unternehmen einer Branche abdeckenden IT-Daten-Material und konnte „IT-Daten-basiert“ untermauern, was mir als Marketing-Verantwortlicher schon „bei singulären Kunden-Situationen“ aufgefallen war: Dass es zum Teil riesige Unterschiede beim Einsatz der Computer in den verschiedenen Unternehmen derselben Branche gab und darüber hinaus auch sehr große Unterschiede beim Einsatz der Computer in den verschiedenen Branchen! So eine Situation macht natürlich neugierig, denn sie wirft die grundsätzliche Frage auf, ob sich aus dieser Situation Erkenntnisse zur Realisierung zusätzlichen Geschäfts-Potentials gewinnen lassen? Basierend auf der Frage: Welche der Unternehmen einer Branche haben die betriebswirtschaftlich richtige Entscheidung getroffen, die mit den sehr hohen Investitionen in die Enterprise-Computer oder die mit den relativ niedrigen? Denn betriebswirtschaftlich richtig können beide Alternativen unmöglich gleichzeitig sein.

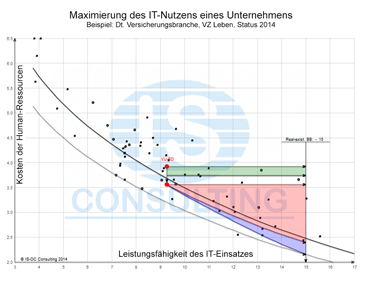

Als Arbeitshypothese haben wir folgenden Zusammenhang analysiert: Selbstverständlich haben alle IT-Verantwortlichen der einzelnen Unternehmen beim IT-Einsatz in ihren Unternehmen jeweils mit oberster Priorität die Zielsetzung verfolgt, den IT-Unternehmens-Nutzen bestmöglich, heutzutage üblicherweise als "Best-Practice" bezeichnet, zu realisieren. Und die Anbieter von IT-Produkten und IT-Lösungen haben sie dabei teils sehr aber oft auch weniger gut unterstützt. Oft auch weniger gut insbesondere deshalb, weil die IT-Produkte-Hersteller aufgrund ihrer Entstehung fast ausschließlich Nischen-Produkte-Anbieter waren und auch immer noch sind und ihre Geschäftsmodelle deshalb die Zielsetzung Best-Practice bestenfalls aus ihrer punktuellen Produktsicht realisieren können und wollen, um es euphemistisch auszudrücken. Der Mangel an IT-Entscheidungs-Erkenntnissen hat in der Praxis deshalb unausweichlich zu erheblich unterschiedlichen Ergebnissen bei der Realisierung des IT-Unternehmens-Nutzens in den einzelnen Unternehmen geführt. Nach unserer schon damals erheblichen Erfahrung und unserer inzwischen sehr umfangreichen eigenen Daten-Sammlung, unterscheidet sich die IT-Unterstützung pro Mitarbeiter in Deutschland um bis zu Faktor 10! Faktor 3-4 war und ist immer noch die Regel. In dieser Situation lässt sich schlussfolgernd die „Hypothese“ aufstellen, dass der „IT-Unternehmens-Produktivitäts-Nutzen" bei vergleichbaren Mitarbeitergruppen beschäftigt bei vergleichbaren Unternehmen, deren IT-Einsatz sich derart gewaltig unterscheidet, klar zutage treten müsste: Und genau dieser Unterschied bei der "benötigten Anzahl von Mitarbeitern pro Output-Einheit bei unterschiedlich hoher IT-Unterstützung der Mitarbeiter" ist mit erstaunlicher Eindeutigkeit zutage getreten. Und dies bei den Unternehmen in allen Branchen, wenn sie dabei, wie beim IT-Marketing üblich, in 8 Branchen untergeteilt werden, da die Branchen die "Charakteristik von Erkenntnis-Domänen", inzwischen auch „Schwarmintelligenz“ genannt, repräsentieren! Aus den Ergebnissen unserer Untersuchungen lässt sich, wie sofort erkennbar wurde, ein völlig neuartiger Lösungsansatz zur Beantwortung der "Gretchen-Frage der IT: Wie viel Geld sollte ein Unternehmen für seine IT ausgeben?", entwickeln: Nämlich ein durch "Decision-Mining mittels Benchmarking" gewonnener, "Daten-basierter", "holistisch deduktiver", Methodischer Lösungsansatz! Der gemessene Nutzen in der Messgröße „Anzahl Mitarbeiter pro Ergebnis-Einheit setzt sich i.d.R. zusammen aus etwa „80% Produktivitäts-Nutzen“ und etwa „20% Service-Nutzen“.

[Weitere Einzelheiten  ]

]

Unser Holistischer Lösungs-Ansatz hat die folgenden „fundamentalen Merkmale bzw. Vorteile“:

- Es ist ein "Sample-basierter Holistischer Ansatz" angelsächsisch „Top-down-Ansatz“ genannt.

- Die "Erkenntnisse werden mittels Big-Data-Analysis und Decision-Mining gewonnen und sind Praxis-basiert", d.h. sie bilden die real-existierenden Situationen in einer Domäne ab.

- In einem Holistischen Ansatz lässt sich durch "Benchmarking" die "Kollektive Intelligenz der Beschäftigten einer Domäne", üblicherweise die Erkenntnisse einer Branche oder Subbranche, darstellen und einsetzbar machen.

- Das Benchmarking der Unternehmen einer Domäne ergibt v.a. die folgenden Entscheidungs-Erkenntnisse:

- Die fundamentale Erkenntnis: "Best-Practice" in allen ihren vielfältigen Erscheinungsformen,

- ein "IT-Rating" der einzelnen Unternehmen und damit eine eindeutige Aussage über den Handlungsbedarf,

- die Darstellung des "unausgeschöpften IT-Nutzen-Potentials eines Unternehmens" in "Business Case-Form",

- da die Korrelation "benötigte Anzahl Mitarbeiter vs IT-Einsatz" in einem 2-dimensionalen Diagramm dargestellt wird, lässt sie sich zu einer "Durchschnittskurve" komprimieren: Daraus ergeben sich auch qualifizierte Erkenntnisse über "legitime Zielsetzungen jenseits des Best-Practice-Niveaus."

- Ein holistischer Ansatz beinhaltet theoretisch die Antworten auf alle Fragen, die in dem Sample abgebildet sind. Die Antworten auf die Fragen lassen sich relativ einfach durch Differenzierung des holistischen Ansatzes gewinnen.

- Ein holistischer Ansatz erlaubt es insbesondere, Fragestellungen durch relativ einfache "Heuristische Modelle" abzubilden, wobei die Aussagegenauigkeit und damit der Datenaufwand vorgegeben werden können.

- Die Erkenntnisse eines holistischen Ansatzes lassen sich mit relativ geringem Aufwand fortschreiben.

- Das Controlling bei der Realisierung des IT-Unternehmens-Nutzens ist Ansatz-immanent.

- Die Realisierung der IT-Umsetzungs-Effizienz bis zum Best-Practice-Niveau ist natürlich ebenfalls Teil dieses holistischen Ansatzes und ist in ihrer Struktur ein Teil der IT-Unternehmens-Nutzen-Realisierung-Architektur.

- Da dieser Methodische Lösungsansatz ausschließlich aus Fakten und Algorithmen besteht, sind seine Realisierung und die Fortschreibung der Erkenntnisse ausschließlich über das Internet, in der Cloud von IS-OC, mit bester Umsetzungs-Effizienz möglich.

Dieser Methodische Lösungsansatz, der den "erfahrungswissenschaftlichen Anforderungen nach K.R. Popper" entsprechen dürfte, ist der unseres Wissens erste und bisher einzige, der das Prädikat "Big-Daa- und Decision-Mining-basiertes IT-Consulting" mit der "Zielsetzung einer IT-Unternehmens-Nutzen/Kosten-Optimierung" verdienen dürfte!

„Enterprise-IT-Produktivität“ auf „Best-Practice“-Niveau

Am Beispiel der deutschen Versicherungs-Branche

Der IT-Bereich wurde natürlich auch bisher kontrolliert, allerdings immer nur aus der Sicht der anfallenden Kosten. Was bisher erstaunlicherweise total fehlt, ist eine systematische Analyse der Unternehmens-IT aus der Sicht des von ihr produzierten IT-Unternehmens-Nutzens. Diese komplementäre Sicht fördert zusätzlich die hoch wichtige Erkenntnis zutage, dass es neben dem Nutzen-Beitrag der IT für die Unternehmen, der zu ca. 80% aus Produktivitäts-Nutzen besteht und den wir unter der Bezeichnung „Enterprise-IT-Produktivität-Optimierung“ abhandeln wollen, auch die immer wichtiger werdende Zielsetzung der „Produktivitäts-Optimierung im IT-Bereich“ selbst gibt. Mit dem Einsatz von Computern mit den gegenwärtig bis zu 4 möglichen Computer-Architekturen „Mainframe“, „Unix-Server“, „x86-Server“ und „Clienten-Server+PC“, die, den meisten IT-Verantwortlichen offensichtlich immer noch unbekannt, eine zum Teil sehr unterschiedliche "Eigen-Produktivität" aufweisen, bekommt auch das Thema „Produktivitäts-Optimierung im IT-Bereich“ eine zusätzliche immer größere werdende Bedeutung. Von den 4 Computer-Architekturen ist z.B. die „MF-Architektur“ in der deutschen Versicherungs-Branche im Branchen-Durchschnitt etwa 3 Mal produktiver als die möglichen Alternativen „Unix-Server“ und „x86-Server“! Dabei hat eine mangelhafte Produktivität im IT-Bereich z.B. in der dt. Versicherungsbranche eine, nach unserem Datenmaterial, bis zu ca. 6 Mal größere Auswirkung auf die Enterprise-IT-Produktivität! Die bisher übliche ausschließliche Fokussierung auf die IT-Bereichs-Kosten geht da inzwischen offensichtlich erheblich an der unternehmerischen Zielsetzung der optimalen Realisierung des IT-Unternehmens-Nutzens durch den IT-Bereich vorbei!

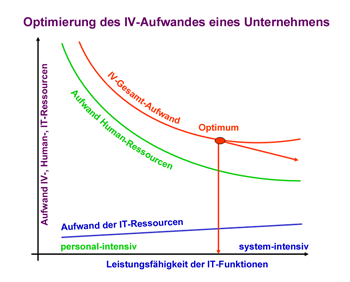

Zur Darstellung der „Enterprise-IT-Produktivität“ haben wir die folgende „Lösungstheorie“ entwickelt. Sie gilt in angepasst Form natürlich auch für den „IT-Bereich“.

Lösungstheorie

Aus unseren umfangreichen Erfahrungen in der IT-Branche und dem beschriebenen Datenmaterial haben wir die folgende Lösungstheorie entwickelt:

- Das IT-Nutzen-Potential eines Unternehmens ergibt sich aus der Differenz der "gegenwärtigen Zusammensetzung der algorithmisierbaren Unternehmens-Informationsverarbeitung aus Human- und Computer-Ressourcen" und der "optimalen Zusammensetzung"

Beweisführung:

Diese offensichtlich erstaunlich kurze und übersichtliche Theorie-Formulierung entspricht in ihrer Substanz der Definition des Computers nach A. Turing! Damit muss ihre Richtigkeit nicht mehr bewiesen werden. Dennoch möchten wir hinzufügen, dass diese Lösungstheorie in den mehr als 25 Jahren ihrer Existenz bei ihrer Verwendung in der Praxis auch von den zahlreichen Fachleuten der verschiedenen Fachrichtungen, insbesondere natürlich auch den Informatikern und Wirtschaftsinformatikern, die dabei beteiligt waren, niemals infrage gestellt worden ist.

Diese Lösungstheorie liefert Theorie-immanent auch die Struktur des Lösungsansatzes: Zu korrelieren sind, wie sofort erkenntlich wird, die Human-Ressourcen für die algorithmisierbare Informationsverarbeitung eines Unternehmens mit den alternativ dazu einsetzbaren Computer-Ressourcen. Daraus folgt die Notwendigkeit einer 2-Dimensionalität des Lösungsansatzes. Und da die aktive Größe der Einsatz der Computer-Ressourcen ist, wird sie üblicherweise auf der x-Achse abgebildet. Die dadurch beeinflusste Größe der Human-Ressourcen ist somit auf der y-Achse aufzutragen.

[Weitere Einzelheiten ]

]

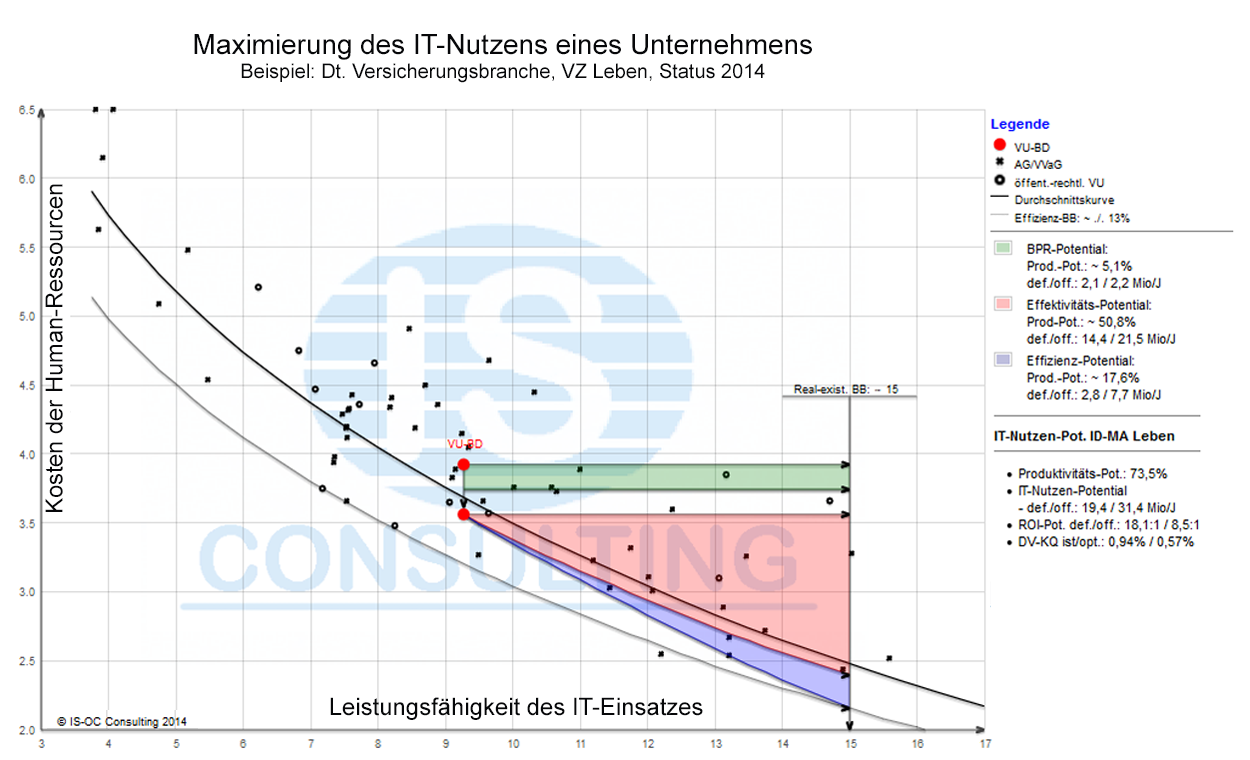

Die Herausforderung, dass nur best-geeignete Versionen der Maßstäbe zu in der Praxis verwertbaren Erkenntnissen führen werden, war uns aufgrund unserer umfangreichen IT-Erfahrung und auch unserer naturwissenschaftlichen Ausbildung von vornherein bewusst. Unsere Start-Zielsetzung lautete deshalb von Anbeginn an: Sind wir in der Lage, für die Achsen Maßstäbe zu entwickeln, die die Unterschiede von voraussichtlich ca. Faktor 2+ zwischen den „Best-Practice-Unternehmen“ und den „Worst-Practice-Unternehmen“ eindeutig zur Darstellung bringen können? Wie die Abb. 1 und Abb. 2 beweisen ist uns dies offensichtlich recht gut gelungen.

Eigentlich wollten wir in dieser Abhandlung nur auf die mit unserem neuen holistischen Methodischen Ansatz zutage geförderten wichtigsten Erkenntnisse zu den Themen „Unternehmens-IT-Produktivität“ und "Produktivität im IT-Bereich" eingehen. Da unsere Recherchen und insbesondere auch das Buch „The Second Machine Age“ (2014) von Erik Brynjolfsson und Andrew McAfee mit dem Kapitel 7 „Computing Bounty“ – nicht Computing Productivity! – uns auf die immer noch fehlende Fähigkeit zur Messung der Unternehmens-IT-Produktivität in holistischer Form nachdrücklich aufmerksam gemacht haben, erscheint es uns angemessen, auf die Hauptursachen kurz einzugehen. Diese sind nach unserer Erfahrung:

- Zu „oberflächliche Maßstäbe“, die nicht genau genug messen können und nur „Punkte-Wolken“ erzeugen,

- Sample mit viel zu inhomogenen Einzel-Unternehmen und

- insbesondere auch einen viel zu schlechten Maßstab zum Messen der Nutzen-Substanz der eingesetzten Computer, bestehend aus bis zu 4 Computer-Architekturen.

Deshalb halten wir es für angemessen, die von uns entwickelten Maßstäbe zu beschreiben, die uns die vielen, für die Praxis ausreichend genauen Unternehmens-IT-Erkenntnisse geliefert haben. Ihr substanzielles Verständnis dürfte auch für eine erfolgreiche Realisierung der Erkenntnisse von erheblicher Bedeutung sein.

Maßstäbe zum Messen der „Produktivität der Enterprise-IT“

Wie bereits dargelegt, messen wir die Produktivität der Unternehmens-IT mit 2-dimensionalen Diagrammen. Deshalb müssen pro Diagramm 2 Maßstäbe entwickelt werden: Ein Ordinaten-Maßstab zum Messen des Unternehmens-IT-Produktivitäts-Nutzens(Produktivität) und ein Abszissen-Maßstab zum Messen der eingesetzten IT-Ressourcen. Der Ordinaten-Maßstab kann die benötigte Messgenauigkeit nur dann liefern, wenn er möglichst genau den durch den IT-Einsatz gestifteten Unternehmens-IT-Nutzen abbilden kann. Daraus folgt die fundamentale Erkenntnis, dass der Ordinaten-Maßstab immer Sample-spezifisch definiert sein muss. Der Abszissen-Maßstab dagegen ist weitgehend Sample-unabhängig.

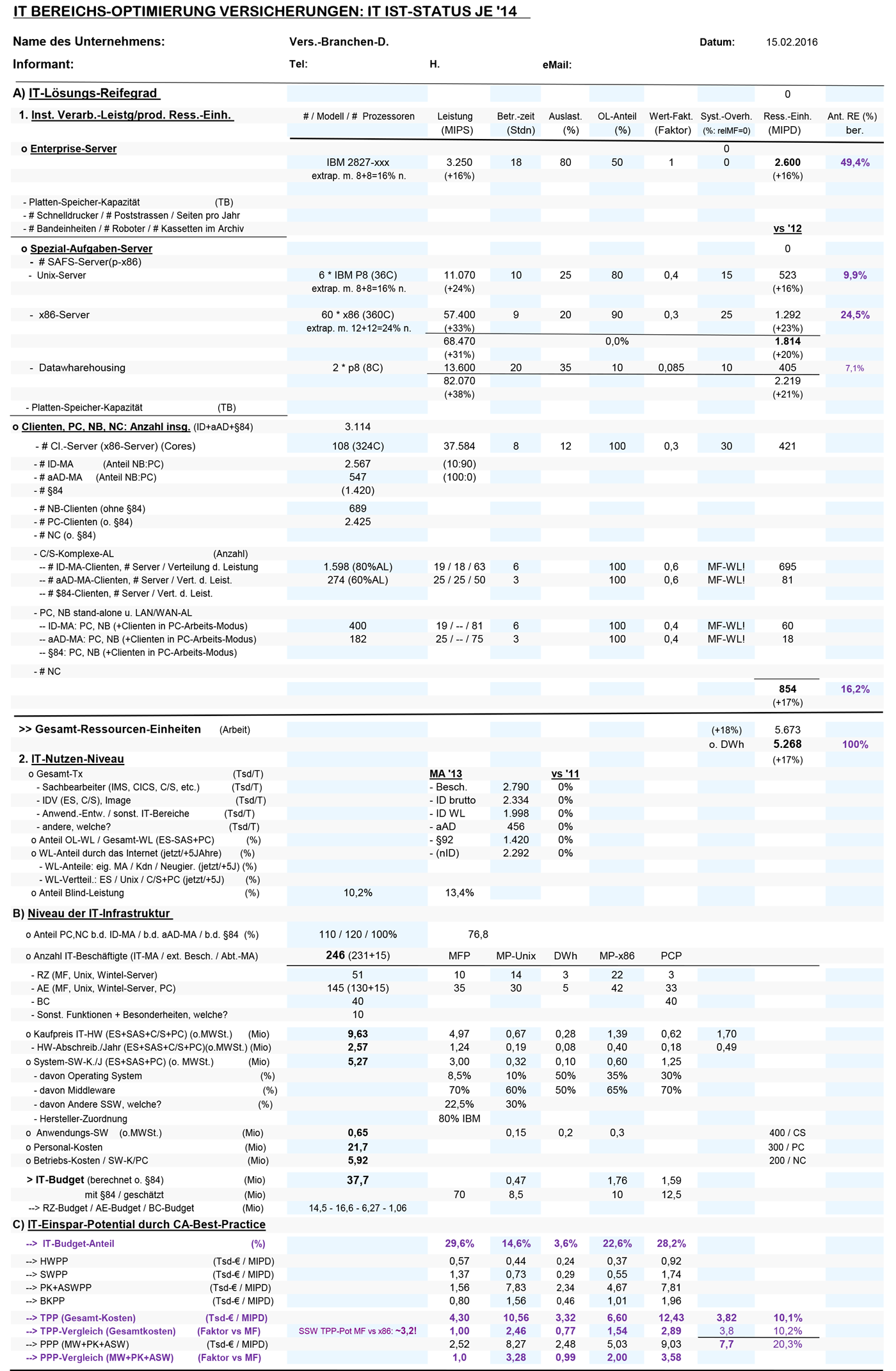

Wie bereits ausführlich erläutert, haben wir unsere Unternehmens-IT-Erkenntnisse am Beispiel der deutschen Versicherungsbranche entwickelt. Deshalb wollen wir nachfolgend die Auslegung der Maßstäbe am Beispiel dieser Branche darlegen (siehe Abb.1).

Auslegung der Ordinate

Abgeleitet aus der Lösungs-Theorie des Computers ist in der Ordinate die „repräsentative algorithmisierbare Informationsverarbeitung-Arbeitslast eines Unternehmens" abzubilden, die alternativ durch „Human-Ressourcen“ oder „Computer-Ressourcen“ realisiert werden kann. In der dt. Versicherungsbranche sind dies entweder die „Brutto Beitrags-Einnahmen (BBE)“ oder die „Anzahl Versicherungs-Verträge“. Für unseren Lösungsansatz sind die BBE die bessere Kennzahl. Für die Auslegung der Ordinate ergibt sich somit der folgende Maßstab: „Human-Ressourcen / BBE“. Der Vollständigkeit halber soll noch erwähnt werden, dass die BBE in die 4 Versicherungszweige „Leben“, „Schaden/Unfall“, „Kranken“ und „Rechtschutz“ unterteilt werden müssen, da die BBE-Einheit in den 4 Versicherungszweigen eine jeweils unterschiedlichen Arbeitslast repräsentiert: : Für die Darstellung des IT-Unternehmens-Nutzens in der gesamten deutschen Versicherungs-Branche müssen deshalb 4 Diagramme entwickelt werden. Und auch die Einzelgrößen „Human-Ressourcen pro VZ“ und „BBE pro VZ“ in den 4 Sample sollten in einem möglichst „normalisiertn Zustand“ verwendet werden. Das dafür benötigte Daten-Material ist über die Geschäftsberichte der Versicherungs-Unternehmen und Branchen-Veröffentlichungen in guter Qualität verfügbar.

Auslegung der Abszisse

Eine ganz grundsätzliche Herausforderung gilt es dagegen bei der Auslegung der Abszisse, der Bestimmung des gesamten IT-Ressourcen-Aufwandes eines Unternehmens, zu bewältigen. Denn in diesem Bereich ist die seit Anbeginn der Entwicklung der IT verwendete Semantik von babylonischem Sprachgewirr nicht zu unterscheiden und das oft wahrscheinlich durchaus auch beabsichtigt! Nach gleicher Definition erstellte Maßstäbe sucht man da vergebens. Ein oft verwendeter, zunächst überzeugend klingender IT-Maßstab heißt "IT-Budget". Sieht man sich aber die Einzelelemente, aus denen das IT-Budget zusammengesetzt ist, näher an, dann erkennt man sofort, dass sowohl diese Einzelelemente unterschiedlich interpretiert als auch die Zusammensetzung in den Unternehmen unterschiedlich realisiert werden. Außerdem wird bei diesem Maßstab unterstellt, dass alle IT-Bereiche die Einzelelemente eines IT-Budgets, d.h. v.a. die Hardware, die System-Software, den Einsatz der IT-Fachleute und die Betriebskosten mit der gleichen Umsetzungseffizienz realisiert haben. Schon die Aufzählung genügt, um erkennbar zu machen, dass das nicht nur nicht der Fall sein wird sondern dass es auch in diesem Bereich sogar sehr große Unterschiede geben dürfte. Die Angebote zur IT-Umsetzungs-Effizienz-Steigerung durch zahlreiche Beratungsfirmen seit vielen Jahrzehnten sind ein eindeutiger Indikator dafür.

Schlussfolgerung: Wer für diese Aufgabenstellung einen Maßstab mit einem angemessenen Qualitätsniveau einsetzen möchte, muss selbst kreativ werden. Dabei sind die folgenden Herausforderungen zu bewältigen:

- Es muss ein "Einheitlicher Maßstab" sein, der den IT-Unternehmens-Nutzen-Beitrag aller 4 gegenwärtig zum Einsatz kommenden Computer-Architekturen, nämlich "Mainframe", "Unix- bzw. Linux-Server", "x86-Server" und "Client/Server und PC" angemessen genau ausmessen kann.

- Der Maßstab muss v.a. die "IT-Netto-Ressourcen" messen können, denn nur diese "produzieren" den IT-Unternehmens-Nutzen, der mit den Human-Ressourcen zu korrelieren ist.

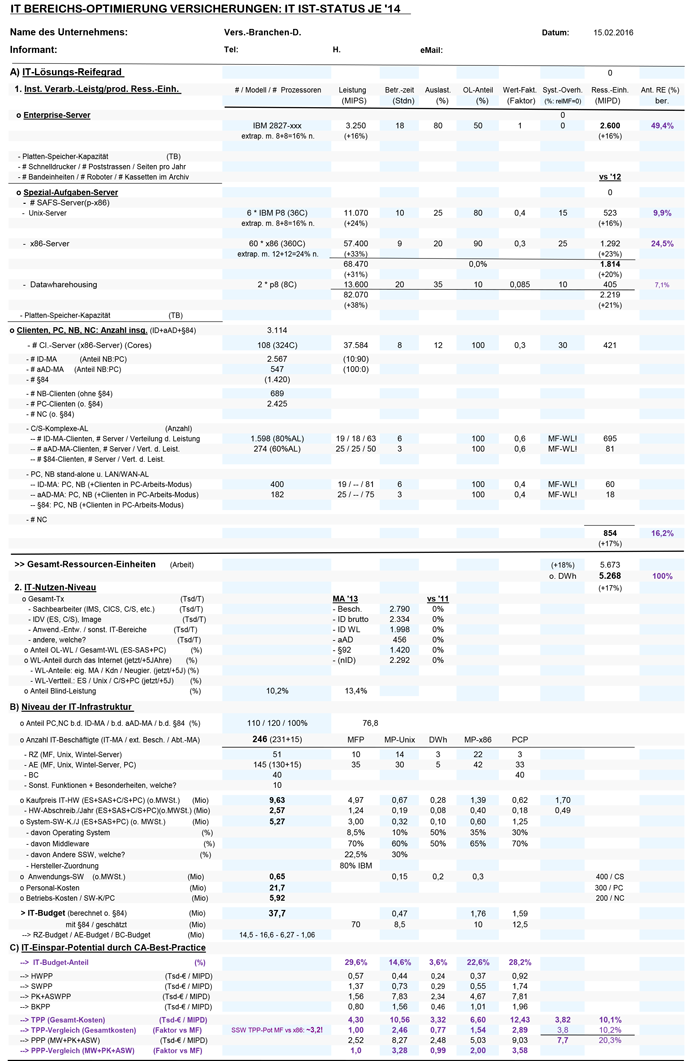

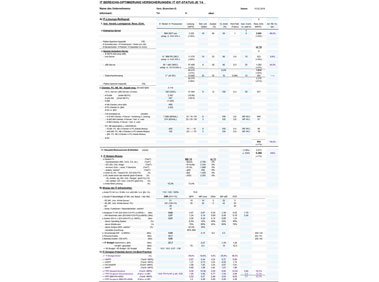

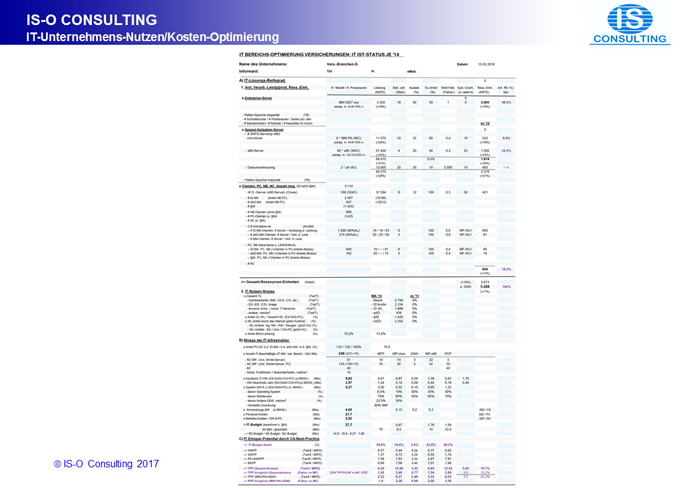

Im Laufe der vielen Jahre der Weiterentwicklung unseres Methodischen Lösungsansatzes haben versucht, das zusätzlich benötigte IT-Datenmaterial auf einer 1-seitigen Excel-Tabelle unterzubringen. Die gegenwärtige Version ist in dieser Tabelle ( &# 11016; 3) abgebildet.

(Die eingetragenen Daten sind repräsentativ für ein VU mit den statistischen Durchschnitt der dt. VB (Status 2014))

(Die eingetragenen Daten sind repräsentativ für ein VU mit den statistischen Durchschnitt der dt. VB (Status 2014))

Ansicht vergrößern

Die Ausgangssituation bei der Aufgabenstellung "Entwickeln eines einheitlichen Maßstabes" sieht gegenwärtig wie folgt aus:

- Für "Mainframes (MF)", die gegenwärtig fast nur noch von IBM angeboten werden, gibt es seit über 50 Jahren die Leistungs-Messgröße MIPS (Million Instructions per Second), von IBM zunächst in der "Messgröße MIPS" veröffentlicht und später als "relative Größenangabe" zur Verfügung gestellt. Diese Angaben gab und gibt es für alle MF! So umfangreiche und präzise Leistungsangaben gibt es bei keinem anderen Hersteller, auch nicht annähernd. Diese MIPS-Messgrößen beschreiben allerdings die Leistungsfähigkeit der MF speziell für kommerzielle Anwendungen!

- Für "Unix-Server" gibt es mehrere Leistungsangaben und zwar sowohl von Herstellern als auch von Leistungsmessungs-Institutionen. Am genauesten sind wieder die Angaben bei IBM für die gegenwärtig angebotenen p-Systeme. Der verwendete Maßstab heißt "rPerf" (relative Performance) und die einzelnen Leistungsangaben sind z.B. im Internet zusammen mit den Computerdaten veröffentlicht. Die rPerf-Angaben gelten aber speziell für technisch/wissenschaftliche Anwendungen. Bei HP und anderen Herstellern findet sich erstaunlicherweise nichts dergleichen!

"Zum Glück" gibt es aber die Möglichkeit, über die zwei "Leistungsmessungs-Institutionen" "TPC" und "SPEC", das Ergebnis von Leistungsmessungen im Rahmen klar definierter Benchmarks einzusehen. Bei kommerzieller Aufgabenstellung sind insbesondere die Leistungsmessdaten bei TPC hilfreich. Die Ergebnisse werden z.B. im Maßstab "tpmC" (Transactions per Minute C-Script) angegeben.

- Auch für die "x86-Server" wird man bei TPC fündig.

- Hinweise über den Leistungs-Beitrag von "Client/Server und PC" lassen sich mit ausreichender Genauigkeit durch "Information Engineering" bei Kennern der Unternehmensanwendungen gewinnen.

Verbleibt "nur" noch die Aufgabe, Umrechnungsfaktoren für die verschiedenen Maßstäbe, zu entwickeln, denn selbst IBM stellt keinen Umrechnungsfaktor von rPerf zu MIPS oder umgekehrt zur Verfügung! Der Grund liegt in der unterschiedlichen Leistungsfähigkeit der Unix-Server, bei denen RISC-Architekturen realisiert sind, bei unterschiedlicher Zusammensetzung von kommerziellen und T/W-Anwendungen. Also heißt es noch einmal "Erfahrungs-Erkenntnisse aktivieren" und „Fachleute-Erfahrungen einsammeln“: Mit erheblichem Wissen über die Stärken und Schwächen der verschiedenen Architekturen der beschriebenen Server und der Charakteristik der auf ihnen zur Ausführung gebrachten Arbeitslast lassen sich die Umrechnungsfaktoren mit ausreichender Genauigkeit abschätzen und durch überprüfen mit der Praxis nachbessern.

Anmerkung 1: Eine sehr viel bessere Lösung wäre natürlich ein Benchmark mit einer "repräsentativen Arbeitslast einer Branche" auf einer "charakteristischen Computer-Konfiguration, die die Computer aller Plattformen dieser Branche umfasst".

Als Entwicklungs- und Testumfeld für diesen Methodischen Lösungsansatz haben wir uns vor inzwischen mehr als 25 Jahren für die deutsche Versicherungsbranche entschieden, da sie uns am geeignetsten erschienen ist. Diese Entscheidung hat sich längst als richtig erwiesen. Da in der dt. Versicherungsbranche 2014 noch 47,3% aller Anwendungen auf Mainframes produziert werden, bleiben wir bis auf weiteres beim gemeinsamen Leistungsmessungs-Maßstab MIPS und, daraus abgeleitet, zur Messung des IT-Unternehmens-Nutzens beim Nutzen-Maßstab "MIPD" (Million Instructions per Day). Wie wir durch eine gezielte Auswertung unseres umfangreichen IT-Unternehmens-Datenmaterials nachweisen können, sollte dieser Anteil zur Realisierung der preiswertesten Unternehmens-IT sogar wieder auf ca. 70% abgehoben werden! Einzelheiten sind unter (www.is-oc.com/itb) zu finden.

Diskussion der Ergebnisse der „Enterprise-IT-Produktivität“

Als erstes müssen wir darauf hinweisen, dass es insbesondere bei vielen Ökonomen erstaunlicherweise immer noch eine Gleichsetzung von „betriebswirtschaftlicher Unternehmens-IT-Produktivität“ und der „volkswirtschaftlicher IT-Produktivität“ zu geben scheint. Dass das nach unseren Erkenntnissen ein grundsätzlicher methodischer Fehler ist, werden wir nachfolgend beweisen!

Unsere Forschung- und Lösungs-Entwicklungs-Tätigkeiten zu diesem Thema im Allgemeinen seit 1985 und speziell fokussiert auf die deutschen Versicherungsbranche seit 1990 haben die Basis gelegt für unsere Abschätzung der realisierten Unternehmens-IT-Produktivitäts-Entwicklung. Dabei können wir auf die folgenden Einzel-Erkenntnisse zugreifen:

- Wie bereits aus Abb.1 herausgemessen werden kann, gibt auch gegenwärtig zwischen den „Best-Practice-Unternehmen“ und den „Worst-Practice-Unternehmen“ der dt. VB im Jahre 2014 immer noch einen IT-Unternehmens-Produktivitäts-Unterschied von ca. Faktor 2,3 oder 130%! Für unsere Analyse ist diese Situation deshalb besonders interessant, weil diese beiden Status in etwa ein IT-Entwicklungs-Zeitfenster von 10 Jahren repräsentieren, da es mindestens 10 Jahre dauern würde, um das Anwendungs-Portfolio der Worst-Practice-Unternehmen auf den Status der Best-Practice-Unternehmen weiterzuentwickeln.

- Auf die jährlichen Unternehmens-IT-Produktivitäts-Status beginnend 1990, Daten-basiert mit jährlicher Fortschreibung der Ergebnisse, die immer auch mit unserer „Kollaborativen Community“ diskutiert worden sind: Das ist ein Entwicklungs-Zeitfenster der letzten 24 Jahre.

- Die Entwicklung der Arbeitslast in der dt. VB bis zurück bis in die 50’er Jahre anhand der Daten des GDV (Gesamtverband der Deutschen Versicherungswirtschaft).

- Und schließlich lassen sich unsere Ergebnisse in Durchschnitts-Kurven darstellen: Damit sind Extrapolationen nicht nur in die Zukunft, wie üblich, sondern natürlich auch in die Vergangenheit Daten-basiert und ausreichend seriös möglich.

Zusammengefasst liefert unser „Holistischer Methodischer Lösungsansatz“ zum Thema „Unternehmens-IT-Produktivitäts-Beitrag in der deutschen Versicherungsbranche“ Daten-basiert die folgenden Kennzahlen:

- Produktivitäts-Fortschritt bei den Innendienst-Mitarbeitern

⃘ Im Branchen-Durchschnitt ca. 220%

⃘ Bei den Best-Practice-Unternehmen ca. 380%

⃘ ROI ca. 6:1

Diese Erkenntnisse über die Unternehmens-IT-Produktivität bei den Innendienst-Mitarbeitern der deutschen Versicherungsbranche lassen sich unschwer auf die deutsche Volkswirtschaft als Ganzes hochrechnen. Die Daten der dt. VB sind exakt bekannt, denn sie werden seit den 50’er Jahren vom GDV jährlich fortgeschrieben und in einem „Statistischen Taschenbuch der Versicherungswirtschaft“ veröffentlicht. Die für diese Abhandlung wichtigsten Kennzahlen sind mit Status 2016:

| ⃘ | Mitarbeiter | 207,2 Tsd | |

| - Innendienst-MA | 159,8 Tsd | ||

| - Angestellter Außendienst | 36,0 Tsd | ||

| - Auszubildende | 11,4 Tsd | ||

| ⃘ | Brutto-Beitrags-Einnahmen Erstversicherung | 194,4 Mrd | |

| - Leben | 90,8 Mrd | ||

| - Schaden/Unfall | 62,5 Mrd | ||

| - Private Krankenversicherung | 37,3 Mrd | ||

| ⃘ | Bestand an Verträgen Erstversicherung | 428,8 Mio | |

Eine Hochrechnung der exakten Erkenntnisse der dt. Versicherungsbranche auf die dt. Volkswirtschaft ergibt das folgende Ergebnis:

- 173 Tsd (nominelle ID-MA) mult. 16,5 Tsd (IT-Budget pro nID-MA) div. ca. 4 (IT-Unterstützungs-Niveau) mal ca. 20 Mio (Angestellte) = 494 Mio BIP oder 15,9%

- nID-MA: „Normalisierte Innendienst-Mitarbeiter. Da die verschiedenen VU Mitarbeiter unterschiedlich stark mit IT-Funktionen unterstützt werden, wird die IT-Unterstützung für die anderen Versicherungs-Funktionen, insbesondere die des angestellten Außendienstes, auf ID-Arbeitslast-Einheit „normalisiert“.

- IT-Budget pro nID-MA: Das Unternehmens-IT-Budget eines Unternehmens des Branchen-Durchschnitts dividiert durch die Anzahl nomineller Innendienst-Mitarbeiter.

- IT-Unterstützungs-Niveau: Das IT-Unterstützungs-Niveau pro angestelltem Mitarbeiter ist in der dt. Versicherungsbranche seit Jahrzehnten mit das höchste und um etwa Faktor 4 höher als im Durchschnitt der dt. Wirtschaft.

- Angestellte: Der leider „schwammige Begriff Angestellte“ soll in dieser Unterlage wie folgt definiert sein: Anzahl akkumulierte Vollzeit-Tätigkeiten in Deutschland, die sich mit Informationsverarbeitung im allgemeinen Sinne beschäftigen.

An dieser Stelle möchten wir daran erinnern, dass wir bereits eine „volkswirtschaftliche Unternehmens-IT-Nutzen-Beitragsrechnung“ im Kapitel (IT-Kosten als komplementäre IT-Nutzen-Mess-Größe?) durchgeführt haben, wobei ein völlig anderer methodischer Ansatz und völlig andere Daten verwendet worden sind. Wenn sich dennoch Ergebnisse derselben Größenordnung, ca. 16% bei der Hochrechnung des „IT-Branchen-Umsatzes“ und 15,9% bei der Hochrechnung des „Status der dt. Versicherungsbranche“, ergeben, dann scheint es sich da eine Erkenntnis mit erheblichem Wahrheitsgehalt zu handeln. Skepsis wird selbstverständlich akzeptiert: Unsere Antwort darauf ist aber ganz einfach: Die Skeptiker brauchen nur die Berechnungen mit eigenem Datenmaterial nachzuvollziehen! An dieser Stelle sei noch daran erinnert, dass beide Berechnungen den „gesamten Unternehmens-IT-Nutzen“ darstellen. Da nach unserem gegenwärtigen Erkenntnisstand davon „nur“ ca. 80% Produktivitäts-Nutzen sein dürfte, müssen „beide Werte“ um 20% verringert werden, wenn speziell nur der Produktivitäts-Anteil der Unternehmens-IT diskutiert werden soll.

Wenn es somit durchaus möglich ist, den „Unternehmens-IT-Nutzen“ und auch die „Unternehmens-IT-Produktivität“ mit ausreichender Eindeutigkeit und Genauigkeit zu bestimmen, welche Konsequenzen sollten daraus gezogen werden? Wie aus der Skizzierung der IT-Landschaft offensichtlich wird, ist zur Realisierung des IT-Unternehmens-Produktivitäts-Nutzens zunächst eine Fokussierung auf die Antriebskräfte und die Interessenschwerpunkte nötig. Hinzu kommen weitere Herausforderungen:

- Die Korrektur des Erlahmens der Weiterentwicklung der Unternehmens-IT von in den 70’er und 80’er Jahren (20-25)% Leistungs-Steigerung pro Jahr auf gegenwärtig nur noch ca. (10-12)% pro Jahr.

- Verhinderung von Fehlentscheidungen bei den IT-Produkte-Anschaffungen aufgrund der Verwendung zu trivialer und deshalb falsche Ergebnisse produzierender Maßstäbe.

- Ausmerzen punktueller, taktischer IT-Entscheidungen, die nicht als strategische Fehlentscheidungen erkannt werden können. Unsere Empfehlung: Die Unternehmen sollten ihre Methoden zur Steuerung der Unternehmens-IT zügig auf einen „Holistischen Unternehmens-IT-Entscheidungsansatz“ weiterentwickeln mit der Zielsetzung des Unternehmens-IT-Einsatzes auf „Best-Practice-Niveau“.

Nach unserer Erkenntnis liegt der Schwerpunkt des Handlungsbedarfs fast ausschließlich auf Seiten der Unternehmen. Der für die volkswirtschaftlichen Belange zuständige Staat kann nur die Rahmenbedingungen optimieren, in Deutschland insbesondere dafür sorgen, dass es keinen IT-Fachkräfte-Mangel gibt.

Widerlegung des „IT-Produktivität-Paradoxons“

Unsere beiden Daten-basierten Berechnungen ergeben für die Produktivitäts-Steigerung durch die Unternehmens-IT einen Wert von bisher insgesamt ca. 12,8% (80% von 16%) in Deutschland im Jahre 2014!

Die These vom „IT-Produktivitäts-Paradoxon“ von Herrn Solow wurde aber schon 1987 aufgestellt und mit Untersuchungen in den USA begründet. Deshalb müssen vor einer kritischen Diskussion basierend auf unseren deutschen Ergebnissen aus dem Jahre 2014 zur Herstellung einer Vergleichbarkeit Anpassungen von Zeitpunkt und Land durchgeführt werden.

- Als erstes wollen wir versuchen, den IT-Produktivität-Fortschritt während des Zeitunterschieds von 30 Jahren auszugleichen: Nach unserer Datenmaterial aus der dt. VB hat sich der Produktivitäts-Beitrag durch die Unternehmens-IT in den 30 Jahren Zeitunterschied in etwa verdoppelt.

- IT-Fachleuten seit langem wohl vertraut ist die Tatsache, dass in den USA der Einsatz der IT weiter fortgeschritten war und immer noch ist, als in den anderen westlichen Ländern. Der Faktor von fast 2 beim IT-Aufwand pro Beschäftigten ist eine zuverlässig richtige Größe. Um eine doppelte Menge an IT-Ressourcen in Unternehmens-Nutzen umzusetzen benötigen diese i.d.R. ca. 5 Jahre. Der Nutzen-Fortschritt in dieser Zeit war in der dt. VB ca. 20%.

- Damit können wir nunmehr den Produktivitäts-Beitrag der Unternehmens-IT in Deutschland mit Status 2014 auf die Ausgangs-Situation von Herrn Solow USA mit Status 1987 transformieren nach der Formel: 12,8% div. 2 mal 1,2 = 7,7%.

- Daraus ergibt sich die folgende erste, spontane Widerlegungs-These: Nach unserer langjährigen Erfahrung lassen sich Maßstäbe zum Messen des ökonomischen Einflusses der IT mit einer Messgenauigkeit von besser als 10% eher selten finden. Schlussfolgerung aus dieser Situation: Herr Solow wollte ein „Signal“ messen, das kleiner war als das „Rauschen“ im „Mess-System“. Also kein „Paradoxon“ sondern ein Messversuch in einem „ungeeignete System“. Diese These wird übrigens auch von nicht wenigen Kritikern vertreten, allerdings immer ohne einen Daten-basierten Beweis anzutreten.

Natürlich ist uns geläufig, dass diese „erste Widerlegungs-These“ angreifbar ist. Deshalb wollen wir nunmehr die

- „Zweite, Methoden-basierte und damit exakte Widerlegungs-These“ darstellen, die wie folgt lautet:

„Der Maßstab BIP misst den „Beitrag der Unternehmens-IT-Produktivität zum BIP“ grundsätzlich falsch, Denn der Maßstab BIP misst den Unternehmens-IT-Produktivitäts-Fortschritt in Form einer Verringerung des BIP-Beitrags!“