IS-O CONSULTING

Unternehmensberatung zur IT-Unternehmens-Nutzen/Kosten-Optimierung

Fundamental neue Erkenntnisse

Realisierung des maximalen IT-Unternehmens-Nutzens

IT-Nutzen-Projekte in den Unternehmen entstehen bisher pragmatisch aus lokalen Anforderungen und Erkenntnissen. Sie durchlaufen ein Unternehmens-übliches Ausleseverfahren und werden realisiert, weil sie ein Nutzen-Potential erschließen, das größer ist als der üblicherweise als Maßstab vorgegeben "interne Zinsfuß" oder weil sie eine sogenannte "Muss-Aufgabe" betreffen.

Aus dieser Situation lässt sich zum Thema "wie groß ist der Unternehmens-Nutzen der IT?" grundsätzlich schlussfolgern, dass es bei diesen "lokalen Projekten" i.d.R. problemlos möglich ist, den IT-Nutzen des IT-Projektes auf 1 oder 2 Seiten auch betriebswirtschaftlich eindeutig zu beschreiben. Daraus ergibt sich aber bereits die fundamentale Erkenntnis, dass es einen IT-Nutzen für die Unternehmen sehr wohl gibt. Diese praktische Erfahrung über die IT-Nutzen-Gewinnung hat seit Anbeginn der IT und bei vielen Unternehmen bis in die Gegenwart ausgereicht, den IT-Einsatz in den Unternehmen dynamisch voranzutreiben. Erst in den letzten Jahren und insbesondere in den Ländern der so genannten westlichen Welt mit ihrem inzwischen hoch-entwickelten IT-Einsatz wird zunehmend die Frage aufgeworfen, ob die IT nicht allmählich an das Ende ihres Entwicklungs-Potentials zu stoßen beginne. Auch aus diesem Grunde erscheint es uns immer wichtiger, die Wahrnehmung des Nutzens der Informationsverarbeitung von einer lokalen, Geschäftsprozess- und Abteilungs-orientierten Sichtweise auf eine unternehmensweite, holistische Sichtweise zu transformieren.

In diesem IT-Erkenntnis-Umfeld die These von einem "IT-Nutzen-Paradoxon" aufzustellen, erscheint uns, zurückhaltend ausgedrück, ausgesprochen erstaunlich, so geschehen übrigens durch Herrn Robert Solow, ausgezeichnet mit dem Nobel-Preis für Wirtschaftswissenschaften: "You can see computing everywhere but in the productivity statistics" (Solow 1987). Ehrlicher wäre wohl einzugestehen, dass man für eine offensichtlich anspruchsvolle Fragestellung keine Lösung zustande gebracht hat. Auch aus dieser Situation lassen sich mindestens die folgenden Erkenntnisse ableiten: Für die Beantwortung der Schlüsselfrage der IT "wie viel Geld sollte ein Unternehmen für seine Informationsverarbeitung ausgeben?" gibt es keinen trivialen Lösungsansatz. Und um den IT-Unternehmens-Nutzen darstellbar zu machen, braucht man "hochqualifiziertes Analysewerkzeug", das man darüber hinaus auf "bestgeeignete Unternehmens-Teil-Bereiche" ansetzen muss. Der Ansatz von Herrn Brynjolfsson, der von der Wirtschaftsinformatik dafür immer wieder in den Zeugenstand gerufen wird, erfüllt beide Kriterien mit Nichten und kann deshalb, auch theoretisch leicht beweisbar, gar keine qualifizierten Erkenntnisse zutage fördern. (siehe auch Kapitel Methodischer Ansatz). Dass sich insbesondere die deutsche Wirtschaftsinformatik dennoch immer noch hinter der These vom IT-Paradoxon "verschanzt", führt auch zu der grundsätzlichen Fragestellung: Welche wertvollen Beiträge zum Fortschritt der IT hat die WI bisher tatsächlich zustande gebracht?

Offensichtlich reichen die bisher eingesetzten "IT-Nutzen-Erkenntnisse liefernden Quellen" immer weniger aus, um das maximale IT-Nutzen-Potential eines Unternehmens erkennbar zu machen. Die bisher üblichen Quellen sind bekanntlich in unterschiedlicher Ausprägung: "Die Betriebsorganisation" der Unternehmen, die "Unternehmensplanung", "Controlling", die "interne Unternehmensberatung", die "Attaches der Anwendungsentwicklung" in den Fachabteilungen, auch "ausgewählte Mitarbeiter der AE" und "Kreativitäts-Veranstaltungen" wie Six Sigma. Hinzu kommen noch von Fall zu Fall "Expertisen von Unternehmensberatungen" und "Anregungen von Computer-Herstellern" sowie "Lösungs-Ideen auf Fachveranstaltungen". Allen diesen Quellen ist gemeinsam, dass sie eine punktuelle, lokale, induktive Perspektive der IT repräsentieren. Und festzuhalten ist zusammenfassend, dass alle diese Quellen die jetzige Situation als Ergebnis hervorgebracht haben und deshalb anscheinend keinen Ausweg anbieten können! Werkzeuge zur IT-Nutzen-Realisierung gibt es offensichtlich ausreichend viele. Woran es aber zu mangeln scheint, ist deren Ausrichtung auf betriebswirtschaftlich definierte, legitime, auf die Optimierung des IT-Unternehmens-Nutzens ausgerichtete IT-Zielvorgaben.

Zur Realisierung des maximalen IT-Unternehmens-Nutzens bedarf es offensichtlich eines völlig neuen methodischen Herangehens an die Erkenntnisgewinnung, wie sie z.B. ein holistischer-deduktiver Methodischer Lösungsansatz anbieten kann. Als Quellen der Erkenntnis sind vorhanden die "Pools der Kollektiven Intelligenz qualifizierter Erkenntnisträgergruppen der Praxis", auch unpräzise als "Schwarmintelligenz" bezeichnet, aus denen mittels "Business Analytics for Decision Know-how" die Einzelerkenntnisse für Unternehmen gewonnen werden können. Dieser Ansatz ist ähnlich aber offensichtlich "Erkenntnis-ranghöher" als die seit etwa 2 Jahrzehnten als Datawarehousing propagierte Geschäftsdaten-Analyse. Anmerken möchten wir an dieser Stelle, dass uns die erste Version unseres Methodischen Lösungsansatzes schon im Jahre 1985 gelungen ist, also lange vor dieser inzwischen populären Strömung.

Ein holistischer Lösungsansatz hat die folgenden fundamentalen Vorteile:

Diese durch Benchmarking der Kollektiven Intelligenz einer repräsentativen Gruppe verfügbar werdenden Erkenntnisse repräsentieren offensichtlich die gegenwärtig maximal erreichbare Erkenntnistiefe. Übertragen auf die Schlüsselfrage der Informationsverarbeitung: "Wie viel Geld sollte ein Unternehmen für seine Informationsverarbeitung ausgeben (um den max. IT-Unternehmens-Nutzen bei geringstmöglichem IT-Aufwand zu realisieren)?" bedeutet das: Unser Methodischer Lösungsansatz liefert alle Voraussetzungen, um diese Aufgabenstellung gegenwärtig bestmöglich zu lösen und die Lösungen mit geringsten Aufwand zu realisieren und zu aktualisieren.

Geringste IT-Unternehmens-Kosten bei gegenwärtigem und bei maximalem IT-Unternehmens-Nutzen

Bemerkenswerterweise lässt sich seit vielen Jahren mit einem aus der Sicht der IT-Unternehmens-Nutzen-Optimierung/Maximierung betrachtet eher unwesentlichen IT-Unternehmens-Nutzen-Sub-Thema die i.d.R. eine viel größere Aufmerksamkeit erzielen: Der Minimierung der IT-Kosten eines Unternehmens bei der Produktion des "gegenwärtigen IT-Unternehmens-Nutzens". Auch dies dürfte darauf zurückzuführen sein, dass den vielen relativ überschaubaren und immer nur singulär auftretenden IT-Projekt-Nutzen-Aussagen die geballte Größe der gesamten IT-Unternehmens-Kosten gegenüber gestellt wird. Daraus entstanden sind eine quasi permanente Unzufriedenheit mit den IT-Unternehmens-Kosten und der Reflex-artige Wunsch und die andauernden Versuche, diese IT-Kosten zu drücken "ohne Ende" und des Öfteren auch mit dem unbeabsichtigten Ergebnis "koste es was es wolle" im Gesamtunternehmen. Völlig aus dem Blickfeld geraten ist dabei die Erkenntnis, dass es sich bei den so genannten IT-Kosten betriebswirtschaftlich betrachtet in Wirklichkeit um "Unternehmens-Investitionen" handelt, die v.a. mittels "Produktivitätssteigerungen bei den Geschäftsprozessen" Unternehmens-Nutzen, insbesondere auch im Bereich der Unternehmens-Profitabilität, produzieren.

Mit unserem Methodischen Lösungsansatz zur IT-Unternehmens-Nutzen/Kosten-Optimierung lässt sich, wie an dieser Stelle der Darstellung unseres MLA bereits bekannt sein dürfte, durch Differenzierung der Unternehmen in ihre Haupt-Aufgabenbereiche eine systematische Abgrenzung und Ressourcen-Zuordnung vornehmen. Zu diesen Haupt-Aufgaben-Bereichen eines Unternehmens zählt bekanntlich seit zahlreichen Jahrzehnten auch der IT-Bereich. In der dt. Versicherungsbranche (VB), unserer Testbranche, waren im IT-Bereich 2014 im Branchendurchschnitt unverändert 9,2% aller Innendienst-Mitarbeiter beschäftigt. Für den eindeutig abgrenzbaren IT-Bereich lässt sich unser Methodischer Lösungsansatz dieses Mal zur Kosten-Optimierung/Minimierung Lösungs-konform ebenfalls zum Einsatz bringen. Bei der Bezeichnung der Zielgrößen wollen wir zum leichteren Verständnis beim Ober-Begriff "Practice" bleiben. Präziser wäre die Bezeichnung "IT-Investment" z.B. in der Version "MI" für IT "Minimal-Investment", was aber zunächst wahrscheinlich eher zur Verwirrung führen könnte, da es sich selbstverständlich um die "minimalen Investitionen bei der Realisierung des gegenwärtigen oder des maximalen Unternehmens-Nutzens" handelt.

Eine Beschreibung der Struktur und der Vorgehensweise zur Erkenntnisgewinnung mit unserem Methodischen Lösungsansatz ist im Kapitel (Methodischer Ansatz) zu finden.Wenn man die durch die Lösungstheorie vorgegebene Vorgehensweise auf den IT-Bereich anwendet, dann analysiert man v.a. die Produktivität im IT-Bereich. Dabei stellt sich natürlich sofort die Frage, ob dieser Ansatz angemessen ist oder ob nicht die Fokussierung auf zunächst andere Kosten-Segmente des IT-Bereiches einen höheren Ertrag liefern würde. Die Antwort ergibt sich dabei schon aus den Fakten wie von selbst. In der dt. VB hat sich das IT-Budget 2014 im Branchendurchschnitt wie folgt zusammengesetzt: HW-Kosten (Abschreibung) 10,1% pro Jahr, System-SW-Kosten 16,5% pro Jahr, IT-Personal-Kosten 59% pro Jahr und Betriebs-Kosten 14,5% pro Jahr. D.h., die IT-Personal-Kosten, zu denen auch noch ein Teil der Betriebskosten hinzuzurechnen sind, um die Variable "Kosten pro IT-Arbeitsplatz" zu erhalten, sind schon seit längerer Zeit der absolut dominante Teil des IT-Budgets. Außerdem ist Fachleuten seit langem bekannt, dass es große Unterschiede bei der Produktivität des Einsatzes der IT-Mitarbeiter in den einzelnen Unternehmen gibt. Angemerkt sei an dieser Stelle, dass die Optimierung/Minimierung auch der anderen 3 IT-Kosten-Segmente Teil der Optimierung des IT-Bereiches mit diesem MLA ist.

Auslegungen von Ordinate und Abszisse

Die wichtigste Weiterentwicklung des „Verständnisses der Unternehmens-IT-Verarbeitung“ sehen wir in Notwendigkeit der Transformation von „einer Einrichtung zur Produktion von Einzel-Anwendungen“ zur "Produktions-Anlage für die vom Unternehmen, den Mitarbeitern und Kunden, benötigten Informationen". Eine Produktionsanlage wird über das Preis/Leistungs-Verhältnis des „Outputs“ gesteuert, das v.a. durch das Zusammenspiel von Produktions-Mitteln und Produktions-Mitarbeitern bestimmt wird.

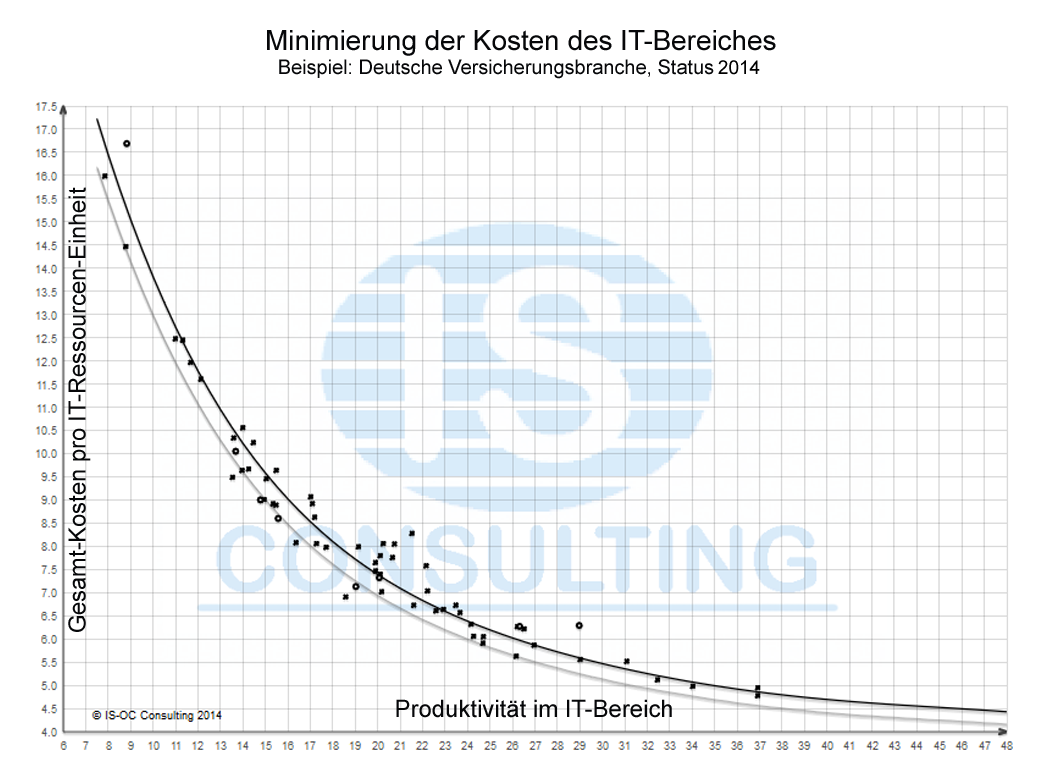

Die Auslegung der Maßstäbe zum Messen des IT-Bereichs-Kosten-Einsparpotentials bei Erhöhung der Produktivität der IT-Mitarbeiter ist aufgrund der sehr viel größeren Homogenität dieses Analyseumfeldes wesentlich einfacher als die Auslegung der Maßstäbe zum Messen des IT-Unternehmens-Nutzens. Die Arbeitslast im IT-Bereich wird am besten durch die Kenngröße "Anzahl Ressourcen-Einheiten" (Beschreibung siehe Kapitel Methodischer Ansatz) beschrieben. Das Potential einer IT-Kosten-Reduzierung im IT-Bereich durch Produktivitätssteigerung bekommt man somit, wenn man die "IT-Gesamt-Kosten pro Ressourcen-Einheit" als Ordinate ins Verhältnis setzt zur Produktivität im IT-Bereich, ausgedrückt in "IT-Ressourcen-Einheiten pro IT-Mitarbeiter" als Abszisse. Das Ergebnis für die dt. Versicherungsbranche ist nachfolgend dargestellt.

Beispiel: Korrelation "IT-Gesamt-Kosten pro RE" vs "Produktivität im IT-Bereich" der dt. Versicherungs-Branche

Erkenntnisse aus der Korrelation "IT-Gesamt-Kosten pro RE" vs "Produktivität im IT-Bereich"

Offensichtlich gibt es bei diesem Beispiel aus der deutschen Versicherungsbranche eine ganz eindeutige Korrelation zwischen den IT-Gesamt-Kosten und der Produktivität im IT-Bereich. Die noch vorhandene, aber erstaunlich geringe Streuung ist v.a. auf Unterschiede bei den HW-, System-SW- und Betriebs-Kosten der IT-Bereiche zurückzuführen und unterstreicht die überragende Bedeutung der IT-Personalkosten. Bemerkenswert ist außerdem der große Unterschied zwischen den "Best-Practice-VU" und den "Worst-Practice-VU", von etwa Faktor 4. Ein gewisser Teil dieses Unterschieds ist auch auf „Economy-of-scale“-Nachteile zurückzuführen, deren Größe mit diesem MLA offen gelegt und heutzutage über die Cloud teilweise ausgeglichen werden kann. Auch die offensichtlich weniger bedeutendes Einspar-Potential bietenden Bereiche HW-, SSW- und Betriebs-Kosten können natürlich mit einer dafür ausgelegten Korrelation unseres Methodischen Lösungsansatzes optimiert werden.

Für die Analyse des IT-Bereiches eines Versicherungsunternehmens können bei dieser Aufgabenstellung alle VU der Branche herangezogen werden, da sich die Arbeitslast auf den Systemen auch bei unterschiedlicher Zusammensetzung aus den bis zu 5 verschiedenen Versicherungszweigen nicht wesentlich unterscheidet. Deshalb konnten in diesem Fall die Daten von 97 der insgesamt 101 VU zur Erkenntnisfindung verwendet werden. Damit ist die Wahrscheinlichkeit sehr groß, dass alle Erkenntnis-starken Unternehmen in diesem Sample enthalten sind.

Bestimmung des Einspar-Potentials im IT-Bereich auf "gegenwärtigem IT-Unternehmens-Nutzen-Niveau"

Die fundamentale Schwäche aller bisherigen Ansätze in der dt. VB zur IT-Bereichs-Kosten-Optimierung/Minimierung, bei denen i.d.R. die IT-Budgets ins Verhältnis gesetzt werden zu den Brutto-Beitragseinnahmen ohne Unterscheidung der Versicherungszweige, besteht in dem Fehlen der zentralen Einflussgrößen "bisher realisiertes IT-Unternehmens-Nutzen-Niveau" und "Differenzierung nach VZ"! Dass ein höheres IT-Unternehmens-Nutzen-Niveau nur möglich ist, wenn dafür auch höhere IT-Kosten akzeptiert werden, ist trivial und sofort einsichtig, denn ansonsten könnte man sofort ein "ökonomisches Perpetuum Mobile" konstruieren. Und das gibt es bekanntlich in der Ökonomie so wenig wie in den Naturwissenschaften. Daraus ergibt sich aber zwingend, dass das Benchmarking von IT-Bereichen nur zulässig ist bei Berücksichtigung des durch den IT-Bereich gegenwärtig realisierten IT-Unternehmens-Nutzen-Niveaus. Die Differenzierung nach Versicherungszweigen ist notwendig, wenn die BBE (oder auch die Anzahl Versicherungs-Verträge) im Maßstab verwendet werden, denn die Arbeitslast pro BBE unterscheidet sich in den verschiedenen VZ 2013 um bis zu Faktor 3,22! Bei unserem MLA verwenden wir die Messgröße "IT-Ressourcen-Einheiten produziert durch alle im Unternehmen eingesetzten Computer", bei der das realisierte IT-Unternehmens-Nutzen-Niveau indirekt berücksichtigt wird und die BBE eliminiert sind. Damit können wir nunmehr "zum Ernten der Erkenntnisse" schreiten, die durch die Korrelation "IT-Gesamt-Kosten pro Ressourcen-Einheit vs Produktivität im IT-Bereich" verfügbar werden.

Bestimmung des Einspar-Potentials im IT-Bereich mittels "Ranking" und "Business Case" relativ zu "Best-Practice"

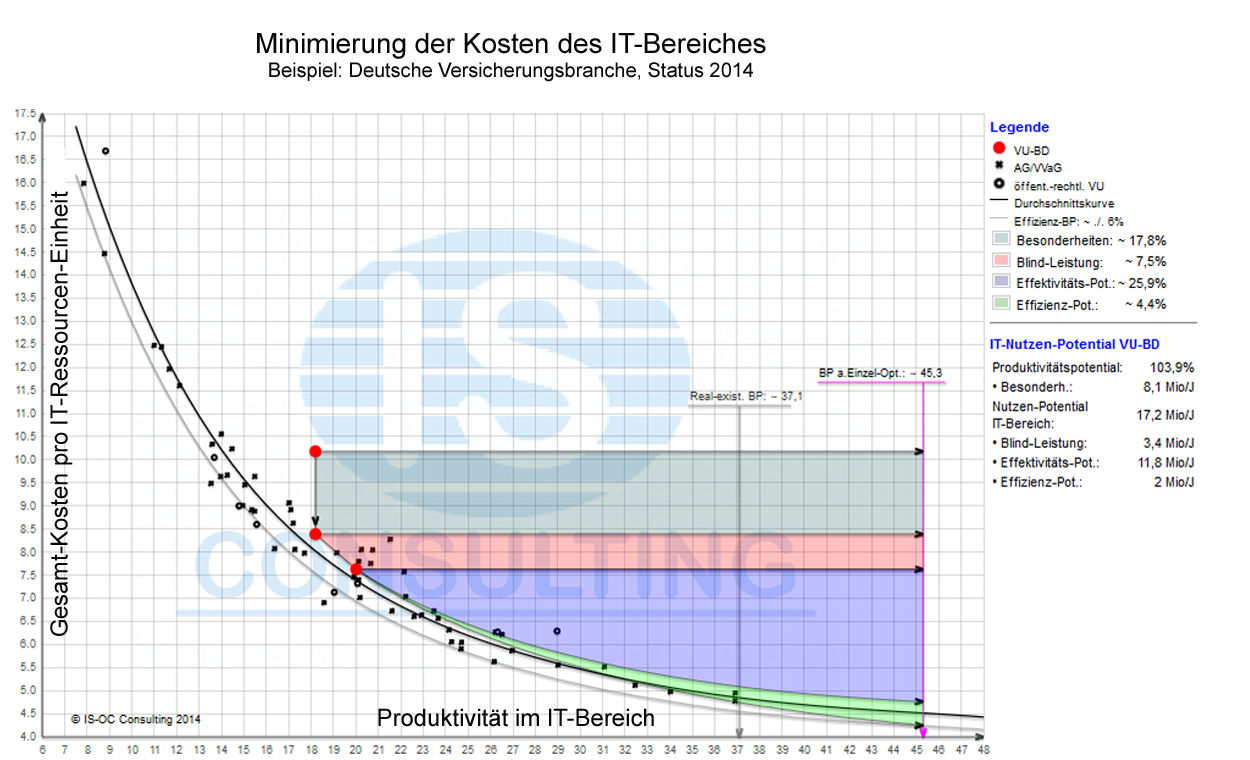

Nachdem wir des Weiteren für den IT-Bereich die Effektivitäts- und die Effizienz-Best-Practice-Zielgrößen festgelegt haben, können wir nunmehr das IT-Bereichs-Kosten-Einspar-Potential jedes einzelnen Unternehmens relativ zu BP in betriebswirtschaftlichen Messgrößen und unterteilt in die 4 Kosten-Einspar-Potential-Segmente bestimmen.

Führungserkenntnisse "Ranking" und "Business Case"

Die Schlüsselfrage am Beginn der Analyse des IT-Bereiches lautet wieder "Gibt es überhaupt Handlungsbedarf im IT-Bereich?" D.h., können Einspar-Potentiale auf dem gegenwärtig realisierten IT-Unternehmens-Nutzen-Niveau erschlossen werden? Zunächst wird also wieder ein "Ranking" vorgenommen, entweder absolut zu den Best-Practice oder relativ zu den Haupt-Wettbewerbern oder auch relativ zu den Konzern-Schwesterunternehmen in Deutschland oder weltweit, gefolgt durch eine "Potential-Bestimmung" i.d.R. mittels "Business Case" zunächst noch ohne weitere Unterteilung in HW-, SSW- Personal- und Betriebskosten.

Bei der "Betriebswirtschaftlichen Modellrechnung" sollte wieder wie folgt vorgegangen werden:

- Ausgangs-Position ist die "auf Branchendurchschnitt normalisierte IT-IST-Position".

- Als Ziel-Position steht bei diesem Ansatz die "wesentlich Erkenntnis-reichere Position Effektivitäts-und Effizienz-Best-Practice aus Einzel-Optimierung" zur Verfügung.

- Da das ev. vorhandene IT-Unternehmens-Nutzen-Potential aus bis zu 4 völlig unterschiedlichen Potential-Segmenten bestehen kann, nämlich dem "IT-Effektivitäts-Potential", dem "IT-Effizienz-Potential", dem "Potential durch Beseitigung der Blind-Leistung" und dem "Potential durch Beseitigung von Besonderheiten", sollte es insbesondere mit Blick auf die unterschiedlichen Vorgehensweisen bei der Realisierung bei der Potential-Darstellung schon in diese 4 Teil-Potential-Segmente unterteilt werden.

"IT-Effektivitäts-Potential" und "IT-Effizienz-Potential"

Zunächst ist es erfahrungsgemäß wieder notwendig, diese 4 IT-Potential-Segmente kurz zu definieren. Die semantische Unterscheidung zwischen Effektivität und Effizienz haben wir bereits in Kapitel (IT-Unternehmens-Nutzen) vorgenommen.

Auf die Realisierung im IT-Bereich eines Unternehmens übertragen heißt das:

- Das Effektivitäts-Potential des IT-Bereiches gewinnt ein Unternehmen durch das Ausschöpfen der IT-Funktions-Potentiale in der Anwendungsentwicklung, im RZ und beim Benutzer-Service auf State-of-the-Art-IT-Niveau, ersatzweise auf BP-Niveau.

- Das Effizienz-Potential des IT-Bereiches dagegen gewinnt das Unternehmen, wenn es die vorhandene IT-Funktionalität optimal zum Einsatz bringt.

Einspar-Potential durch "Beseitigung der Blind-Leistung" auf den Computern"

Auch auf Computern wird "Schein-Leistung" produziert ähnlich der Blind-Leistung bei elektrischen Systemen: Deshalb halten wir es für gerechtfertigt, diese Bezeichnung sinngemäß in die Computerbranche zu übernehmen.

Als "Vorgänger der Blindleistung" kann man den Ende der 60'er Jahre in die Diskussion geratenen "System-Overhead" auf Mainframes anführen, der insbesondere in der ersten Hälfte der 70'er Jahre in der wissenschaftlichen Informatik leidenschaftlich diskutiert worden ist. Mit der dynamischen Verbesserung des Preis/Leistungs-Verhältnisses und der damit einher gehenden stark abnehmenden Bedeutung der HW-Systemkosten ist dieses spezielle Thema aber seit langem "eingeschlafen".

Was dabei anscheinend übersehen worden ist, ist die Erkenntnis, dass es Overhead in allen Bereichen der Auslegung der IT-Infrastruktur in einem Unternehmen geben kann und mit der Diversifizierung der Computer-Strukturen in den Unternehmen quasi unvermeidlich im zunehmenden Umfang auch gibt. Unvermeidlich insbesondere auch deshalb, weil es bisher keine Erkenntnisse über die Existenz dieser Blindleistung, ihre Bestimmung und daraus abgeleitete Vorgehensweisen zu deren Zurückdrängung bis hin zur Minimierung gegeben hat. Auch ITIL bietet da keine Lösung.

Was wir unter "Blindleistung in der IT" zusammenfassen wollen ist der unnötige IT-Ressourcen-Verbrauch heutzutage insbesondere durch veraltete ineffiziente Anwendungspragramme, ineffiziente IT-Infrastrukturen, ineffiziente Daten-Speicherung und -Archivierung und nicht-optimalen Einsatz der Anwendungsentwicklungs-Architekturen, Methoden und Tools. Durch Positionierung eines Unternehmens relativ zur optimalen IT-Umsetzungs-Effizienz bei gleichem IT-Ressourcen-Einsatz lässt sich die Gesamtgröße der Blindleistung erstmals in etwa abschätzen. Nur in etwa deshalb, weil zunächst die Unterteilung in "sinngemäß sogenannte organisatorische Blindleistung" und "IT-Blindleistung" vorgenommen werden muss und weil der Beseitigung der gesamten IT-Blindleistung Unternehmens-strukturelle Hindernisse im Wege stehen können. In der deutschen Versicherungsbranche gibt es Unternehmen, die seit vielen Jahren i.d.R. ziemlich gleichbleibend sehr wahrscheinlich bis über 30% Blindleistung auf ihren Computern produzieren! Bei der Festlegung der Größe der zu beseitigenden Blindleistung sollte man unbedingt den dazu notwendigen unterschiedlichen Aufwand mit einplanen: Nach unserer langjährigen Erfahrung sind die ersten ca. 2/3 mit überschaubaren Aufwand zu beseitigen, der bei dem darüberhinaus gehenden Anteil aber stetig stärker werdend ansteigt. Wir weisen deshalb beide Werte aus.

Einspar-Potential im IT-Bereich durch die "Beseitigung von funktionellen IT-Besonderheiten"

Da bei unserem Methodischen Lösungsansatz der Branchendurchschnitt die Referenzgröße darstellt, sind auch im IT-Bereich vor einem Vergleich der IST-Situation mit dem Branchendurchschnitt Abweichungen durch "Besonderheiten an der IT-Infrastruktur" und "Branchen-übliche Abgrenzungen der IT-Zuständigkeiten" zu berücksichtigen. Die üblichen Abweichungen betreffen gegenwärtig v.a. die Bereiche "Aufwendungen für Katastrophenvorsorge" und "Aufwendungen für Datenschutz und Datensicherheit" sowie bei den "Abgrenzungen des IT-Einsatzes den IT-Aufwand für die unterstützten, nicht zum Unternehmen gehörigen Beschäftigten" wie z.B. in der dt. VB den "§92-Außendienst" und den "nebenberuflichen Außendienst".

Führungserkenntnisse mittels "Business Case"

Hat das "Ranking" zu dem Ergebnis geführt, dass ein wesentliches Einspar-Potential im IT-Bereich vorliegt, dann stellt unser MLA die folgende Vorgehensweise zur dessen genauer betriebswirtschaftlichen Bestimmung zur Verfügung:

Als Erstes ist von der IST-Position als Ausgangs-Position für den BC der "Einfluss der Besonderheiten" abzuziehen und der "Einfluss der IT-Blindleistung" abzubilden.

- Der Einfluss der Besonderheiten ergibt sich als relative Ordinaten-Differenz.

- Der Einfluss der Blindleistung dagegen führt zu einer Positionsverschiebung der Steigung der Durchschnittskurve nach "links oben" folgend. Denn die Blindleistung benötigt praktisch keinen IT-Personal-Aufwand und ist deshalb von den IT-Ressourcen abzuziehen, was den tatsächlichen IT-Automatisierungsgrad verringert und die Kosten pro nützlicher Ressourcen-Einheit erhöht. Die Größe der Blindleistung ergibt sich aus den "IT-Unternehmens-Nutzen-Diagrammen" und zwar aus dem Abstand der "normalisierten IST-Position" eines Unternehmens von der "Kurve der maximalen Umsetzungs-Effizienz". Dabei ist zunächst festzulegen, wie groß der Anteil dieser Ineffizienz ist, der auf das Konto der Unternehmens-Organisation und wie groß der Anteil ist, der auf das Konto der IT-Prozess-Unterstützung geht. Wenn dafür keine ausreichenden Erkenntnisse vorhanden sind, sollte erfahrungsgemäß mit der Annahme 50:50 begonnen werden. Eine Verbesserung kann jederzeit erfolgen. Von der mit dieser Annahme festgelegten Größe der Blindleistung sind nach unserer Erfahrung ca. 2/3 mit überschaubarem Aufwand zu beseitigende "einfache Blindleistung".

- Das Einspar-Potential durch die Beseitigung der Besonderheiten ergibt sich unmittelbar.

- Als nächstes ergibt sich das Einspar-Potential durch Beseitigung der "einfachen Blindleistung" aus der Ordinatendifferenz der Positionen "IT-Ressourcen bei normalisierter BL" und "IT-Ressourcen incl. BL".

- Das Effektivitäts-Potential im IT-Bereich ergibt sich nunmehr aus der Differenz der Ordinatenwerte bei Parallel-Verschiebung der IST-Position zur Branchendurchschnittskurve bis auf das Niveau "Best-Practice aus Einzel-Optimierung".

- Das Effizienz-Potential im IT-Bereich ergibt sich schließlich aus dem verbleibenden Delta gebildet durch die IT-Effektivitäts-Ordinate auf BP-Niveau und dem Ordinaten-Punkt "Effektivitäts-und Effizienz-Best-Practice aus Einzel-Optimierung".

- Potential für Produktivitäts-Fortschritt in (%)

- Anzahl betroffene IT-Beschäftigte

- IT-Kosteneinspar-Potential in (Mio €)

Die Zielgröße "Best-Practice aus Einzel-Optimierung"

Um es erneut unmissverständlich zum Ausdruck zu bringen: Auch die Zielgröße "Best-Practice aus Einzel-Optimierung" ist nur eine Ersatz-Zielgröße anstelle der das "State-of-the-art-Optimum" beschreibenden Zielsetzung, allerdings eine, die ein um ca. 15-20% höheres Nutzen-Potential im IT-Bereich realisierbar macht als die Zielgröße "real-existierende Best-Practice". Und sie stellt für die meisten IT-Bereiche wieder eine ganz wesentliche Erkenntnis-Verbesserung gegenüber der IST-Situation dar. In der deutschen Versicherungsbranche z.B. würde eine Verbesserung des "IT-Bereiches des durchschnittlichen Versicherungsunternehmens" auf das Niveau der "BP aus Einzel-Optimierung" zu einer Verbesserung der Produktivität im IT-Bereich um etwa 122% und bei den "Worst Practice" sogar um bis zu 420% führen. Erläuterungen zu den "verschiedenen Realisierungs-Niveaus von Best-Practice" sind im Unter-Kapitel (Die Zielgröße Best-Practice) zu finden.

Theoretische Erkenntnisse zur Kosten-günstigsten Verteilung der IT-Ressourcen auf Computer-Architekturen

Dass im Laufe der Computer-Evolution Computer-Architekturen für spezialisierte Workloads (WL) entwickelt worden sind, zunächst insbesondere für technisch/wissenschaftliche Anwendungen, weil sie diese WL dadurch preiswerter bearbeiten können, ist natürlich jedem IT-Fachmann bekannt. Dass diese spezialisierten Computer auch alle anderen WLs bearbeiten können, ist singulär getrachtet, eine triviale Feststellung. Alles andere als trivial ist dagegen die Beantwortung der in den letzten 10-15 Jahren immer dringender einer Beantwortung harrenden Fragestellung: In welcher Verteilung sollten die in einem Unternehmen auftretenden verschiedenen WLs auf die gegenwärtig zur Verfügung stehenden Computer mit bis zu 4 verschiedenen spezialisierten Computer-Architekturen verteilt werden, damit dadurch die kosten-günstigste Gesamt-Lösung entsteht? Bei den 4 verschiedenen spezialisierten Computer-Architekturen handelt es sich bekanntlich um "Mainframe-Server", "Unix-Server", "x86-Server" und die „Schnittstelle mit Verarbeitungs-Fähigkeit zum Benutzer „Clienten-Server+PC“. In Vergessenheit scheint anscheinend der Grund für die CPU-Spezialisierung geraten zu sein, nämlich die Situation, dass Anfang der 70’er Jahre die MF-CPU’s noch etwa 40% der IT-Budgets „verschlungen“ haben. Dieses Kosten-Segment ist inzwischen auf nur noch 1-2% zusammengeschmolzen! Daraus folgt aber, dass heutzutage andere IT-Kosten-Segmente in den Mittelpunkt der IT-Bereichs-Optimierung gestellt werden müssen, nämlich v.a. die inzwischen auf etwa 59% des IT-Budgets angewachsenen IT-Personal-Kosten.

Bei der Beantwortung der Fragestellung nach der kostengünstigsten Verteilung der WL kommen sofort und unvermeidlich fundamentale Interessen vor allem der Hersteller der Computer mit den verschiedenen Computer-Architekturen aber auch der IT-Fachleute in den Unternehmen ins Entscheidungs-Spiel! Insbesondere die Hersteller der Computer, die heutzutage praktisch alle mit einer US-amerikanischen Marketing-Philosophie auftreten, kämpfen meist mit harten Bandagen: Von "Winners-only-Lösungen" weit entfernt würde vielen "Kühlschränke an Eskimos zu verkaufen" keine Gewissens-Probleme bereiten. Von den Herstellern ist somit keine objektive Beratung zu erwarten, falls jemand überhaupt jemals so blauäugig gewesen sein sollte, dieses anzunehmen. Und auch die Mitarbeiter bei den Anwendern haben oft subjektive, v.a. auch Ausbildungs-geprägte, und ihre scheinbar best-mögliche berufliche Zukunft im Auge habende Interessen.

Folglich sollte man anscheinend konsequentermaßen die angeblich kompetente und neutrale IT-Wissenschaft um Rat fragen: In Deutschland also die Informatik oder auch die Wirtschafts-Informatik! In den angelsächsischen Ländern, wie dem "Mutterland der IT", den USA, heißt dieses Ausbildungs- und Forschungs-Fachgebiet für IT-Fachleute übrigens "Computer Science". Die Fächer Informatik und Wirtschaft-Informatik gibt es da interessanterweise gar nicht! Das Ergebnis einer Analyse des Know-hows, das die Forschung dieses Fachgebietes bisher zustande gebracht hat, ist leider ernüchternd: Denn die Informatik befasst sich bisher v.a. ausführlich mit der HW- und SW-technischen Funktionalität von Computern im Einzelnen, nicht dagegen mit der fundamentalen Fragestellung aus Unternehmenssicht: Mit welchem Preis/Leistungs-Verhältnis können die wichtigsten WLs eines Unternehmens auf den Computern der verschiedenen Architekturen produziert werden? Und daraus abgeleitet: Welches ist die kostengünstigste Verteilung der WLs auf die gegenwärtig zur Verfügung stehenden bis zu 4 Architekturen? Und die Wirtschafts-Informatik scheint sich für diese Thematik gar nicht zuständig zu halten.

Verbleiben schließlich noch die IT-Unternehmensberatungen: Doch auch da wird man gegenwärtig nur bei einem Unternehmen fündig, nämlich bei uns, IS-O Consulting!

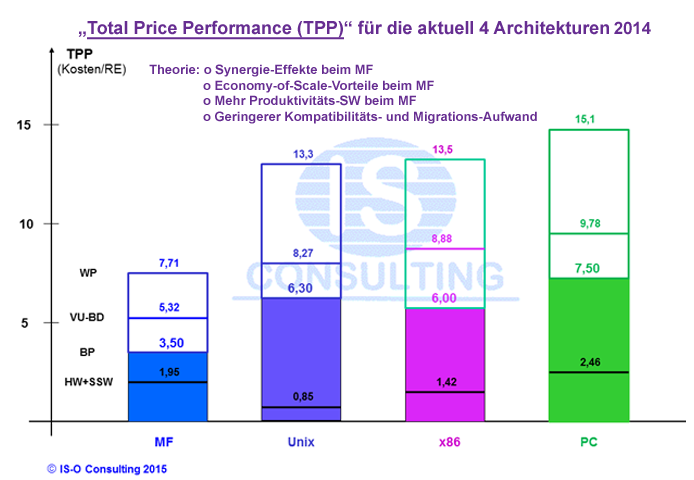

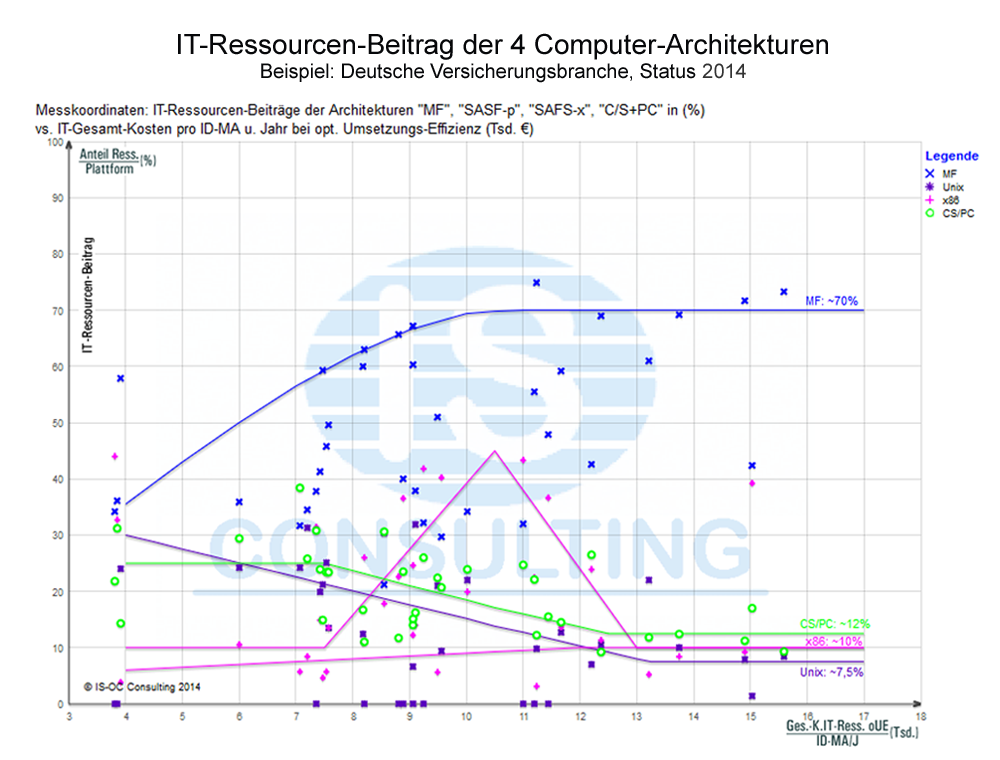

Ansatz von IS-O Consulting

Uns ist die Lösung der Aufgabenstellung: "Kosten-günstigste Verteilung der IT-Ressourcen auf die 4 derzeit möglichen Computer-Architekturen (CA)" als ein Teilbereich bei der IT-Ressourcen-Ermittlung für ein Unternehmen im Rahmen unserer "globalen Zielsetzung der IT-Unternehmens-Nutzen/Kosten-Optimierung" quasi als "attraktives Nebenprodukt" in den Schoß gefallen (siehe auch "Geringste IT-Unternehmens-Kosten/Investitionen bei gegenwärtigem und bei maximalem IT-Unternehmens-Nutzen"). Denn bei der Auslegung der Abszisse unseres "Haupt-Diagrammes zur IT-Unternehmens-Nutzen/Kosten-Optimierung" hatten wir die Aufgabe zu bewältigen, die IT-Ressourcen-Beiträge aller in einem Unternehmen eingesetzten Computer, also der Beiträge der Computer mit bis zu 4 verschiedenen Computer-Architekturen, gemessen üblicherweise jeweils mit nur für diese Architektur entwickelten Maßstäben, zu einem einzigen Maßstab zusammenzufügen. Wenn das gelingt, was bekanntermaßen ziemlich herausfordernd aber durchaus möglich ist, dann hat man die Frage nach der "Kosten-günstigsten Verteilung der IT-Ressourcen auf die 4 derzeit möglichen Computer-Architekturen" methodisch betrachtet schon mit beantwortet: Denn dann kann man den "Anteil der IT-Ressourcen jeder der bis zu 4 Computer-Architekturen in Prozent der gesamten Unternehmnes-IT-Ressourcen" ins Verhältnis setzen zum "Anteil des IT-Budgets eingesetzt für die einzelnen Computer-Architekturen ebenfalls ausgedrückt in Prozent". D.h., man erzeugt das Holistische (US-amerikanisch "total" genanntes) Preis/Leistungsverhältnis "TPP" (Total Price Performance) pro eingesetzter Computer-Architektur! Durch dieses "lokale Unternehmens-individuelle Benchmarking der CA" wird für die einzelnen Unternehmen sofort betriebswirtschaftlich eindeutig erkennbar, welche Computer-Architektur in der IST-Situation das "beste Preis/Leistungs-Verhältnis" aufweist und wie groß der TPP-Vorteil der besten CA zu den anderen CA ist. Wenn man darüberhinaus die IT-Ressourcen-Verteilungs-Situation eines einzelnen Unternehmens vergleicht mit der bei möglichst vielen anderen Unternehmen einer Branche, in unserem Fall der dt. Versicherungsbranche, d.h. ein "Branchen-weites Benchmarking" durchführt, dann lässt sich mit großer Eindeutigkeit die "kosten-günstigste Verteilung der IT-Ressourcen auf die 4 derzeit möglichen Computer-Architekturen" bestimmen.

Da sich der Wettbewerb für kommerzielle Unternehmens-Anwendungen der inzwischen nur noch 4 Computer-Architekturen in den letzten Jahren immer weiter zugespitzt hat, insbesondere zu einem Wettbewerb zwischen der „MF-Architektur“ und der „Architektur der x86-Server“, und geprägt ist durch unglaubliche Fehlentscheidungen, die zu einer „Losers-only-Konstellation“ geführt haben, haben wir uns entschlossen, mit unserem umfangreichen, hoch qualifizierten Datenmaterial über die Unternehmens-IT auch für diese Aufgabenstellung eine wissenschaftlich fundierte Lösung zu entwickeln. Diese ist unter (www.is-oc/ca) aufrufbar.

In der Theorie und in der Kommunikation ist dieser Lösungsansatz offensichtlich sehr einfach, in der Praxis haben wir aber noch keinen "IT-Fachmann eines Unternehmens" und auch keinen "zuständigen Mitarbeiter eines Computer-Lieferanten" kennen gelernt, der diese scheinbar simple "Preis/Leistungs-Korrelation" versucht geschweige denn auch zustande gebracht hat! Einige der wichtigsten zu lösenden Aufgabenstellungen wollen wir nachfolgend kurz skizzieren.

Unternehmens-Nutzen produzierende "Computer-Arbeits-Einheiten" nicht "theoretische Computer-Leistungsfähigkeit"

Erstaunlicherweise verwenden selbst die IT-Bereiche der größten deutschen Versicherungen in ihren Geschäftsberichten im "Kapitel IT-Kennzahlen" nur Aussagen über die "theoretische Computer-Leistungsfähigkeit der eingesetzten Computer, wie MIPS bei den MF, Anzahl Server bei den Unix- und x86-Servern und Anzahl eingesetzte PC und das auch noch immer fehlerhafter! Denn bei den Unix- und x86-Servern und den PC fehlt sogar die Angabe über die theoretische Leistungsfähigkeit, da heutzutage bekanntlich nicht mehr die Anzahl der Server sondern die Anzahl der produzierenden Cores die beste Kennzahl für die theoretische Leistungsfähigkeit der eingesetzten Server und PC darstellt. Bei den von uns verwendeten "IT-Ressourcen-Einheiten" handelt es sich dagegen selbstverständlich um "Arbeits- oder Unternehmens-Nutzen-Einheiten" also um die "tatsächlich aktivierte Computer-Leistung (Auslastung) mal Betriebszeit mal System-Auslastung mal Wertigkeit der WL mal System-Overhead", d.h. um die Arbeit aller Computer, die den gesamten Unternehmen-Nutzen produzieren. Pointierter Hinweis: Ein Auto mit der theoretischen Leistung von z.B. 300 KW, das nur in der Garage rumsteht, produziert bekanntlich "null Arbeits- oder Besitzer-Nutzen-Einheiten, d.h. null gefahrene Km". Einer der fundamentalen Fehler der Argumentation in der IT besteht heutzutage immer noch darin, dass bei Entscheidungen praktisch immer noch v.a. von der "brutto Leistungsfähigkeit" der eingesetzten Computer ausgegangen wird und nicht von den Unternehmens-Nutzen-produzierenden "realisierten netto Arbeits-/Nutzen-Einheiten"! Dabei wird unvermeidlich übersehen, dass sich das Verhältnis von brutto Leistungsfähigkeit zu realisierte netto Arbeits-/Nutzen-Einheiten bei den verschiedenen Computer-Architekturen fundamental unterscheidet: In der dt. VB 2014 gibt es die folgenden Unterschiede: Beim Mainframe den Faktor ca. 1,25, bei den Unix-Servern den Faktor ca. 21 und bei den x86-Servern den Faktor ca. 51!

Totales Preis/Leistungs-Verhältnis (TPP)

TPP nicht TCO

Weshalb empfehlen wir nachdrücklich den neuen Maßstab "Totales Preis/Leistungs-Verhältnis (Total Price-Performance, (TPP)) bei der Auswahl der Preis/Leistungs-besten IT-Architektur, wo es doch bereits seit 1987 den von Bill Kerwin, Research-Direktor Gartner Inc., im Auftrag von Microsoft(!) entwickelten und seit mehreren Jahren auch bei Entscheidungen für die Unternehmens-IT scheinbar allgemein akzeptierten Maßstab "TCO (Total Cost of Ownership)" gibt? Weil der Maßstab TCO für die Auswahl der preiswertesten IT-Architektur für eine neue Anwendung oder vergleichbare IT-Entscheidungen ungeeignet ist, sowohl vom „Methodischen Ansatz“ her als auch in Bezug auf „das dafür notwendige Datenmaterial“, und deshalb sowohl falsche als auch noch viel zu ungenaue Ergebnisse produziert, also quasi eigentlich doppelt ungeeignet ist!

Der "Methodische Ansatz TCO" ist ungeeignet, weil beim TCO-Ansatz eine Vorgehensweise unterstellt wird, als ob eine neue Anwendung auf einem singulären Server realisiert wird, es sich theoretisch betrachtet um "eine Addition" in einem "Multi-Server-Verarbeitungs-Umfeld, d.h. einer Server-Farm", handele. Bei der Realisierung auf einem MF ist es dagegen eine "Integration" in ein bereits vorhandenes umfangreiches "Multi-Programming-Verarbeitungsumfeld, d.h. üblicherweise einem 2 Server-Verarbeitungsumfeld"! Bei einer Integration entstehen anders als bei einer Addition weitere erhebliche Vorteile, wie "Synergie-Vorteile" und "Skalen-Vorteile", insbesondere im Personalkosten-Bereich. Hinzu kommen des Weitern Vorteile des MF in den Bereichen "Kompatibilitäts- und Migrations-Aufwand" wegen der viel größeren Homogenität des Lösungsansatzes. Und schließlich wurden für den MF in seiner langen Entwicklungszeit zahlreiche „Produktivitäts-Tools“, so genannte Middleware, entwickelt. Das führt zu einem großen Vorteil des MF im Personalkosten-Bereich, der in der dt. VB gegenwärtig im Branchendurchschnitt bereits 59% (incl. ASW) des IT-Budgets ausmacht, d.h. absolut Entscheidungs-dominant ist mit weiter steigender, ökonomisch nicht gerechtfertigter, Tendenz. Diese Vorteile können mit einer Vorgehensweise, die auf einer Addition beruht, theoretisch eindeutig erkennbar, nicht dargestellt werden. D.h. die TCO-Ergebnisse für die Bestimmung der preiswerteren Alternative für eine neue Anwendung, z.B. die Frage "zentrale integrierte Verarbeitung" oder "dezentrale singularisierte Server-Farm-Verarbeitung", sind grundsätzlich immer falsch und benachteiligen dabei die "zentrale integrierte Verarbeitungs-Alternative" fundamental und zwar unabhängig von der Architektur der verwendeten Server! Der von uns entwickelte "Methodische Ansatz TPP" ist dagegen ein holistisch-deduktiver und beinhaltet deshalb beide Alternativen, sowohl "Integration" als auch "Addition".

Die 2. große Schwachstelle des Maßstabes TCO ist ganz offensichtlich das benötigte Datenmaterial aus der Zukunft einer Anwendung. Bei TCO müssen die Daten über die gesamte Lebensdauer einer neuen Anwendung geschätzt werden, d.h. in der dt. VB üblicherweise einer Lebensdauer von 9-10 Jahren und im Einzelfall auch noch viel länger! Da fällt einem unwillkürlich das "Comedy-Urteil" des Münchner Originals Karl Valentin ein: "Prognosen sind schwierig, insbesondere wenn es sich dabei um die Zukunft handelt". In der Praxis werden die TCO-Ergebnisse deshalb sehr häufig als zu Marketing-geprägt abgelehnt! TPP hat dagegen den großen Vorteil, nur aktuelle, also eindeutig messbare IT-Daten zu verwenden.

Nach Einführung des Maßstabes TPP ist der Erkenntnisrahmen für die Verteilung aller Anwendungen eines Unternehmens auf die gegenwärtig bis zu 4 verfügbaren Computer-Architekturen klar definiert.

Die "Best Practice" Arbeitslastverteilung auf die gegenwärtig bis zu 4 Computer-Architekturen

Als Ausgangsbasis zur Festlegung der kostengünstigsten Arbeitslastverteilung empfiehlt sich zunächst eine Zuordnung zu den 2 Fundamental-Charakteristiken von Anwendungs-Programmen: „Innere Struktur der Arbeitslast“ und „Nutznießer der Arbeitslast“. Bei der „Inneren Struktur der Arbeitslast“ unterscheidet man bekanntlich praktisch seit Anbeginn der IT zwischen „Kommerzieller Arbeitslast“ und „Technisch/Wissenschaftlicher Arbeitslast“, wobei neuerdings verstärkt ein weiterer Arbeitslast-Typ hinzukommt, den man „Lexikalische Arbeitslast“ oder auch „Inquiry Woarkload“ bezeichnen könnte, wie er beispielhaft bei „Wikipedia“, Google“ und auch ausgeprägt bei „Amazon“ vorkommt. Die „innere Struktur der Arbeitslast“ beeinflusst v.a. das Arbeitsergebnis der verwendeten CPU-Architektur, d.h. die Kosten des CPU-Anteils der Enterprise-Server-HW. Das Kriterium „Nutznießer der Arbeitslast“, nämlich „Unternehmens-Anwendungen“ oder „Abteilungs-Anwendungen“ bestimmt dagegen v.a. die Größe und Leistungsfähigkeit der Peripherie. Die Größe der von den Unternehmensanwendungen benötigten Peripherie ist fast unabhängig von der Architektur der eingesetzten Server, erfahrungsgemäß mit Vorteilen für den MF, der auf diesem Gebiet ca. 50 Jahre Erfahrung akkumuliert hat und deshalb über eine sehr leistungsfähige Ein/Ausgabe-Architektur zum Datenaustausch mit der Peripherie verfügt. Bei einer holistischen Vorgehensweise wie bei diesem Methodischen Lösungsansatz, bei dem das IT-Budget auf der obersten Differenzierungs-Ebene zunächst unterteilt wird in „HW-Kosten pro Jahr“, „System-SW-Kosten pro Jahr“, „Personal-Kosten (pro Jahr)“ und „Betriebs-Kosten pro Jahr“, wird sofort erkennbar, dass das wichtigstes Unterscheidungs-Kriterium die IT-Personal-Kosten sind, die, wie bereits erwähnt, in der dt. Versicherungsbranche im Branchendurchschnitt für gegenwärtig (2014) 55,8% (inklusive Anwendungs-SW sogar 59,0%) des IT-Budgets stehen - mit einer Streuung von ca. 45-66% - und eine steigende Tendenz aufweisen!

Daraus ergeben sich die folgenden Schlussfolgerungen:

Die HW-Kosten genießen anscheinend im „Nachhall der Vergangenheit“, als System-Kosten fast ausschließlich HW-Kosten waren und davon wieder ca. 2/3 CPU-Kosten, bei den Entscheidungen immer noch eine völlig unangemessen starke Aufmerksamkeit. Sie sind aber inzwischen, wie eine genauerer Analyse offenbart, fast unbedeutend, denn sie betragen im Durchschnitt der dt. VB nur noch ca. 10,1% des IT-Budgets, davon ca. 5,0% HW-Kosten für die „Unternehmens-Informationsverarbeitung“, für die bei den großen Versicherungen in Deutschland praktisch ausschließlich MF eingesetzt werden. Welche Erkenntnisse ergeben sich daraus für eine Situation, bei der die strategische Entscheidung gefällt werden soll, welche IT-Architektur für eine „neue Unternehmens-Anwendung das „Beste TPP“ bietet, gegenwärtig v.a. eine Entscheidung zwischen den MF- und x86-Servern?“: Bei einer Unternehmens-Anwendung ist der Kostenanteil der MF-CPU z.Z. im Branchendurchschnitt gerade noch ca. 22% der MF-System-HW-Kosten oder ca. 1,26% des IT-Budgets, der Rest sind Peripherie-Kosten. Daraus folgt: Selbst wenn die angeblich so preiswerten x86-Server-CPUs, eine MF-CPU hat übrigens die Leistungsfähigkeit von bis zu 10 maximal ausgebauten x86-CPUs, für einen Bruchteil der MF-CPU-Kosten verfügbar wäre, ließen sich die HW-Kosten nur um max. 1,26% reduzieren! Denn die Peripherie-Kosten sind für beide Alternativen in etwa gleich hoch, beim MF wegen der besseren Skalierbarkeit und der besseren Anschluss-Funktionalität wahrscheinlich eher etwas geringer als bei den benötigten viel zahlreichern x86-Servern.

Viel bedeutender sind heutzutage die System-SW-Kosten und damit die seit etwa einem Jahrzehnt immer stärker werdende Kritik an den angeblich inzwischen viel zu hohen System-SW-Kosten des MF. Die SSW-Kosten sind heutzutage in der Tat bereits erheblich höher sind als die System-HW-Kosten und machen in der dt. VB 16,5% des IT-Budgets aus, wovon auf den MF ca. 9,7% entfallen. Das ist allerdings wiederum nur „die Oberfläche“ des SSW-Kosten-Bildes! Denn der notwendige Blick des Fachmanns entdeckt, dass sich diese 9,7% SSW-Kosten zusammensetzen aus „Betriebs-System-Kosten“ von nur ca. 8,5% oder 0,81% des IT-Budgets und „Middleware (MW)-Software-Kosten“ von ca. 70% oder 6,8% des IT-Budgets, d.h. dass v.a. die Kosten für die MW „verantwortlich“ sind für den Kosten-Unterschied! Middleware besteht v.a. aus „IT Produktivitätswerkzeugen“ und hilft eine komplexe kommerzielle Multi-Programming-Verarbeitungs-Umgebung möglichst effektiv zu realisieren. Eine leistungsfähige Middleware senkt somit die IT Personal-Kosten. Der notwendige Aufwand für MW ist außerdem de facto wieder Architektur-unabhängig. Ein Vergleich der TPP der Software-Kosten des MF mit der TPP der SW-Kosten z.B. der x86 Server fällt in der dt. VB mit 1,4:1,0 nur noch scheinbar leicht zuungunsten des MF aus. Bei der Differenzierung der gesamten SSW in u.a. die Einzelbereiche „Operating SW“ und „Middleware (SW)“ zeigt sich dann noch klarer, dass beim MF v.a. die Middleware-Kosten mit einem Verhältnis von ca. 1,5:1,0 den Schwerpunkt der MF SSW darstellen. Der Vergleich der Kosten der Operating SW zeigt dagegen ein Verhältnis von ca. 0,6:1,0 mit zunehmenden Vorteil für den MF, da die OSW-Kosten beim MF in den letzten 10 Jahren um ca. 14% gefallen sind, wie die Geschäftsberichte der IBM offenlegen! Nach dieser Quelle sind nur die Kosten für die Middleware um ca.79% gestiegen. Bei einer Analyse der IT-Bereichsdaten der dt. VB lässt sich daraus die bemerkenswerte Hypothese ableiten, dass der durchschnittliche Anstieg der Netto-Arbeitslast auf den Computern der dt. VB in den letzten 10 Jahren von ca. 10-12% pro Jahr nur deshalb mit etwa der gleichen Anzahl IT Mitarbeiter bewältigt werden konnte, weil sich die Produktivität im IT Bereich durch den Einsatz von immer leistungsfähigerer MW, natürlich auch bei den Wettbewerbern, mit einer vergleichbaren Geschwindigkeit erhöhen ließ. Erkennbar wird aber an dieser Stelle der Analyse erneut, dass der Hauptunterschied bei den Personal-Kosten zutage treten wird.

Wir werden versuchen, weiteres belastbares Datenmaterial zusammenzutragen, um den Vergleich weiter zu detaillieren. Als Zwischenbilanz beim SSW-Kosten-Vergleich lässt sich aber bereits feststellen, dass auch die Behauptung von den viel zu hohen System-SW-Kosten des MF in ihrem Wesen widerlegt ist. Diese Erkenntnis lässt sich aber nur gewinnen, wenn die Analyse auf der Basis des einzig ausreichend qualifizierten Maßstabes der „realisierten netto Arbeits-/Nutzen-Einheiten eines Unternehmens“ durchgeführt wird.

Aus den bisherigen Zwischenergebnissen ergibt sich, wie bereits mehrfach festgestellt, die eindeutige Erkenntnis: Die Entscheidung über die Architektur mit der besten TPP fällt bei den nachfolgend analysierten Personal-Kosten. Das evidenz-basiert Ergebnis lautet: Bei der „TPP der Personal-Kosten“ hat der Mainframe wegen seiner „Synergie-Vorteile“, seiner „Skalen-Vorteile“, seiner „Vorteile bei der Kompatibilität und der Migration“ und seiner umfangreichen und ausgereiften Produktivitäts-SW für kommerzielle Arbeitslast das mit Abstand Beste Preis/Leistungsverhältnis!

Wie bereits mehrfach erwähnt, betragen die IT Personal-Kosten in der dt. VB im Durchschnitt ca. 55,8% des IT Budgets. Ein Vergleich der TPP der Personal-Kosten des MF mit den TPP der Personal-Kosten z.B. der x86 Server fällt in der dt. VB mit 0,4:1,0 äußerst eindeutig zugunsten des MF aus! Eine weitere Differenzierung der IT Personal-Kosten in RZ-Personal-Kosten und AE-Personal-Kosten ergibt bei einem Vergleich des MF wieder mit den x86-Servern in der dt. VB die folgenden Ergebnisse: Bei den RZ-Personal-Kosten ein Verhältnis von ca. 0,2:1 und bei den AE-Personal-Kosten ein Verhältnis von ca. 0,55:1. Das führt „in der Summe“ zu der in (Abb. 5) und (Tabelle 4) dargestellten eindeutig besten TPP beim MF.

Diese Situation liefert des Weiteren die fundamentale Erkenntnis, dass insbesondere die Kosten der Middleware, die bei genauer Betrachtung als "Investitionen in die Produktivität des IT Bereiches" eines Unternehmens zu erkennen sind, beim "Benchmarking von Computer-Architekturen nur in Summe mit den IT Personalkosten" verglichen werden dürfen.

Die Behauptung, dass die Software-Kosten für den MF zu hoch seien, ist damit eindeutig widerlegt! Denn bei allen anderen Computer-Architekturen ist die TPP für das zusammen gehörende Tandem bestehend aus der TPP der Middleware und der TPP des IT Personals wesentlich niedriger als beim MF.

Aus diesem Ergebnis könnte man zunächst sogar die These ableiten, dass die SSW für den MF nicht nur nicht zu teuer sondern, wenn man die Preise der Wettbewerber-Lösungen als Maßstab nehmen würde, sogar eindeutig zu niedrig sind. Mit unserem TPP-Modell durchsimuliert ergibt sich nämlich das erstaunliche Ergebnis, dass der MF selbst bei einer Verdoppelung der SSW-Kosten noch eine bessere TPP für SSWK+IT-PK aufweisen würde als die TPP für die SSWK+IT-PK der x86-Server.

Bei unseren Empfehlungen sind wir, unseren Grundsätzen verpflichtet, anspruchsvoller: "Simply the Best" Solution ist einer unserer Unternehmensgrundsätze. Daraus abgeleitet kommen wir zu der Empfehlung, möglichst viele zusätzliche Produktivitäts-Funktionen für den IT Bereich in die Middleware einzubauen in "Winners-only" Realisierungsform. Denn dann kann zusätzlich ein Beitrag geleistet werden zu einer Verminderung des angeblich immer größer werdenden MINT-Fachkräfte-Mangels.

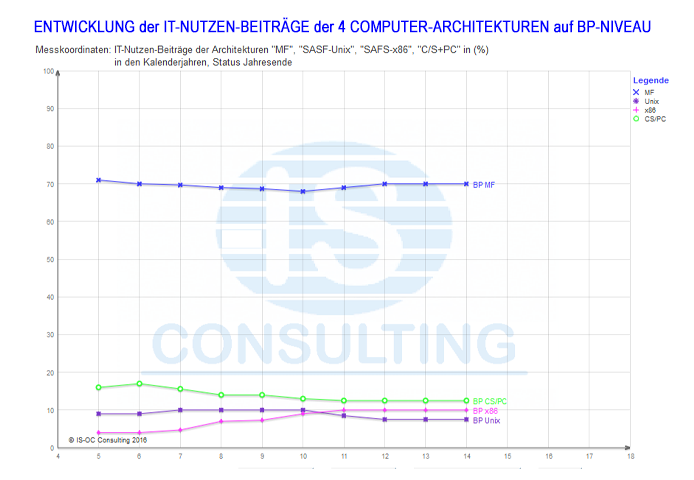

Dieses erstaunliche Zwischenergebnis wirft logischerweise noch die ultimative Frage auf: Bis zu welchem Anteil der Unternehmens-Arbeitslast hat der MF die beste TPP in der dt. VB? Aufgrund unseres umfangreichen IT- und Betriebswirtschafts-Datenmaterials über praktisch alle VU der dt. Versicherungsbranche, das wir seit 26 Jahren zusammen mit unserer "Kollaborativen Community" jährlich aktualisieren, lässt sich diese Frage wie folgt mit ausreichender Genauigkeit beantworten: Der MF bietet im Jahre 2014 in der deutschen Versicherungsbranche im Branchendurchschnitt bei mindestens ca. 70% der Unternehmens-Arbeitslast ohne Data-Warehousing (ca. 5-9% der UAL) die "beste TPP"! (Abb. 6) Eine langjährige Fortschreibung der Best-Practice-Verteilung der Unternehmens-Arbeitslast auf die bis zu 4 Computer-Architekturen in der dt. VB zeigt ein erstaunlich konstantes Bild, bei dem der MF-Anteil fast konstant geblieben ist und in dem die x86-Server etwas Anteil gewonnen und die Unix-Server etwas Anteil verloren haben. (Abb.7)

Um für eine neue Anwendung die Architektur mit dem besten TPP bestimmen zu können, empfehlen wir nach der Typisierung den Vergleich mit einer möglichst ähnlichen, bereits bestehenden Anwendung durchzuführen und die übrig bleibenden Unterschiede mit Abschätzungen auszugleichen. Das Ergebnis sollte abschließend ausführlich Plausibilitäts-geprüft werden!

Wir möchten ausdrücklich darauf hinweisen, dass bei unserem Maßstab eine Plausibilitätskontrolle" Ansatz-immanent vorhanden ist, weil es sich um einen "holistisch/deduktiven Lösungsansatz" handelt, bei dem "Vollständigkeits- und Analogie-Kontrollen" Teil der Vorgehensweise sind. (Siehe auch "Methodischer Ansatz zur Umsetzung") Bei den meisten anderen Maßstäben, wie insbesondere auch beim Maßstab "TCO", ist das nach unserem Erkenntnisstand i.d.R. schon vom methodischen Ansatz her nicht möglich, da es sich praktisch ausschließlich um "induktive Ansätze" handelt. Induktive Ansätze sind übrigens unvermeidbar das Ergebnis beim Einsatz von "Detail-Spezialisten", die "Horizont-beschränkt" nur die bereits beschriebene "Angelsächsische Pragmatik" beherrschen, die bei der Lösung "Strategischen Aufgabenstellungen" grundsätzlich nicht funktioniert!

Erkenntnisse aus anderen Lösungsansätzen zur Kosten-günstigsten Verteilung der Computer-Arbeitslast

Durch Recherchen im Web lässt sich heutzutage relativ einfach ein guter Überblick über die vorhandenen Lösungsbeiträge für eine Fragestellung gewinnen. Beim Thema "Kosten-günstigste Verteilung der IT-Ressourcen auf die derzeit 4 möglichen Computer-Architekturen" ist das Ergebnis erstaunlich dünn! Dabei ist diese Aufgabenstellung nicht nur bereits gegenwärtig sondern v.a. zukünftig von fundamentaler Bedeutung, da für die IT-Verarbeitung zukünftig praktisch nur noch hauptsächlich 2 Architektur-Alternativen zur Verfügung stehen werden: "Mainframes und der "kleine Bruder p-Server" von IBM auf der einen Seite und "x86-Server von Intel, Microsoft/Linux, angeboten Schwerpunkt-mäßig von HP u.a.", auf der anderen Seite. Diese Duopol-Situation prägt immer stärker auch die Argumentation der Computer-Hersteller und der IT-Entscheider bei den Kunden.

Die größte Verbreitung bei IT-Entscheidungen über die Zuordnung neuer Anwendungen zu den Servern der verschiedenen Architekturen hat gegenwärtig der Maßstab TCO (Total Cost of Ownership). Dieser Maßstab versucht die gesamten Kosten, bestehend aus den "direkten IT-Kosten" und den "indirekten Kosten bei den Benutzern", üblicherweise einer Anwendung, über die gesamte Lebensdauer zu bestimmen. In der Praxis werden die TCO-Ergebnisse sehr häufig als zu Interessens-geprägt abgelehnt, weil die Schätzungen häufig sehr fragwürdige Datenannahmen verwenden! Erstaunlich in dieser Situation ist, dass selbst IBM diesen Maßstab in einer angepassten Version verwendet, obwohl die erzielten Ergebnisse der verschiedenen "TCO-Berater-Versionen" den MF meistens als 2. Sieger ausweisen und die Ergebnisse der "IBM TCO-Version" von den Kunden oft nicht akzeptiert werden.

Bemerkenswert erscheint uns in dieser Situation, dass es vermehrt Einzelmessungen gibt, die die mit dem TCO-Maßstab erzielten Ergebnisse eindeutig infrage stellen! Außerdem gibt es schon aus der länger zurückliegenden Vergangenheit zahlreiche Untersuchungen und Beispiele über die Kostenvorteile bei der Konsolidierung von x86-Server-Farmen auf Maiframes: Alle mit eindeutigen, teils sogar ganz erheblichen Kostenvorteilen für den MF. Bei diesen Ergebnissen wurden jeweils aktuelle, eindeutig bestimmbare Daten der Gegenwart verwendet und nicht, wie bei den TCO-Ergebnissen, sehr stark Annahmen-geprägte Daten der Zukunft. Auch diese Ergebnisse stehen in einem eindeutigen Widerspruch zu den üblichen TCO-Ergebnissen!

Beim "Googlen" mit den Suchbegriffen "Vorteile des Mainframe", "Wert des Mainframe", "Zukunft des Mainframe", etc. stößt man auf eine ganze Reihe von fast ausschließlich positiven Beiträgen, die leider aber v.a. Meinungs-geprägt sind und deshalb aus unserer Sicht wenig zur Klärung der fundamentalen Fragestellung beitragen können. Von den Fakten-basierten Beiträgen wollen die folgenden kurz skizzieren:

- IDC White Paper "Der geschäftliche Mehrwert von IBM zEnterprise System", gesponsert von IBM, veröffentlicht mit dem Datum "Juli 2013". "…IDC untersuchte den geschäftlichen Mehrwert, der sich aus der Konsolidierung von Workloads auf IBMs System z ergibt…" "…IDC hat Kunden in Nord- und Südamerika, Europa , Nahost und Afrika (EMEA) und im asiatisch-pazifischen Raum eingehend befragt, um den geschäftlichen Mehrwert jeder Verteilung sowie die Auswirkungen auf die IT und das Unternehmen zu ermitteln..." Highlights: "Senkung der Infrastrukturkosten um 70%", "Verringerung des Arbeitsaufwands für die tägliche Wartung und Instandhaltung der Server um 57%", "5-Jahres-ROI von 501%", Amortisation in 5,3 Monaten", etc.

Kommentar: Diese Ergebnisse entsprechen vom methodischen Ansatz her einer Analyse mit der Fragstellung: "Welches TPP hat eine existierende Anwendung, die gegenwärtig auf einem Server (sehr wahrscheinlich x86-Server) produziert wird, bei Verlagerung auf den MF? Die Ergebnisse sind mit unseren Ergebnissen aus der dt. VB in der Erkenntnis-Tendenz und Eindeutigkeit voll kompatibel! Der Wermutstropfen: "…IDC führte detaillierte Interviews mit sechs Organisationen auf vier Kontinenten…" Kommentar: Leider eine sehr kleine und auch noch sehr inhomogene Datenbasis! Zum Vergleich: Unsere Datenbasis besteht aus "97 IT-Bereichen", "alle aus der homogenen dt. Versicherungsbranche". Und die Qualität der Daten kann außerdem als sehr hoch eingeschätzt werden, da sie von unserer "Kollaborativen Community" stammen und seit 26 Jahren jährlich aktualisiert werden.

- "Technology Economics for Competitive Advantage" von Professor Howard Rubin, Professor Emeritus of Computer Science

Diese Analyse über das Preis/Leistungs-Verhältnis der "verschiedenen Computer-Plattformen" ist nach unseren Recherchen neben der Ausarbeitung von IS-O Consulting die einzige mit einem vom methodischen Ansatz her Erkenntnisse-versprechenden Ergebnis. Denn die Lösungsidee besteht darin, die gesamten IT-Kosten eines Unternehmens ins Verhältnis zu setzen zur Informationsverarbeitungs-Arbeitslast in dem Unternehmen, ausgedrückt in der repräsentativen Größe "Umsatz". Die Lösungs-Hypothese lautet: Wenn die IT-Kosten von Unternehmen einer Branche mit "Mainframe-zentrierter IT" verglichen werden mit den Unternehmen mit "Server-zentrierter IT", dann muss bei vergleichbaren Unternehmen der Preis/Leistungs-Unterschied in Zahlen ausdrückbar zutage treten. Das Ergebnis für das "Insurance Segment", eines von insgesamt 21 untersuchten Segmenten, lautet: Das IT-Preis/Leistungs-Verhältnis der Unternehmen mit "Mainframe-zentrierter IT" ist um ca. 60% besser als das IT-Preis/Leistungs-Verhältnis der Unternehmen mit "Server-zentrierter IT". Die verwendeten IT-Daten stammen von Gartner, wo Herr Rubin, als Senior Advisor beschäftigt war und haben den Status 2010, was die Ergebnisse eher nur gering beeinflussen dürfte.

Bemerkenswert erscheint uns, dass wir bei einer Kombination dieses Methodischen Ansatzes mit unserem Datenmaterial der deutschen Versicherungsbranche mit Status 2014 bei 2 prominenten VU, die aber keine jeweils "Best-Practice"-Positionen einnehmen, zu dem Ergebnis 45% kommen. D.h., das IT-Preis/Leistungs-Verhältnis des Unternehmens mit "Mainframe-zentrierter IT" ist um ca. 45% besser als das IT-Preis/Leistungs-Verhältnis des Unternehmens mit der "x86-Server-zentrierten IT".

Kommentar: Auch dieser Ansatz verwendet nur aktuelles Datenmaterial und kommt zu offensichtlich eindeutigen Ergebnissen zugunsten des Mainframes. Über die Qualität des Datenmaterials kann man sicher diskutieren wie auch über einige Einzel-Schritte des methodischen Ansatzes. In Summe ist das zumindest ein weiterer nachdrücklicher Hinweis, die TCO-Ergebnisse nicht länger zu akzeptieren.

- HP und die Empfehlung von TCO

Dass HP nachdrücklich den Maßstab TCO bei Vergleichen des "Superdome X Servers", dem offensichtlich zukünftigen Haupt-Produkt für das Segment "Unternehmens-Informations-Verarbeitung", empfiehlt, ist bei den erzielten Ergebnissen und der Popularität aus Marketing-Gesichtspunkten legitim, sollte aber dennoch nachdenklich stimmen. In der deutschen Versicherungsbranche gibt es bei größeren VU bisher kein einziges Unternehmen, das x86-Server für den Arbeitslast-Typ "Unternehmensanwendungen" mit der dafür notwendigen umfangreichen Peripherie insbesondere in den Bereichen "Archivierung", "Katastrophen-Vorsorge", "Druckausgabe über Poststraßen" und "Betrieb des TP-Netzes" einsetzt. Insbesondere gibt es auch praktische keine Erfahrung im "komplexen Multiprogramming-Umfeld" mit hunderten parallel-arbeitenden Programmen im Online- und Stapelverarbeitungs-Betrieb. Da nach gegenwärtiger Erkenntnis die max. Leistungsfähigkeit selbst eines max. ausgebauten x86-Systems mit 256 Cores für kommerzielle Arbeitslast bei max. 10% der Leistungsfähigkeit eines z13 MF von IBM einzuschätzen ist, wären für den Betrieb der Unternehmensanwendungen anstelle von üblicherweise 2 MF eine größere Anzahl von x86-Servern notwendig. Wie so ein "Multi-Server-Komplex" in der Praxis mit welchem Aufwand und ev. auch Einschränkungen zu betreiben ist, ist in der dt. VB bisher unbekannt. Hoch interessant dürfte auch die Antwort auf die Frage sein, welche Ergebnisse der Maßstab TCO in einem "x86-Multi-Server-Komplex-Verarbeitungs-Umfeld" anbietet.

- Hinweis: Wegen der Bedeutung des Themas, des dringenden Entscheidungs-Erkenntnisbedarfes und auch wegen der intellektuellen Attraktivität gedenken wir uns zukünftig intensiver mit dieser Aufgabenstellung zu befassen.

"Bisheriger Wertbeitrag" der IT und "Potential bis Best-Benefit"

Die Frage nach dem bisherigen Wertbeitrag der Informationsverarbeitung sieht auf den ersten Blick aus wie eine ziemlich akademisch-geprägte Fragestellung: Denn welche Entscheidungserkenntnisse lassen sich aus der Beantwortung für die IT-Verantwortlichen ableiten? Offensichtlich keine unmittelbaren.

Betrachtet man die Fragestellung jedoch aus dem Blickwinkel von Nicht-IT-Führungskräften und kombiniert man sie mit der allen Interessierten sofort verständlichen und bekannten Kennzahl der hohen IT-Unternehmens-Kosten z.B. in Gestalt des IT-Budgets, dann wird aus der fehlenden Antwort auf die Fragestellung immer häufiger zumindest ein Problem für das zukünftige Wachstum der IT. Hinzu kommt, dass seit etwa 2015 insbesondere in den Versicherungs- und Banken-Branchen die These von der Lösung der Branchen-Probleme insbesondere durch die „Digitalisierung“ populär geworden ist. Muss das beim „Nicht-IT-Fachmann“ nicht zu dem Eindruck führen, dass die IT-Bereiche in der Vergangenheit einen für die Unternehmen nur unbedeutenden Wertbeitrag abgeliefert haben und dass das in Zukunft radikal besser werden muss?

Wenn sich die Situation in einzelnen Unternehmen dergestalt zuspitzt, warum tut sich die zuständige IT dann so schwer den bisherigen Wertbeitrag der IT als Antwort auf die IT-Unternehmens-Kosten zu finden? Denn scheinbar braucht die IT doch nur die allseits bekannten IT-Nutzen-Aussagen der IT-Projekte aufzusummieren. Leider nur scheinbar! Denn um den gesamten IT-Unternehmens-Nutzen zusammenzutragen müssten die Daten der Projekte der letzten ca. 10 Jahre akkumuliert werden mit Aktualisierung auf denselben Zeitpunkt, unter Berücksichtigung der IT-Infrastruktur-Maßnahmen und unter Abzug der Überschneidungen in den Projekten. Schon diese Aufzählung führt zu der Erkenntnis, dass diese Anforderungen nicht umsetzbar sind. Denn bei der hier beschriebenen Aufgabenstellung handelt es sich offensichtlich um keine Addition sondern um eine Integration. Und Integrationen sind bekanntlich nur für relativ einfache Aufgabenstellungen möglich. Die hier skizzierte Aufgabenstellung ist aber offensichtlich alles andere als einfach.

Also stellt sich die Frage nach einer realisierbaren Alternative. Und auch dafür bietet unser Methodischer Lösungsansatz eine Antwort. Denn die real-existierende Situation der großen Unterschiede bei der IT-Unterstützung der Beschäftigten in den verschiedenen Unternehmen stellt genauer betrachtet auch eine "Zeitreise in die IT-Entwicklung" insbesondere bei den IT-Anwendungen dar: Die "Best-Practice/Benefit-Unternehmen" sind den "Worst-Practice/Benefit-Unternehmen" offensichtlich um viele Jahre und einen erheblichen IT-Unternehmens-Nutzen-Niveau-Unterschied voraus! Nach unserer Einschätzung müssten die Worst-Practice/Benefit-Unternehmen u.a. mehr als 90% ihrer Anwendungen erneuern, um das IT-Nutzen-Niveau der Best-Practice/Benefit-Unternehmen zu erreichen. Das dürfte mindestens 10 Jahre in Anspruch nehmen: Ein erstes Erkenntnis-Element.

Dieses Erkenntnis-Element lässt sich mit unserem MLA zum folgenden Erkenntnis-Gewinnungs-Ansatz ausbauen: Ausgangssituation ist unser holistisches Start-Diagramm mit der Korrelation "IT-Personal-Kosten-Quote vs IT-Ressourcen-Einsatz pro Mitarbeiter". Aus der Streuung von z.B. in der deutschen Versicherungsbranche mit Status 2014 von IT-Faktor ca. 3,9 ergibt sich ein substanzieller Hinweis über den Wertbeitrag der IT in etwa 10 Jahren von etwas mehr als Produktivitäts-Faktor 2. Da wir den Branchendurchschnitt durch eine Kurve darstellen können, können wir diese Kurve natürlich auch in die Vergangenheit extrapolieren, was ansonsten eher unüblich ist. Und da wir diese Korrelationen seit 1990 Jahr für Jahr aktualisiert haben, können wir für unsere Extrapolation in die Vergangenheit zusätzlich auf die Entwicklungserkenntnisse von ca. 26 Jahren zurückgreifen.

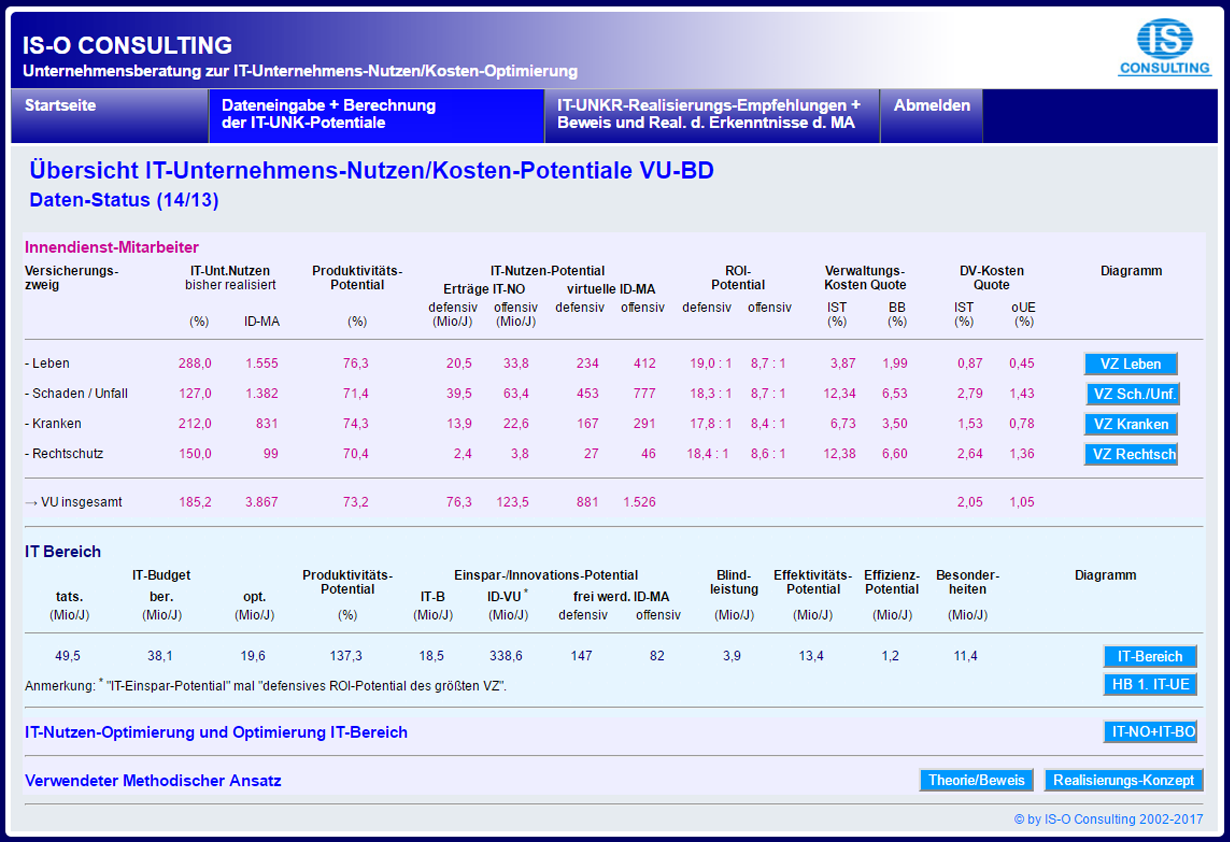

Als Erkenntnisse über den bisherigen Wertbeitrag der IT und das Potential für den zukünftig möglichen Wertbeitrag der IT für die Unternehmen liefert unser Methodischer Lösungsansatz für die deutsche Versicherungsbranche, differenziert auf die Versicherungszweige, für die 2 mit Abstand größten Versicherungszweige die folgenden Werte:

- Bisheriger Wertbeitrag im Branchendurchschnitt (2014) / Potential bis BP im Versicherungszweig Lebensversicherung:

- Produktivitäts-Fortschritt: 265% / 460%

- ROI: 11:1 / ~5:1

- Bisheriger Wertbeitrag im Branchendurchschnitt (2014) / Potential bis BP im Versicherungszweig Schaden/Unfall-Versicherung:

- Produktivitäts-Fortschritt: 165% / 315%

- ROI: 10:1 / ~5:1

Die Prognose für den Wertbeitrag der IT in den Unternehmen von der IST-Situation bis auf das Niveau "real-existierende Best-Practice/Benefit" ist Teil unseres Methodischen Lösungsansatzes. Prognosen über reBP darüber hinaus, z.B. bis "BP aus Einzel-Optimierung" oder "BP westliche Welt" sind mit unserem MLA ebenfalls möglich, aber mit einem größeren Genauigkeits-Risiko behaftet. Einen repräsentativen Überblick haben wir im Kapitel (Auswahl repräsentativer IT-Unternehmens-Nutzen/Kosten-Potential-Kennzahlen) veröffentlicht.

Für andere Branchen gelten nach unseren Erkenntnissen vergleichbare Zusammenhänge.

Zusammenfassende Erkenntnisse zum IT-Wertbeitrag: Der Wertbeitrag der IT für die Unternehmen war bisher überragend profitabel und sehr wahrscheinlich wesentlich besser als der vieler anderer Unternehmens-Investitionen. Und auch die IT-Investitionen in den nächsten Jahren werden voraussichtlich hoch profitabel bleiben.

Die IT-Unternehmens-Nutzen/Kosten-Zielgröße "Best-Practice"

Best-Practice ist eine Ersatz-Zielgröße mit dem Hautgout des gemeinen Praktikers, der sich scheinbar vorschnell mit einer einfachen Lösung zufrieden gibt. Dieser abwertenden Einschätzung möchten wir nach langjähriger Beschäftigung mit dieser Zielgröße nachdrücklich entgegentreten. Denn die angeblich hochwertige Zielgröße, die insbesondere den Fachleuten der Informationsverarbeitung seit vielen Jahrzehnten ganz schnell über die Lippen kommt, heißt "State-of-the-Art": Klingt anspruchsvoll ist in der IT semantisch aber absolut undefiniert! Ein reiner Propaganda-Begriff des IT-Marketings. Was sind dann aber die Alternativen?

Nicht wenige und insbesondere von der deutschen Kultur Geprägte werden nun versucht sein, einem wissenschaftlichen Ansatz den Vorzug zu geben. Und dieser ist bei einigem systematischen Räsonieren auch zu finden. Wir wollen ihn den "absoluten Lösungs-Ansatz" nennen. Für seine Realisierung müsste die folgende Vorgehensweise eingeschlagen werden: Bei einem absoluten Ansatz muss man den IT-Aufwand in einem Unternehmen ins Verhältnis setzen mit den benötigten Mitarbeitern für die algorithmisierbare Informationsverarbeitung in diesem Unternehmen. Um zu der Erkenntnis von einem "optimalen Mischungsverhältnis von Human-und Computer-Ressourcen" zu gelangen, müssen die Computer-Ressourcen in diskreten Schritten gesteigert und für jeden Schritt die dafür benötigten Human-Ressourcen bestimmt werden. Spätestens an dieser Vorgehensposition dieses Lösungsansatzes wird jeder Praktiker zu dem Urteil gekommen sein, dass dieser absolute Ansatz zu nicht mehr taugt als zu einer vielleichten interessanten Gedankenspielerei, da die jeweiligen Human-Ressourcen nicht bestimmbar sind.

Die Zielgröße "IT-Best-Practice" als Stellvertreterin für die Zielgröße "IT-Optimierung" ist schon deshalb von hohem Wert, da sie das höchste Niveau der Erkenntnisse der "Evidenz/Praxis-basierten, kollektiven Intelligenz einer repräsentativen Gruppe von Praktikern" darstellt. Die Zielgröße "Best-Practice" ist dabei eine Sammelbezeichnung für eine Vielzahl spezieller Zielgrößen, wie "Best-Benefit" für die Zielgröße "IT-Unternehmens-Nutzen-Maximierung", "Minimal-IT-Cost" für die Zielgröße "IT-Unternehmens-Kosten-Minimierung" durch Realisierung der Besten Umsetzungs-Effizienz mit der Unterzielsetzung "Best TPP" als Zielgröße für die "optimale Verteilung der eingesetzten IT-Ressourcen über die 4 Computer-Architekturen", um nur einige der mit diesem MLA verfügbar werdenden Best-Practice-Zielgrößen zu benennen.

In der deutschen Versicherungsbranche z.B. würde eine Verbesserung des IT-Einsatzes beim "durchschnittlichen Versicherungsunternehmen" auf das Niveau der "real-existierenden BP" bereits zu einer Erhöhung der Produktivität um ca. 68% führen.

Zum besseren Verständnis der Erkenntniswerthaltigkeit dieser Zielgröße möchten wir darauf aufmerksam machen, dass in letzter Zeit in einem ganz anderen Fachgebiet ein methodisch vergleichbarer Lösungsansatz starke Beachtung erfährt, nämlich die "Eevidenz-basierte medizinische Behandlung". Sie basiert auf einem RCT-Ansatz (Randomized Controlled Trial) zum Herausfiltern der "bisher erkannten Besten Behandlungsergebnisse". Ob bei diesem Ansatz, bei dem die Größe der Datenbasis unbekannt ist und die Suchbegriffe undefiniert sind, immer die Best-Practice-Ergebnisse gefunden werden, ist offensichtlich nicht bestimmbar und statistisch betrachtet eher unwahrscheinlich. Dennoch teilen wir die Einschätzung, dass auch bei diesem Lösungsansatz, der interessanterweise v.a. von jüngeren Ärzten geschätzt wird, der Erkenntnisfortschritt dennoch erheblich sein dürfte.

Mit diesem medizinischen Ansatz verglichen stellt der von uns schon vor über 25 Jahren entwickelte Methodische Lösungsansatz höchstwahrscheinlich erheblich bessere Erkenntnisse zur Verfügung: Denn er verwendet "möglichst vollständige Sample, d.h. die Domäne eines Sachgebietes", in denen dann auch mit sehr großer Wahrscheinlichkeit die "Best-Practice-Lösungen", höchstwahrscheinlich aber zumindest die „Second-Best-Practice-Lösungen“ enthalten sein dürften. Der Ansatz ist des Weiteren 2-dimensional, wodurch die Erkenntnisse zu einer Kurve verdichtet werden können, die präzisere Erkenntnisse zur Verfügung stellt. Und das gefundene Niveau Best-Practice kann durch die Anzahl und Position der in diesem Bereich angesiedelten, exklusiven Lösungen und den Kurvenverlauf in diesem Bereich auf Qualität und Repräsentanz überprüft werden. Insgesamt betrachtet dürfte der von uns entwickelte Ansatz eine Spitzenposition im Angebot für IT-Unternehmens-Nutzen/Kosten-Potential-Erkenntnisse einnehmen.

Aufgrund der Struktur unseres MLA ist es möglich, noch näher an das "Erkenntnis-Niveau IT-Optimierung" zu gelangen. Dazu lässt sich das Best-Practice-Basis-Erkenntnis-Niveau

- "BP real-existierende Unternehmen" (reBP)

- "Best-Practice aus Einzel-Optimierung" (BPeO)

Diese Zielgröße gewinnt man, wenn man die IT-Optima der einzelnen Teil-Bereiche oder Geschäftsprozesse miteinander kombiniert: Das ist i.d.R. zulässig, da die IT-Optimierung der einzelnen Teil-Bereiche oder Geschäftsprozesse unabhängig voneinander möglich ist. Und schließlich auf dem Niveau - "BP westliche Welt" (BPwW), natürlich wieder in beiden Ausführungen.

Die Zielgrößen BPeO und BPwW sind insbesondere für Unternehmen auf dem Niveau reBP sehr interessant, da auf deren Niveau das Erkennen weiterer Potentiale wesentlich herausfordernder ist als bei den Unternehmen auf Durchschnitts-Niveau.

Die Best-Practice-Zielsetzungen gibt es in 2 grundsätzlich unterschiedlichen Zielrichtungen:

- Als IT-Effektivitäts-BP oder IT-Nutzen-BP und

- IT-Effizienz-BP oder IT-Kosten-BP

Selbstverständlich bleibt die Zielgröße "State-of-the-Art-Optimum" die Wunsch-Zielgröße. Daraus ergibt sich natürlich sofort die Frage, wer zuständig ist für ihre Zurverfügungstellung. Und die Antwort liegt aus der Sicht der Computer-Industrie auf der Hand und lautet: Der forschende Teil der Wirtschaftsinformatik! Doch wie soll die das in absehbarer Zeit zustande bringen, wenn sie immer noch in der Welt des IT-Paradoxons lebt? (siehe auch Kapitel: Realisierung des maximalen IT-Unternehmens-Nutzens)

An dieser Stelle muss noch darauf hingewiesen werden, dass es einen fundamentalen semantischen Unterschied gibt zwischen den Bezeichnungen "Best-Practice" und "Best-Practices", die häufig auch in der Fachpresse als angeblich gleichwertig verwendet werden! "Best Practices" wird z.B. von SAP der "Status von SAP-Lösungen" beim Kunden genannt, wenn dabei die von SAP vorgegebenen Implementierungsempfehlungen vollständig realisiert worden sind. In wieweit diese Lösungen auch "Best-Practice" darstellen, bleibt dabei völlig unbeantwortet.

Auswahl repräsentativer IT-Unternehmens-Nutzen/Kosten-Potential-Kennzahlen

Unternehmens-Kennzahlen repräsentieren die komprimierteste Form von Führungserkenntnissen: Sie werden u.a. in Geschäftsberichten an prominenter Stelle - üblicherweise auf der Rückseite des Deckblattes des Geschäftsberichtes - und im Wirtschaftsteil der Tageszeitungen oder allgemein ausgedrückt der zusammenfassenden Berichterstattung verwendet. Sie sind üblicherweise für den Aufsichtsrat, für Investoren oder ähnliche Interessentengruppen bestimmt und liefern einen prägnanten Überblick über den Erfolg (Misserfolg) eines Unternehmens, insbesondere im Zeitraum des letzten Geschäftsjahres, häufig zusätzlich über den Zeitraum der letzten 2, 3 oder auch 5 Jahre.

Die Unternehmens-Kennzahlen lassen sich grundsätzlich in 2 Bereiche untergliedern: In Kennzahlen, die den "Aufwand zur Erzielung des Erfolges" darstellen und Kennzahlen, die den "Aufwand zur Erzielung des Erfolges" beschreiben. Typische Größen zur Darstellung der ultimativen Zielsetzung eines Unternehmens, nämlich des Erfolgs des Unternehmens, sind der "Gewinn", die "Verzinsung des eingesetzten Kapitals", der "Unternehmensumsatz" und da insbesondere die "Umsatzsteigerung" und des Weiteren einige Branchen-typische Kennzahlen, wie die "Anzahl produzierter Produkte", z.B. in der Automobil-Branche die Anzahl Automobile der verschiedenen Baureihen. Der "unvermeidliche" Aufwand zur Erzielung des Unternehmenserfolges, üblicherweise auch "eher abwertend" Herstellungs-Kosten genannt, wird offensichtlich "uneuphorisch" veröffentlicht, da er als "notwendiges Übel in Erscheinung tritt", das augenscheinlich insbesondere den Gewinn schmälert. (Zu den IT-Unternehmens-Kennzahlen)

Gegenwärtig übliche IT-Kennzahlen

Auch die Darstellung der IT-Kennzahlen, wie sie insbesondere in den Geschäftsberichten outgesourceder IT-Bereiche und am Beginn von Vorträgen von IT-Mitarbeitern verwendet werden, sind i.d.R. unterteilt in "Kaufmännische Kennzahlen" und "Technische Kennzahlen". Als Kaufmännische Kennzahlen aufgeführt sind meist: "Umsatzerlöse", "Investitionen" und die "Anzahl IT-Mitarbeiter". Als Technische Kennzahlen werden benannt: Die "Rechnerkapazität in MIPS" für die Leistungsfähigkeit der eingesetzten Mainframe-Computer für die "Unternehmens-Anwendungen", die "Anzahl Server" für die Leistungsfähigkeit der Computer für "Spezielle und Abteilungs-Anwendungen" und die "Anzahl PC" für die Benutzerfreundlichkeit der IT an der Schnittstelle zu den Anwendern. Ergänzt wird diese "unmittelbare" Angabe "der gesamten theoretischen Leistungsfähigkeit" der im Unternehmen eingesetzten Computer durch "mittelbare", ergänzende Angaben, wie "eingesetzte Speicherkapazität in TB" und bemerkenswerterweise um indirekt IT-Unternehmens-Nutzen-beschreibende Angaben, wie "Anzahl gedruckter Seiten pro Jahr" und "Anzahl Transaktionen pro Tag".

Und damit sind wir im Rahmen der Erkenntnisgewinnung über die gegenwärtige Darstellung des Unternehmensnutzen-Beitrags der eingesetzten Computer bei einem zentralen Problem der Informationsverarbeitungsbranche im Allgemeinen und der Informationsverarbeitungs-Abteilungen der Unternehmen im Besonderen angelangt: Alle diese primären IT-Kennzahlen sind nur Aufwands- bzw. Kosten-Kennzahlen! Auch die schönfärberisch als Kaufmännische Kennzahlen benannten: Denn selbst die als "Umsatzerlöse" bezeichnete Kennzahl ist bei genauer Betrachtung eine Kostenkennzahl: Sie hat ihre Basis praktisch immer in einer Umfirmierung der entstandenen IT-Produktion-Kosten des outgesourceden IT-Bereiches in Umsatz im Sinne der aufgestellten Gewinn & Verlustrechnung. Diese werden i.d.R. dem Hauptauftraggeber oder Mutter-Unternehmen, ergänzt durch einen geringen Gewinn-Aufschlag, in Rechnung gestellt. Das hat mit der Substanz eines im Wettbewerb am Markt erzielten Umsatzes rein gar nichts gemein! Das heißt zusammengefasst wie bereits ausführlich diskutiert: Die Informationsverarbeitungs-Fachleute in den Unternehmen können auch nach ca. 60 Jahren Existenz der IT allenfalls die Unternehmenskosten der IT "skizzieren", nicht aber den IT-Unternehmens-Nutzen betriebswirtschaftlich qualifiziert zur Darstellung bringen!

Und selbst diese Kosten-Darstellung hat fundamentale Schwächen: Die verwendeten Einzelelemente der IT-Kosten sind eher willkürlich ausgewählte Messgrößen, da es bisher dafür keinen "normierten Kennzahlen-Satz" gibt oder auch nur eine allgemein anerkannte Ausformung. Die fundamentale Schwäche der bisher verwendeten Technischen Kennzahlen liegt aber insbesondere darin, dass nur die "theoretische Leistungsfähigkeit der eingesetzten Computer" mit oft "oberflächlichen Definitionen", wie z.B. nur der "Anzahl Server" verwendet werden, ohne die viel wichtigere Angabe der realisierten "tatsächlich Unternehmensnutzen stiftenden Computer-Arbeit". Dazu bedarf es, wie wir bereits ausführlich dargestellt haben, der Kombination der theoretischen Leistungsfähigkeit der eingesetzten Computer mit den wesentlichen, den IT-Unternehmensnutzen produzierenden Aktivierungskriterien der Leistungsfähigkeiten, v.a. mit der "Leistungsfähigkeit der Server in Abhängigkeit der Anzahl Prozessoren oder Cores", der "Betriebszeit der einzelnen Computer pro Tag", der "durchschnittlichen Auslastung der einzelnen Computer", der "Wertigkeit der Arbeitslast auf den einzelnen Computern" und dem "Verwaltungs-Overhead bei den verschiedenen Computer-Architekturen". Erst durch die Aktivierung der theoretischen Leistungsfähigkeiten entsteht der IT-Unternehmens-Nutzen. Diese Einflussgrößen sind bei den gegenwärtig üblicherweise 3 eingesetzten Computer-Plattformen mit Computern von bis zu 4 verschiedenen Architekturen nicht nur extrem verschieden, sie werden in der Praxis bei den verschiedenen Unternehmen auch sehr unterschiedlich aktiviert! D.h. zusammengefasst: Auf die "Computer-Netto-Nutzen-Produktion", d.h. die "realisierte Computer-Arbeit", kommt es an, nicht auf die "Computer-Brutto-Leistungsfähigkeit", denn nur sie produziert den Unternehmens-Nutzen der IT! Oder: "Wichtig ist, was hinten rauskommt!" (Der "Erzeuger" dieser Weisheit dürfte allgemein bekannt sein). (Zu den IT-Unternehmens-Kennzahlen)

Notwendige Kennzahlen zur IT-Unternehmens-Nutzen/Kosten-Optimierung

Damit sind wir bei der spannenden Frage angelangt: Mit welchen repräsentativen Kennzahlen lässt sich der IT-Unternehmens-Nutzen mit bester Aussagekraft zur Darstellung bringen? Und unsere Antwort darauf lässt sich wie folgt formulieren: Mit dem von uns entwickelten Methodischen Lösungsansatz entstehen Kennzahlen zur IT-Unternehmens-Nutzen/Kosten-Optimierung System-immanent "in allen sinnvollen Ausprägungen".

1) IT-Unternehmens-Nutzen-Kennzahlen zur "globalen Bewertung des IT-Einsatzes" in den UnternehmenWir haben einen Satz der nach unserer Erfahrung Aussage-stärksten IT-Unternehmens-Nutzen-Kennzahlen entwickelt und stellen sie unseren Klienten zur Verfügung. Dazu gehören v.a.

- "Unausgeschöpftes IT-Produktivitäts-Potential" in "Prozent" mit Übersetzung in "Arbeitsplatz-Kosten-Einspar-Potential für das Unternehmen" und "Anzahl Mitarbeiter" relativ zu den deutschen "real-existierenden Best-Practice-Unternehmen".

- "Bisher realisierte IT-Produktivität" in "Prozent" mit Übersetzung in "Arbeitsplatz-Kosten-Einsparungen für das Unternehmen" und "Anzahl substituierter Mitarbeiter".

- "ROI" für das "unausgeschöpfte IT-Produktivitäts-Potential" und für die "bisher realisierte IT-Produktivität".

Der Nutzen im IT-Bereich besteht immer aus Einsparungen bei der Produktion der zur Realisierung des IT-Unternehmens-Nutzen-Niveaus benötigten IT-Ressourcen. Die wichtigste Nutzen-Kennzahl für den IT-Bereich ist damit das

- "IT-Budget-Einspar-Potential" in "Euro" bei Realisierung auf dem Niveau der deutschen "IT-Best-Practice-Unternehmen aus Einzel-Optimierung".

- "Unausgeschöpftes Produktivitäts-Potential im IT-Bereich" in "Prozent" mit Übersetzung in "Arbeitsplatz-Kosten-Einspar-Potential für den IT-Bereich" und "Anzahl benötigter IT-Mitarbeiter" relativ zu den deutschen "IT-Best-Practice-Unternehmen aus Einzel-Optimierung", unterteilt in

- "Effektivitäts-Potential" in "Prozent" und "Arbeitsplatz-Kosten-Einspar-Potential für den IT-Bereich" und

- "Effizienz-Potential" in "Prozent" und "Kosten-Einspar-Potential für den IT-Bereich", dazu gehört insbesondere auch „optimale Verteilung der Arbeitslast auf die bis zu 4 Computer-Architekturen“

- "Kosten verursacht durch Nutzen-lose IT-Blind-Leistung".

- "Kosten verursacht durch "Besonderheiten" im IT-Umfeld".